Большие данные

Эта статья посвящена большим коллекциям данных. Информацию о полосе смотрите в разделе большие данные (band) . Для покупки и продажи персональных и потребительских данных см. раздел капитализм надзора .

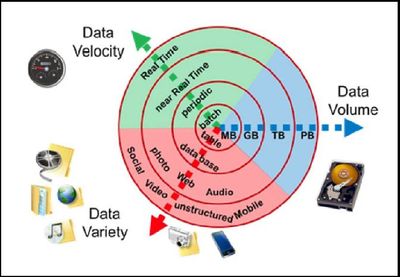

"Большие данные" -это область, в которой рассматриваются способы анализа, систематического извлечения информации из наборов данных, которые являются слишком большими или сложными для работы с традиционным прикладным программным обеспечением для обработки данных . Данные с большим числом наблюдений (строк) обеспечивают большую статистическую мощность , в то время как данные с большей сложностью (больше атрибутов или столбцов) могут привести к более высокой частоте ложного обнаружения . большие проблемы с данными включают захват данных, хранение данных, анализ данных, поиск, совместное использование, передачу, визуализацию, запрос, обновление, конфиденциальность информации и источник данных. Большие данные первоначально ассоциировались с тремя ключевыми понятиями: объем , разнообразие и скорость . Когда мы обрабатываем большие данные, мы можем не отбирать образцы, а просто наблюдать и отслеживать, что происходит. Поэтому большие данные часто включают в себя данные с размерами, которые превышают возможности традиционного обычного программного обеспечения для обработки в течение приемлемого времени и значение.

В настоящее время термин "большие данные" обычно используется для использования прогнозной аналитики , аналитики поведения пользователей или некоторых других методов расширенной аналитики данных , которые извлекают значение из данных, и редко для конкретного размера набора данных. "Нет никаких сомнений в том, что количество доступных в настоящее время данных действительно велико, но это не самая важная характеристика этой новой экосистемы данных." Анализ наборов данных позволяет находить новые корреляции с " точечными тенденциями развития бизнеса, предотвращать заболевания, бороться с преступностью и так далее." ученые, руководители предприятий, практикующие врачи, реклама и правительства также регулярно сталкиваются с трудностями при работе с большими массивами данных в таких областях , как поиск в Интернете , финтех , городская информатика и бизнес-информатика . Ученые сталкиваются с ограничениями в электронной научной работе, включая метеорологию, геномику, коннектомику, сложные физические моделирования, биологию и экологические исследования.

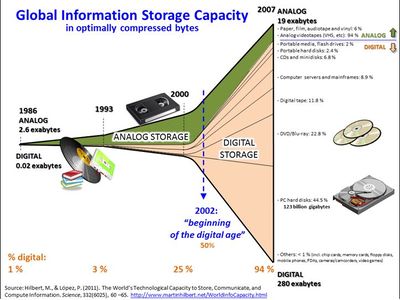

Наборы данных быстро растут, отчасти потому , что они все чаще собираются дешевыми и многочисленными информационно-зондирующими устройствами Интернета вещей, такими как мобильные устройства, антенны ( дистанционное зондирование), журналы программного обеспечения, камеры, микрофоны, считыватели радиочастотной идентификации (RFID) и беспроводные сенсорные сети .[10] мировой технологический потенциал на душу населения для хранения информации примерно удвоился каждые 40 месяцев с 1980-х годов; по состоянию на 2012 каждый день генерируется 2,5 экзабайта (2,5×10 18 ) данных. Основываясь на прогнозе отчета IDC, глобальный объем данных будет расти экспоненциально с 4,4 зеттабайт до 44 зеттабайт между 2013 и 2020 годами. к 2025 году IDC прогнозирует, что будет 163 зеттабайта данных. одним из вопросов для крупных предприятий является определение того, кто должен владеть инициативами в области больших данных, которые влияют на всю организацию.

Системы управления реляционными базами данных, статистика рабочего стола [ требуется разъяснение] и программные пакеты, используемые для визуализации данных, часто испытывают трудности с обработкой больших данных. Эта работа может потребовать "массового параллельного программного обеспечения, работающего на десятках, сотнях или даже тысячах серверов". То, что квалифицируется как "большие данные", зависит от возможностей пользователей и их инструментов, а расширяющиеся возможности делают большие данные движущейся целью. "Для некоторых организаций, впервые столкнувшихся с сотнями гигабайт данных, может возникнуть необходимость пересмотреть варианты управления данными. Для других это может занять десятки или сотни терабайт, прежде чем размер данных станет существенным фактором."

Определение[править]

Этот термин используется с 1990-х годов, причем некоторые отдают должное Джону Мэши за популяризацию этого термина. Большие данные обычно включают в себя наборы данных с размерами, выходящими за пределы возможностей обычно используемых программных средств для сбора , хранения , управления и обработки данных в течение приемлемого истекшего времени. философия больших данных охватывает неструктурированные, полуструктурированные и структурированные данные, однако основное внимание уделяется неструктурированным данным.Big data "size" - это постоянно движущаяся цель, начиная с 2012 в диапазоне от нескольких десятков терабайт до многих зеттабайт данных. Большие данные требуют набора методов и технологий с новыми формами интеграции, чтобы выявить идеи из наборов данных, которые разнообразны, сложны и масштабны.

В определении 2016 года говорится ,что"большие данные представляют собой информационные активы, характеризующиеся таким большим объемом, скоростью и разнообразием, что для их преобразования в ценность требуются конкретные технологии и аналитические методы". аналогичным образом, Каплан и Хенлейн определяют большие данные как "наборы данных, характеризующиеся огромным количеством (объемом) часто обновляемых данных (скоростью) в различных форматах, таких как числовые, текстовые или изображения/видео (разнообразие)." кроме того, некоторые организации добавляют новый V, достоверность , чтобы описать его, пересмотр оспаривается некоторыми отраслевыми органами власти. Три Vs (объем, разнообразие и скорость) были дополнительно расширены до других дополнительных характеристик больших данных:

- Машинное обучение : большие данные часто не спрашивает, почему и просто обнаруживает закономерности

- Цифровой след: большие данные часто являются бесплатным побочным продуктом цифрового взаимодействия [ требуется лучший источник]

В определении 2018 года говорится: "большие данные-это то, где параллельные вычислительные средства необходимы для обработки данных", и отмечает: "это представляет собой отчетливое и четко определенное изменение в используемой компьютерной науке с помощью теорий параллельного программирования и потерь некоторые из гарантий и возможностей, предоставляемых реляционной моделью Codd ."

Растущая зрелость концепции более резко очерчивает разницу между "большими данными" и "бизнес-аналитикой":

- Бизнес-аналитика использует описательную статистику с данными с высокой информационной плотностью для измерения вещей,выявления тенденций и т. д.

- Большие данные используют индуктивную статистику и понятия из идентификации нелинейных систем для вывода законов (регрессий, нелинейных связей и причинно-следственных эффектов) из больших наборов данных с низкой информационной плотностью для выявления связей и зависимостей или для выполнения предсказаний результатов и поведения. [рекламный источник?]

Характеристики[править]

Большие данные могут быть описаны следующими характеристиками:

Объем

- Количество генерируемых и хранимых данных. Размер данных определяет ценность и потенциальную проницательность, а также может ли он считаться большими данными или нет.

Разнообразие

- Тип и характер данных. Это помогает людям, которые анализируют его, эффективно использовать полученное понимание. Большие данные черпают из текста, изображений, аудио, видео; Кроме того, он завершает недостающие части через слияние данных.

Скорость движения

- В этом контексте, скорость, с которой данные генерируются и обрабатываются для удовлетворения потребностей и проблем, которые лежат на пути роста и развития. Большие данные часто доступны в режиме реального времени. По сравнению с малыми данными большие данные производятся более постоянно. Два вида скорости, связанные с большими данными, - это частота генерации и частота обработки, записи и публикации.

Достоверность

- Это расширенное определение для больших данных, которое относится к качеству данных и значению данных. качество данных захваченных данных может сильно варьироваться, что влияет на точный анализ.

Данные должны быть обработаны с помощью современных инструментов (аналитики и алгоритмов), чтобы выявить значимую информацию. Например, для управления фабрикой необходимо учитывать как видимые, так и невидимые проблемы с различными компонентами. Алгоритмы генерации информации должны обнаруживать и решать невидимые проблемы, такие как деградация машины, износ компонентов и т. д. на заводском этаже.

Архитектура[править]

Хранилища больших данных существовали во многих формах, часто создаваемых корпорациями с особой потребностью. Коммерческие поставщики исторически предлагали параллельные системы управления базами данных для больших данных, начиная с 1990-х гг. В течение многих лет WinterCorp опубликовала самый большой отчет по базам данных. [рекламный источник?]

Teradata Corporation в 1984 году выпустила на рынок систему параллельной обработки DBC 1012. Teradata systems были первыми, кто сохранил и проанализировал 1 терабайт данных в 1992 году. Жесткие диски были 2,5 ГБ в 1991 году, поэтому определение больших данных непрерывно развивается в соответствии с законом Крайдера. Teradata установила первую систему на основе СУБД класса petabyte в 2007 году. По состоянию на 2017 , здесь установлено несколько десятков петабайтных реляционных баз данных класса Teradata, самая большая из которых превышает 50 ПБ. Системы до 2008 года были на 100% структурированными реляционными данными. С тех пор Teradata добавила неструктурированные типы данных, включая XML, JSON и Avro.

В 2000 Году Seisint Inc. (теперь LexisNexis Risk Solutions) разработал распределенную платформу на основе C++для обработки данных и запросов, известную как системы HPCC Платформа. Эта система автоматически распределяет, распределяет, хранит и поставляет структурированные, полуструктурированные и неструктурированные данные на нескольких товарных серверах. Пользователи могут писать конвейеры обработки данных и запросы на декларативном языке программирования потока данных, называемом ECL. Аналитики данных, работающие в ECL, не обязаны заранее определять схемы данных и могут скорее сосредоточиться на конкретной текущей проблеме, изменяя данные наилучшим образом по мере разработки решения. В 2004 году LexisNexis приобрела Seisint Inc. и их высокоскоростная платформа параллельной обработки и успешно использованная эта платформа для того чтобы интегрировать системы данных Choicepoint Inc. когда они приобрели эту компанию в 2008 году. в 2011 году платформа hpcc systems была с открытым исходным кодом под лицензией Apache v2.0.

ЦЕРН и другие физические эксперименты собирали большие наборы данных в течение многих десятилетий, обычно анализируемые с помощью высокопроизводительных вычислений (суперкомпьютеров), а не с помощью архитектуры сокращения товарных карт, обычно подразумеваемой нынешним движением "больших данных".

В 2004 году Google опубликовала статью о процессе под названием MapReduce, который использует аналогичную архитектуру. Концепция MapReduce предоставляет модель параллельной обработки, и соответствующая реализация была выпущена для обработки огромных объемов данных. С помощью MapReduce запросы разбиваются и распределяются по параллельным узлам, а затем обрабатываются параллельно (шаг Map). Затем результаты собираются и доставляются (шаг сокращения). Фреймворк был очень успешным, [46] поэтому другие хотели повторить алгоритм. Таким образом, реализация фреймворк MapReduce был принят открытым исходным кодом проекта Apache под названием Hadoop . Apache Spark был разработан в 2012 году в ответ на ограничения в парадигме MapReduce, поскольку он добавляет возможность настройки многих операций (а не только map с последующим уменьшением).

MIKE2. 0-это открытый подход к управлению информацией, который признает необходимость пересмотра из-за последствий больших данных, выявленных в статье под названием "Предложение решения для больших данных". методология рассматривает обработку больших данных с точки зрения полезных перестановок источников данных, сложности взаимосвязей и сложности удаления (или изменения) отдельных записей.

Исследования 2012 года показали, что многоуровневая архитектура является одним из вариантов решения проблем, которые представляют большие данные. Распределенная параллельная архитектура распределяет данные между несколькими серверами; эти параллельные среды выполнения могут значительно повысить скорость обработки данных. Этот тип архитектуры вставляет данные в параллельную СУБД, которая реализует использование фреймворков MapReduce и Hadoop. Этот тип платформы выглядит так, чтобы сделать вычислительную мощность прозрачной для конечного пользователя с помощью сервера приложений переднего плана.

Озеро данных позволяет организации переключить свое внимание с централизованного управления на общую модель, чтобы реагировать на изменяющуюся динамику управления информацией. Это позволяет быстро сегрегировать данные в озере данных, тем самым уменьшая время накладных расходов.]

Аналитика больших данных для производственных приложений позиционируется как "архитектура 5C" (подключение, конвертация, кибернетика, когнитивные функции и конфигурация).[53] Заводская работа и киберфизические системы могут иметь расширенную систему " 6C":

- Подключение (датчик и сети)

- Облако (вычисления и данные по требованию)

- Кибер (модель и память)

- Содержание / контекст (значение и корреляция)

- Сообщество (совместное использование и сотрудничество)

- Настройка (персонализация и ценность)

Технологии[править]

В отчете McKinsey Global Institute за 2011 год основные компоненты и экосистемы больших данных характеризуются следующим образом:

- Методы анализа данных, такие как A / B тестирование, машинное обучение и обработка естественного языка

- Технологии больших данных, такие как бизнес-аналитика, облачные вычисления и базы данных

- Визуализация, такая как диаграммы, графики и другие отображения данных

Многомерные большие данные также могут быть представлены в виде кубов данных или, математически, тензоров . Системы баз данных массива настроены на предоставление хранилища и высокоуровневой поддержки запросов для этого типа данных. Дополнительные технологии, применяемые к большим данным, включают эффективные тензорные вычисления , такие как полилинейное подпространственное обучение ., массовая параллельная обработка ( MPP ) баз данных , поисковые приложения, интеллектуальный анализ данных, распределенные файловые системы , распределенные базы данных, облачная и HPC-инфраструктура (приложения, хранилища и вычислительные ресурсы) [60] и интернет.[ требуется цитирование] Несмотря на то, что было разработано много подходов и технологий, по-прежнему остается сложным осуществлять машинное обучение с использованием больших данных.

Некоторые реляционные базы данных MPP имеют возможность хранить и управлять петабайтами данных. Подразумевается возможность загрузки, мониторинга, резервного копирования и оптимизации использования больших таблиц данных в СУБД . [рекламный источник?]

Программа топологического анализа данных DARPA стремится к фундаментальной структуре массивных наборов данных, и в 2008 году технология стала публичной с запуском компании под названием Ayasdi . [требуется сторонний источник]

Практикующие процессы анализа больших данных, как правило, враждебно относятся к более медленному общему хранилищу [64], предпочитая непосредственно подключенное хранилище ( DAS ) в его различных формах от твердотельного накопителя ( SSD ) до диска большой емкости SATA, похороненного внутри узлов параллельной обработки. Архитектура общего хранилища— сеть хранения данных (SAN) и сетевое хранилище (NAS)-воспринимается как относительно медленная, сложная и дорогостоящая. Эти качества не согласуются с системами анализа больших данных, которые процветают за счет производительности системы, товарной инфраструктуры и низкой стоимости.

Доставка информации в реальном или близком к реальному времени является одной из определяющих характеристик анализа больших данных. Таким образом, задержка избегается везде, где это возможно. Данные в памяти хороши—данные на вращающемся диске на другом конце соединения FC SAN нет. Стоимость сети SAN в масштабе, необходимом для приложений аналитики, очень сильно выше, чем другие методы хранения.

Есть преимущества, а также недостатки совместного хранения в анализе больших данных, но специалисты по анализу больших данных по состоянию на 2011 не поддержали его.[65] [рекламный источник?]

Приложения[править]

Большие данные настолько повысили спрос на специалистов по управлению информацией , что Software AG , Oracle Corporation , IBM , Microsoft , SAP , EMC, HP и Dell потратили более $15 млрд на программные фирмы, специализирующиеся на управлении данными и аналитике. В 2010 году эта отрасль стоила более 100 миллиардов долларов и росла почти на 10 процентов в год: примерно в два раза быстрее, чем софтверный бизнес в целом.[7]

Развитые страны все чаще используют технологии, требующие больших объемов данных. В мире насчитывается 4,6 миллиарда абонентов мобильных телефонов, и от 1 миллиарда до 2 миллиардов человек имеют доступ к интернету.[7] между 1990 и 2005 годами более 1 миллиарда человек во всем мире вошли в средний класс, что означает, что больше людей стали более грамотными, что в свою очередь привело к информационному росту. В 1986 году в мире действительный потенциал для обмена информацией через телекоммуникационные сети составлял 281 петабайт, в 1993 году-471 петабайт, в 2000 году-2,2 экзабайта, в 2007 году-65 экзабайт [12] и прогнозы ставят объем интернет-трафика на уровне 667 экзабайт ежегодно к 2014 году.[7] Согласно одной оценке, одна треть всей хранящейся в глобальном масштабе информации представлена в виде буквенно-цифрового текста и неподвижных изображений [66], что является наиболее полезным форматом для большинства приложений с большими данными. Это также показывает потенциал еще неиспользуемых данных (т. е. в виде видео-и аудиоконтента).

В то время как многие поставщики предлагают стандартные решения для больших данных, эксперты рекомендуют разработку внутренних решений, специально адаптированных для решения проблемы компании под рукой, если компания имеет достаточные технические возможности.

Правительство[править]

Использование и внедрение больших данных в рамках правительственных процессов позволяет повысить эффективность с точки зрения затрат, производительности и инноваций , но не обходится без их недостатков. Анализ данных часто требует от многих органов государственного управления (центральных и местных) совместной работы и создания новых и новаторских процессов для достижения желаемых результатов.

CRVS (Civil Registration and Vital Statistics) собирает все сертификаты статуса от рождения до смерти. CRV является источником больших данных для правительств.

Международное развитие[править]

Исследования по вопросу об эффективном использовании информационно-коммуникационных технологий в целях развития (также известный как ICT4D ) показывают, что технология больших данных может внести важный вклад, но также создает уникальные проблемы для международного развития . достижения в области анализа больших данных открывают эффективные с точки зрения затрат возможности для совершенствования процесса принятия решений в таких важнейших областях развития, как здравоохранение, занятость , экономическая производительность, преступность, безопасность и управление природными бедствиями и ресурсами. кроме того, генерируемые пользователем данные предлагают новые возможности для придания неслышимому голоса. однако, давние проблемы для развивающихся регионов, такие как недостаточная технологическая инфраструктура и нехватка экономических и людских ресурсов, усугубляют существующие проблемы с большими данными, такими как конфиденциальность, несовершенная методология и проблемы совместимости.

Производство[править]

Основываясь на исследовании глобальных тенденций TCS 2013, улучшения в планировании поставок и качестве продукции обеспечивают наибольшее преимущество больших данных для производства. Большие данные обеспечивают инфраструктуру для прозрачности в обрабатывающей промышленности, которая представляет собой возможность устранить такие неопределенности, как непоследовательная производительность компонентов и доступность. Прогнозное производство как применимый подход к почти нулевому времени простоя и прозрачности требует огромного объема данных и передовых инструментов прогнозирования для систематического процесса преобразования данных в полезную информацию. Концептуальная основа прогностического производства начинается с сбора данных, где доступны различные типы сенсорных данных, таких как акустика, вибрация, давление, ток, напряжение и данные контроллера. Огромное количество сенсорных данных в дополнение к историческим данным создают большие данные в производстве. Сгенерированные большие данные выступают в качестве входных данных для инструментов прогнозирования и превентивных стратегий, таких как прогнозирование и Управление здоровьем (PHM).

Здравоохранение[править]

Анализ больших данных помог улучшить здравоохранение, предоставляя персонализированную медицину и предписывающую аналитику, клиническую интервенцию риска и прогнозную аналитику, снижение вариабельности отходов и ухода, автоматизированную внешнюю и внутреннюю отчетность данных о пациентах, стандартизированные медицинские термины и регистры пациентов и фрагментированные точечные решения. Некоторые направления совершенствования являются более желательными, чем фактически реализуемые. Уровень данных, генерируемых в рамках систем здравоохранения, не является тривиальным. С дополнительным внедрением технологий mHealth, eHealth и wearable объем данных будет продолжать увеличиваться. Это включает в себя данные электронной медицинской карты, данные визуализации, генерируемые пациентом данные, данные датчиков и другие формы трудных для обработки данных. В настоящее время существует еще более настоятельная необходимость в том, чтобы в таких средах уделялось больше внимания качеству данных и информации. "большие данные очень часто означают' грязные данные'и доля неточностей в данных увеличивается с ростом объема данных."Человеческий контроль в масштабе больших данных невозможен, и существует острая потребность в медицинских услугах для интеллектуальных инструментов для контроля точности и правдоподобности и обработки пропущенной информации. в то время как обширная информация в здравоохранении в настоящее время является электронной, она подходит под зонтиком больших данных, поскольку большинство из них неструктурировано и трудно использовать. использование больших данных в здравоохранении подняло значительные этические проблемы, начиная от рисков для индивидуальных прав, конфиденциальности и автономии, до прозрачности и доверия.

Смежной областью применения, которая в значительной степени опирается на большие данные, в области здравоохранения является компьютерная диагностика в медицине. достаточно вспомнить, что, например, для мониторинга эпилепсии принято ежедневно создавать от 5 до 10 ГБ данных. аналогичным образом, одно несжатое изображение томосинтеза молочной железы в среднем составляет 450 МБ данных. Это лишь некоторые из многих примеров, когда компьютерная диагностика использует большие данные. По этой причине большие данные были признаны одной из семи ключевых проблем, связанных с автоматизированной диагностикой системы необходимо преодолеть, чтобы достичь следующего уровня производительности.

Образование[править]

Исследование McKinsey Global Institute выявило нехватку 1,5 миллионов высококвалифицированных специалистов и менеджеров по обработке данных , а ряд университетов [требуется лучший источник], включая Университет Теннесси и Университет Беркли, создали магистерские программы для удовлетворения этого спроса. Частные bootcamps также разработали программы для удовлетворения этого спроса, включая бесплатные программы, такие как инкубатор данных или платные программы, такие как Генеральная Ассамблея . в конкретной области маркетинга одна из проблем, подчеркнутых Веделем и Каннаном разве что маркетинг имеет несколько поддоменов (например, реклама, промоакции, разработка продукта, брендинг) , которые все используют различные типы данных. Поскольку однотипные аналитические решения нежелательны, бизнес-школы должны готовить менеджеров по маркетингу, чтобы иметь широкие знания обо всех различных методах, используемых в этих поддоменах, чтобы получить общую картину и эффективно работать с аналитиками.

Медиа[править]

Чтобы понять, как медиа использует большие данные, сначала необходимо предоставить некоторый контекст в механизм, используемый для медиа-процесса. Это было предложено ником Коулдри и Джозефом Туроу, что практикующие врачи в СМИ и рекламе к большим данным подходят как можно больше действенных пунктов информации о миллионах физических лиц. Эта отрасль, как представляется, уходит от традиционного подхода использования конкретных медиа-сред, таких как газеты, журналы или телевизионные шоу, и вместо этого подключается к потребителям с технологиями, которые достигают целевых людей в оптимальные сроки в оптимальных местах. Конечная цель состоит в том, чтобы служить или передавать, сообщение или содержание, которое (статистически говоря) в соответствии с менталитетом потребителя. Например, издательские среды все чаще адаптируют сообщения (рекламные объявления) и контент (статьи) для привлечения потребителей, которые были получены исключительно с помощью различных видов деятельности по интеллектуальному анализу данных.

- Таргетирование потребителей (для рекламы маркетологами)

- Сбор данных

- Журналистика данных: издатели и журналисты используют инструменты больших данных для предоставления уникальных и инновационных идей и инфографики.

Channel 4, британский общественный телевизионный вещатель, является лидером в области больших данных и анализа данных .

Страхование[править]

Медицинские страховщики собирают данные о социальных "детерминантах здоровья", таких как потребление продуктов питания и телевизора, семейное положение, размер одежды и покупательские привычки, из которых они делают прогнозы относительно расходов на здравоохранение, с тем чтобы выявить проблемы со здоровьем у своих клиентов. Спорно, используются ли эти прогнозы в настоящее время для ценообразования.

Интернет вещей (IoT)[править]

Основная статья: Интернет вещей Дополнительная информация: Edge computing

Большие данные и IoT работают совместно. Данные, извлеченные из устройств Интернета вещей, обеспечивают отображение взаимосвязанности устройств. Такие сопоставления используются медиаиндустрией, компаниями и правительствами для более точного определения целевой аудитории и повышения эффективности средств массовой информации. IoT также все чаще используется в качестве средства сбора сенсорных данных, и эти сенсорные данные используются в медицинских производственных и транспортных [99] контекстах.

Кевин Эштон, цифровых инноваций эксперт, который приписывают чеканку термина,[100] определяет "Интернета вещей" в этой цитате: “Если бы у нас были компьютеры, которые знали все, что нужно знать о вещах—используя данные, которые они собрали без какой-либо помощи от нас—мы сможем отслеживать и подсчитывать все, и значительно уменьшить количество отходов, потерь и затрат. Мы бы знали, когда вещи нуждаются в замене, ремонте или напоминании, и были ли они свежими или прошлыми.”

Информационные технологии[править]

Тем более что с 2015 года большие данные стали играть заметную роль в рамках бизнес-операций как инструмент, помогающий сотрудникам работать более эффективно и оптимизировать сбор и распространение информационных технологий (ИТ). Использование больших данных для решения проблем ИТ и сбора данных в рамках предприятия называется аналитикой ИТ-операций (ITOA). применяя принципы больших данных в концепции машинного интеллекта и глубоких вычислений, ИТ-отделы могут прогнозировать потенциальные проблемы и переходить к предоставлению решений еще до того, как проблемы даже происходят. В это время предприятия ITOA также начали играть важную роль в управлении системами, предлагая платформы, которые объединяют отдельные хранилища данных и генерируют идеи из всей системы, а не из изолированных карманов данных.

Тематические исследования[править]

Правительство[править]

Китай[править]

- Комплексная совместная оперативная платформа (IJOP, 一体化联合作战平台) используется правительством для мониторинга населения, в частности уйгуров .[102] биометрические данные , включая образцы ДНК, собираются с помощью программы бесплатных медицинских осмотров.[103]

- К 2020 году Китай планирует дать всем своим гражданам личный" социальный кредит", основанный на том, как они ведут себя.[104] система социального кредитования , которая в настоящее время опробована в ряде китайских городов, рассматривается как форма массового наблюдения, которая использует технологию анализа больших данных.

Индия[править]

- Анализ больших данных был опробован для BJP, чтобы выиграть индийские всеобщие выборы 2014 года .

- Индийское правительство использует многочисленные методы для выяснения того, как индийский электорат реагирует на действия правительства, а также идеи по расширению политики.

Израиль[править]

- Приложение для больших данных было разработано Agro Web Lab для помощи в регулировании орошения.

- Персонализированные диабетические процедуры могут быть созданы с помощью решения GlucoMe для работы с большими данными.

Великобритания[править]

Примеры использования больших данных в государственных службах:

- Данные о отпускаемых по рецепту лекарствах: сопоставив происхождение, место и время действия каждого рецепта, исследовательское подразделение смогло проиллюстрировать значительную задержку между выпуском любого данного лекарственного средства и британской адаптацией руководящих принципов Национального института здравоохранения и передового опыта. Это говорит о том, что новые или самые современные препараты занимают некоторое время, чтобы просочиться к общему пациенту.

- Объединение данных: местный орган власти смешал данные об услугах, таких как дорожная решетка rotas, с услугами для людей в группе риска, таких как "питание на колесах". Подключение данных позволило местным властям избежать любой задержки, связанной с погодой.

Соединенные Штаты Америки[править]

- В 2012 году администрация Обамы объявила об инициативе по исследованию и развитию больших данных, чтобы изучить, как большие данные могут быть использованы для решения важных проблем, с которыми сталкивается правительство. инициатива состоит из 84 различных программ больших данных, распределенных по шести отделам.

- Анализ больших данных сыграл большую роль в успешной предвыборной кампании Барака Обамы в 2012 году .

- Федеральное правительство Соединенных Штатов владеет пятью из десяти самых мощных суперкомпьютеров в мире.

- Центр Обработки Данных штата Юта был построен Агентством национальной безопасности Соединенных Штатов . После завершения работы объект сможет обрабатывать большое количество информации, собранной АНБ через Интернет. Точный объем дискового пространства неизвестен, но более поздние источники утверждают, что он будет составлять порядка нескольких эксабайт . это создало проблемы безопасности в отношении анонимности собранных данных.

Розничная торговля[править]

- Walmart обрабатывает более 1 миллиона транзакций клиентов каждый час, которые импортируются в базы данных, которые, по оценкам, содержат более 2,5 петабайт (2560 терабайт) данных—эквивалент 167 раз информации, содержащейся во всех книгах в Библиотеке Конгресса США .

- Windermere Real Estate использует информацию о местоположении от почти 100 миллионов водителей, чтобы помочь новым покупателям жилья определить их типичное время поездки на работу и с работы в течение всего дня.

- Система обнаружения карт FICO защищает учетные записи по всему миру.

Наука[править]

- Большие эксперименты Адронного Коллайдера представляют собой около 150 миллионов датчиков, передающих данные 40 миллионов раз в секунду. Существует почти 600 миллионов столкновений в секунду. После фильтрации и воздержания от записи более 99,99995% [123] этих потоков возникает 1000 коллизий, представляющих интерес в секунду.

- В результате, только работая с менее чем 0,001% данных потока датчика, поток данных от всех четырех экспериментов LHC представляет собой 25 петабайт годовой скорости до репликации (по состоянию на 2012 ). Это становится почти 200 петабайт после репликации.

- Если бы все данные датчиков записывались в бак, с потоком данных было бы чрезвычайно трудно работать. Поток данных превысит 150 миллионов петабайт в год, или почти 500 эксабайт в день, до репликации. Чтобы поставить число в перспективе, это эквивалентно 500 квинтиллионов (5×10 20 ) байт в день, почти в 200 раз больше, чем все другие источники, объединенные в мире.

- Массив квадратных километров представляет собой радиотелескоп, построенный из тысяч антенн. Ожидается, что он будет введен в эксплуатацию к 2024 году. В совокупности эти антенны, как ожидается, будут собирать 14 эксабайт и хранить один петабайт в день. он считается одним из самых амбициозных научных проектов, когда-либо предпринимавшихся.

- Когда Sloan Digital Sky Survey (SDSS) начала собирать астрономические данные в 2000 году, она накопила за первые несколько недель больше, чем все данные, собранные в истории астрономии ранее. Продолжая работать со скоростью около 200 ГБ в сутки, SDSS накопила более 140 терабайт информации. Когда большой синоптический обзорный телескоп , преемник SDSS, выйдет в сеть в 2020 году, его разработчики ожидают, что он будет получать такое количество данных каждые пять дней.

- Расшифровка генома человека первоначально занимала 10 лет; теперь это может быть достигнуто менее чем за сутки. Секвенсоры ДНК разделили стоимость секвенирования на 10 000 за последние десять лет, что в 100 раз дешевле, чем снижение стоимости, предсказанное законом Мура .

- Центр моделирования климата НАСА (NCC) хранит 32 петабайта климатических наблюдений и моделирования на кластере Discover supercomputing.

- DNAStack Google собирает и организует образцы ДНК генетических данных со всего мира для выявления заболеваний и других медицинских дефектов. Эти быстрые и точные вычисления исключают любые "точки трения" или человеческие ошибки, которые могут быть сделаны одним из многочисленных научных и биологических экспертов, работающих с ДНК. DNAStack, часть Google Genomics, позволяет ученым использовать обширную выборку ресурсов с поискового сервера Google для масштабирования социальных экспериментов, которые обычно занимают годы, мгновенно.

- База данных ДНК 23andme содержит генетическую информацию о более чем 1 000 000 людях по всему миру. компания исследует продажу "анонимных агрегированных генетических данных" другим исследователям и фармацевтическим компаниям для исследовательских целей, если пациенты дают свое согласие. Ахмад Харири, профессор психологии и нейробиологии Университета Дьюка, который использует 23andMe в своих исследованиях с 2009 года, утверждает, что наиболее важным аспектом новой услуги компании является то, что она делает генетические исследования доступными и относительно дешевыми для ученых. Исследование, которое выявило 15 геномных сайтов, связанных с депрессией в базе данных 23andMe, привело к резкому росту требований к доступу к хранилищу с 23andMe fielding почти 20 запросов на доступ к данным депрессии в течение двух недель после публикации статьи.

- Вычислительная гидродинамика (CFD) и гидродинамические исследования турбулентности генерируют массивные наборы данных. Базы данных турбулентности Джонса Хопкинса ( JHTDB) содержит более 350 терабайт пространственно-временных полей от прямого численного моделирования различных турбулентных течений. Такие данные было трудно разделить с использованием традиционных методов, таких как загрузка плоских выходных файлов моделирования. Доступ к данным в JHTDB можно получить с помощью "виртуальных датчиков" с различными режимами доступа, начиная от прямых запросов веб-браузера, доступа через программы Matlab, Python, Fortran и C, выполняющиеся на платформах клиентов, чтобы вырезать службы для загрузки необработанных данных. Эти данные были использованы в более чем 150 научных публикациях .

Спорт[править]

Большие данные могут быть использованы для улучшения подготовки и понимания конкурентов, используя спортивные датчики. Также можно предсказать победителей в матче, используя аналитику больших данных. Также можно было бы спрогнозировать будущие выступления игроков. Таким образом, стоимость и зарплата игроков определяется данными, собранными в течение всего сезона.

В гонках Формулы-1 гоночные автомобили с сотнями датчиков генерируют терабайты данных. Эти датчики собирают точки данных от давления в шинах до эффективности сжигания топлива.Основываясь на этих данных, инженеры и аналитики данных решают, следует ли вносить коррективы, чтобы выиграть гонку. Кроме того, используя большие данные, гоночные команды пытаются заранее предсказать время, когда они закончат гонку, основываясь на симуляциях с использованием данных, собранных в течение сезона.

Технология[править]

- eBay.com использует два хранилища данных на 7,5 петабайт и 40PB, а также кластер Hadoop 40PB для поиска, потребительских рекомендаций и мерчандайзинга.

- Amazon.com обрабатывает миллионы внутренних операций каждый день, а также запросы от более чем полумиллиона сторонних продавцов. Основная технология, которая поддерживает работу Amazon, основана на Linux, и по состоянию на 2005 у них было три крупнейших в мире базы данных Linux, с емкостью 7,8 ТБ, 18,5 ТБ и 24,7 ТБ.

- Facebook обрабатывает 50 миллиардов фотографий из своей пользовательской базы.[148] по состоянию на июнь 2017 , Facebook достиг 2 миллиардов активных пользователей ежемесячно .[149]

- По состоянию на август 2012 года Google обрабатывала около 100 миллиардов запросов в месяц .

Исследовательская деятельность[править]

Зашифрованный поиск и формирование кластера в больших данных были продемонстрированы в марте 2014 года в американском обществе инженерного образования. Гаутам Сивач занимается решением проблем больших данных с помощью Лаборатории компьютерных наук и искусственного интеллекта MIT а доктор Амир Исмаилпур из исследовательской группы UNH исследовал такие ключевые особенности больших данных, как формирование кластеров и их взаимосвязи. Они сосредоточились на безопасности больших данных и ориентации термина на наличие различных типов данных в зашифрованном виде в облачном интерфейсе, предоставляя необработанные определения и примеры в реальном времени в рамках технологии. Кроме того, они предложили подход для определения метода кодирования, чтобы продвинуться в направлении ускоренного поиска по зашифрованному тексту, что приведет к повышению безопасности в больших данных.

В марте 2012 года Белый дом объявил о национальной "инициативе больших данных", которая состояла из шести федеральных ведомств и агентств, выделяющих более 200 миллионов долларов на исследовательские проекты в области больших данных.

Эта инициатива включала в себя грант Национального научного фонда "экспедиции в вычислительной технике" в размере 10 миллионов долларов США в течение 5 лет для AMPLab в Калифорнийском университете в Беркли. AMPLab также получил средства от DARPA , а также более десятка промышленных спонсоров и использует большие данные для атаки на широкий спектр проблем от прогнозирования пробок на дорогах до борьбы с раком.

Инициатива большого объема данных Белого дома также включала обязательство Министерства энергетики предоставить $ 25 млн в виде финансирования в течение 5 лет для создания института масштабируемого управления данными, анализа и визуализации (SDAV) , возглавляемого Национальной лабораторией Лоуренса Беркли Министерства энергетики . Институт SDAV стремится объединить опыт шести национальных лабораторий и семи университетов для разработки новых инструментов, которые помогут ученым управлять и визуализировать данные о суперкомпьютерах Департамента.

В мае 2012 года американский штат Массачусетс объявил о Массачусетской инициативе по большим данным, которая предоставляет финансирование от правительства штата и частных компаний различным исследовательским учреждениям. Массачусетский Технологический институт принимает научно-технический центр Intel для больших данных в лаборатории MIT Computer Science and Artificial Intelligence , объединяя государственное, корпоративное и институциональное финансирование и исследовательские усилия.

Европейская комиссия финансирует двухлетний форум Big Data Public Private Forum через свою седьмую рамочную программу для привлечения компаний, ученых и других заинтересованных сторон к обсуждению вопросов больших данных. Проект направлен на определение стратегии в области научных исследований и инноваций для руководства вспомогательными действиями со стороны Европейской комиссии в целях успешной реализации экономики больших данных. Результаты этого проекта будут использованы в качестве вклада в Горизонт 2020, их следующую рамочную программу .

Британское правительство объявило в марте 2014 года об основании Института Алана Тьюринга, названного в честь компьютерного пионера и дешифровщика, который сосредоточится на новых способах сбора и анализа больших массивов данных.

В день вдохновения Canadian Open Data Experience (CODE) в кампусе Университета Ватерлоо Стратфорд участники продемонстрировали, как использование визуализации данных может повысить понимание и привлекательность больших наборов данных и донести их историю до всего мира.[162]

Чтобы сделать производство более конкурентоспособным в США (и мире), необходимо интегрировать больше американской изобретательности и инноваций в производство ; таким образом, Национальный научный фонд предоставил отрасли университета сотрудничества научно-исследовательский центр интеллектуальных систем, техническое обслуживание (IMS) в Университете Цинциннати , чтобы сосредоточиться на разработке передовых прогностических инструментов и методов, чтобы быть применимым в большой данных условиях. В мае 2013 года Центр IMS провел заседание отраслевого консультативного совета по большим данным, на котором ведущие из различных промышленных компаний обсудили свои проблемы, проблемы и будущие цели в среде больших данных.

Вычислительные социальные науки-ЛЮБОЙ человек может использовать интерфейсы прикладного программирования (API), предоставляемые владельцами больших данных, таких как Google и Twitter, для проведения исследований в области социальных и поведенческих наук. часто эти API предоставляются бесплатно. Tobias Preis et al. данные Google Trends показывают, что пользователи Интернета из стран с более высоким валовым внутренним продуктом (ВВП) на душу населения с большей вероятностью будут искать информацию о будущем, чем информацию о прошлом. Полученные результаты свидетельствуют о том, что между поведением в интернете и реальными экономическими показателями может существовать связь. авторы исследования рассмотрели журналы запросов Google, составленные по соотношению объема поисковых запросов за предстоящий год ('2011') к объему поисковых запросов за предыдущий год ('2009'), который они называют "индексом ориентации на будущее". Они сравнили индекс ориентации на будущее с ВВП на душу населения каждой страны и обнаружили сильную тенденцию для стран, где пользователи Google запрашивают больше о будущем, чтобы иметь более высокий ВВП. Полученные результаты позволяют предположить, что существует потенциальная связь между экономическим успехом страны и поведением ее граждан, направленным на поиск информации, отраженным в больших данных.

Тобиас Прейс и его коллеги Хелен Сюзанна Моут и Х. Юджин Стэнли представили метод определения онлайн-предшественников движения фондового рынка, используя торговые стратегии, основанные на данных об объеме поиска, предоставленных Google Trends. их анализ объема поиска Google для 98 терминов различной финансовой релевантности, опубликованных в Научных отчетах, предполагает, что увеличение объема поиска для финансово релевантных поисковых терминов, как правило, предшествует большим потерям на финансовых рынках.

Большие наборы данных приходят с алгоритмическими проблемами, которые ранее не существовали. Следовательно, существует необходимость кардинально изменить способы обработки.

Семинары по алгоритмам для современных массивных наборов данных (MMDS) объединяют ученых-компьютерщиков, статистиков, математиков и практиков анализа данных для обсуждения алгоритмических проблем больших данных. что касается больших данных, то нужно иметь в виду, что такие понятия величины относительны. Как говорится "если прошлое имеет какое-либо руководство, то сегодняшние большие данные, скорее всего, не будут рассматриваться как таковые в ближайшем будущем."

Выборка больших данных[править]

Важный исследовательский вопрос, который можно задать о больших наборах данных, заключается в том, нужно ли вам смотреть на полные данные, чтобы сделать определенные выводы о свойствах данных, или это достаточно хороший образец. Само название big data содержит термин, связанный с размером, и это является важной характеристикой больших данных. Но выборка (статистика) позволяет выбрать правильные точки данных из большего набора данных для оценки характеристик всей совокупности. Например, существует около 600 миллионов твитов, производимых каждый день. Стоит ли смотреть на все из них, чтобы определить темы, которые обсуждаются в течение дня? Нужно ли смотреть на все твиты, чтобы определить настроение по каждой из тем? В производстве различных типов сенсорных данных, таких как акустика, вибрация, давление, ток, напряжение и данные контроллера доступны в короткие промежутки времени. Для прогнозирования простоя может не потребоваться рассматривать все данные, но образец может быть достаточным. Большие данные могут быть разбиты на различные категории точек данных, такие как демографические, психографические, поведенческие и транзакционные данные. Имея большой набор точек данных, маркетологи могут создавать и использовать более специализированные сегменты потребителей для более стратегического таргетирования.

Была проделана определенная работа в области алгоритмов выборки больших данных. Разработана теоретическая формулировка для выборки данных Twitter.

Критика[править]

Критика парадигмы больших данных имеет две разновидности: те, которые ставят под сомнение последствия самого подхода, и те, которые ставят под сомнение то, как это делается в настоящее время. одним из подходов к этой критике является область критических исследований данных .

Критика парадигмы больших данных[править]

"Важнейшей проблемой является то, что мы мало знаем о лежащих в основе эмпирических микропроцессов, которые приводят к возникновению[se] типичных сетевых характеристик больших данных". в своей критике Snijders, Matzat и Reips указывают, что часто очень сильные предположения делаются о математических свойствах, которые могут вообще не отражать то, что действительно происходит на уровне микропроцессов. Марк Грэм подверг широкой критике утверждение Криса Андерсона о том, что большие данные положат конец теории: особое внимание уделяется тому, что большие данные всегда должны быть контекстуализированы в их социальном, экономическом и политическом контекстах. даже если компании инвестируют восьмизначные и девятизначные суммы, чтобы получить представление о потоке информации от поставщиков и клиентов, менее 40% сотрудников имеют достаточно зрелые процессы и навыки для этого. Чтобы преодолеть этот недостаток понимания, большие данные, независимо от того, насколько они всесторонни или хорошо проанализированы, должны быть дополнены "большим суждением", согласно статье в Harvard Business Review.

Во многом в этом же ключе было отмечено, что решения, основанные на анализе больших данных, неизбежно "информируются миром, каким он был в прошлом, или, в лучшем случае, каким он является в настоящее время". питаясь большим количеством данных о прошлом опыте, алгоритмы могут предсказывать будущее развитие, если будущее подобно прошлому. если динамика систем будущего изменяется (если это не стационарный процесс), прошлое мало что может сказать о будущем. Для того, чтобы делать прогнозы в изменяющихся условиях, необходимо было бы иметь полное представление о динамике систем, что требует теории. в качестве ответа на эту критику Алемани Оливер и Вайр предлагают использовать "похищающее рассуждение как первый шаг в исследовательском процессе, чтобы привести контекст к цифровым следам потребителей и создать новые теории". Кроме того, было предложено объединить подходы больших данных с компьютерными моделями, такими как агентные модели и сложные системы. Агент-ориентированные модели все больше совершенствуются в прогнозировании исхода социальных сложностей даже неизвестных сценариев будущего с помощью компьютерного моделирования, основанного на совокупности взаимозависимых алгоритмов. наконец, использование многомерных методов, которые исследуют скрытую структуру данных , таких как факторный анализ и кластерный анализ, оказались полезными в качестве аналитических подходов, которые выходят далеко за рамки двухвариантных подходов (кросс-табуляции), обычно используемых с меньшими наборами данных.

В медицине и биологии традиционные научные подходы основаны на экспериментах. Для этих подходов ограничивающим фактором являются соответствующие данные, которые могут подтвердить или опровергнуть исходную гипотезу. В настоящее время в биологических науках принят новый постулат: информация, предоставляемая данными в огромных объемах ( omics ) без предварительной гипотезы, является комплементарной и иногда необходимой для традиционных подходов, основанных на эксперименте. в массовых подходах это формулировка соответствующей гипотезы для объяснения данных, которые являются ограничивающим фактором.[192] Логика поиска обращена вспять, и необходимо рассмотреть пределы индукции ("Слава науки и философский скандал", C. D. Broad, 1926).

Защитники конфиденциальности обеспокоены угрозой конфиденциальности, которую представляет увеличение объема хранения и интеграции персонально идентифицируемой информации; экспертные группы выпустили различные рекомендации по политике, чтобы соответствовать практике ожиданий конфиденциальности. злоупотребление большими данными в ряде случаев средствами массовой информации, компаниями и даже правительством позволило уничтожить доверие почти ко всем фундаментальным институтам, поддерживающим общество.

Найеф Аль-Родхан утверждает, что новый вид общественного договора будет необходим для защиты индивидуальных свобод в контексте больших данных и гигантских корпораций, владеющих огромными объемами информации. Использование больших данных должно контролироваться и лучше регулироваться на национальном и международном уровнях. Барокас и Ниссенбаум утверждают, что один из способов защиты индивидуальных пользователей заключается в получении информации о типах собираемой информации, с кем она передается, под какими ограничениями и для каких целей.

Критика модели " V "[править]

"V" модель больших данных является согласованной, поскольку она сосредотачивается вокруг вычислительной масштабируемости и не имеет потерь вокруг воспринимаемости и понятности информации. Это привело к созданию структуры когнитивных больших данных, которая характеризует применение больших данных в соответствии с:

- Полнота данных: понимание неочевидного из данных;

- Корреляция данных, причинно-следственная связь и предсказуемость: причинность как не существенное требование для достижения предсказуемости;

- Объяснимость и интерпретируемость: люди хотят понять и принять то, что они понимают, где алгоритмы не справляются с этим;

- Уровень автоматизированного принятия решений: алгоритмы, поддерживающие автоматизированное принятие решений и алгоритмическое самообучение;

Критика новизны[править]

Большие массивы данных были проанализированы вычислительными машинами в течение более чем столетия, в том числе анализ переписей населения США, выполненный машинами перфокарты IBM, которые вычисляли статистику, включая средние и дисперсии населения по всему континенту. В более поздние десятилетия научные эксперименты, такие как ЦЕРН, производили данные в масштабах, аналогичных нынешним коммерческим "большим данным". Однако научные эксперименты имеют тенденцию анализировать свои данные с использованием специализированных специализированных высокопроизводительных вычислений (суперкомпьютерные) кластеры и сетки, а не облака дешевых товарных компьютеров, как в нынешней коммерческой волне, подразумевающей разницу как в культуре, так и в технологическом стеке.

Критика выполнения больших данных[править]

Ульф-Дитрих Рейпс и Уве Мацат писали в 2014 году, что большие данные стали "причудой" в научных исследованиях. исследователь Дэн Бойд выразил обеспокоенность по поводу использования больших данных в науке, пренебрегая такими принципами, как выбор репрезентативной выборки, будучи слишком озабоченным обработкой огромных объемов данных. такой подход может привести к смещению результатов так или иначе. Интеграция разнородных информационных ресурсов-одни из которых могут рассматриваться как большие данные, а другие нет—представляет собой огромные логистические и аналитические проблемы, но многие исследователи утверждают, что такие интеграции, вероятно, будут представлять собой наиболее перспективные новые рубежи в науке. В провокационной статье "критические вопросы для больших данных", авторы называют большие данные частью мифологии: "большие наборы данных предлагают более высокую форму интеллекта и знаний [...], с ореолом правды, объективности и точности". Пользователи больших данных часто "теряются в огромном количестве цифр", и"работа с большими данными все еще субъективна, и то, что она количественно измеряет, не обязательно имеет более близкие претензии на объективную истину". последние разработки в области BI, такие как проактивная отчетность, особенно нацелены на улучшение удобства использования Больших Данных за счет автоматизированной фильтрации непотребных данных и корреляций . большие структуры полны паразитных корреляций либо из-за не-причинных совпадений ( закон истинно больших чисел ), исключительно природа большой случайности ( теория Рамсея), либо существование не включенных факторов, поэтому надежда ранних экспериментаторов сделать большие базы данных чисел "говорят сами за себя" и революционизируют научный метод, ставится под сомнение.

Анализ больших данных часто является поверхностным по сравнению с анализом небольших наборов данных. во многих проектах с большими данными не происходит анализа больших данных, но проблема заключается в извлечении, преобразовании, загрузке части предварительной обработки данных.

Большие данные-это модное слово и "неопределенный термин", [208] [209] но в то же время "одержимость" предпринимателями, консультантами, учеными и средствами массовой информации. Большие витрины данных, такие как Google Flu Trends, не смогли обеспечить хорошие прогнозы в последние годы, завышая вспышки гриппа в два раза. Точно так же, премия Академии наук и предвыборные прогнозы, основанные исключительно на Твиттере, чаще ошибались, чем были нацелены. Большие данные часто создают те же проблемы, что и малые данные; добавление большего количества данных не решает проблемы предвзятости, но может подчеркнуть другие проблемы. В частности, такие источники данных, как Twitter, не являются репрезентативными для всего населения, и результаты, полученные из таких источников, могут привести к неверным выводам. Google Translate—который основан на статистическом анализе больших данных текста-делает хорошую работу при переводе веб-страниц. Однако результаты из специализированных доменов могут быть резко искажены. С другой стороны, большие данные могут также привести к возникновению новых проблем, таких как проблема множественных сравнений : одновременное тестирование большого набора гипотез, вероятно, приведет к получению многих ложных результатов, которые ошибочно кажутся значимыми. Иоаннидис утверждал ,что " большинство опубликованных результатов исследований являются ложными " из – за по существу того же самого эффекта: когда многие научные группы и исследователи каждый выполняют много экспериментов (т. е. обрабатывают большое количество научных данных; хотя и не с технологией больших данных), вероятность того, что "значительный" результат будет ложным, быстро растет-тем более, когда публикуются только положительные результаты. Кроме того, результаты анализа больших данных настолько же хороши, как и модель, на которой они основаны. Например, big data с разной степенью успеха принимали участие в попытках предсказать результаты президентских выборов 2016 года в США .

=В популярной культуре[править]

Книги[править]

Moneyball - научно-популярная книга, в которой рассказывается о том, как Окленд Атлетикс использовал статистический анализ, чтобы превзойти команды с большими бюджетами. В 2011 году была выпущена экранизация с Брэдом Питтом в главной роли.

Фильм[править]

В "Капитане Америка: Зимний солдат" H.Y.D.R.A (замаскированный под Щ.И.Т.А) разрабатывает вертолеты, которые используют данные для определения и устранения угроз по всему миру.

В "Темном рыцаре" Бэтмен использует сонар, который может шпионить за всем Готэм-Сити. Данные собираются с мобильных телефонов людей в пределах города.

Смотрите также[править]

Список компаний и инструментов см. Также в разделе категория: Большие данные .

- Биг дата

- Этика больших данных

- Модель Зрелости Больших Данных

- Большая память

- Анализ данных

- Курирование данных

- Хранилище, определяемое данными

- Журналистика данных

- Родословная данных

- Благотворительность данных

- Качество данных

- Наука о данных

- Датификация

- Хранилище данных

- Обработка в памяти

- Список компаний с большими данными

- Небольшие данные

- Статистика

- Надзорный капитализм

- Городская информатика

- Очень большая база данных

- XLDB

Дальнейшее чтение[править]

- Karolin Kappler; Jan-Felix Schrape; Lena Ulbricht; Johannes Weyer (2018). "Социальные последствия больших данных". KI – Künstliche Intelligenz. Том. 32 no. 1. Прыгун. doi:

- Питер Киннэйрд; Инбал Талгам-Коэн, ЭДС. (2012). "Большие Данные". ACM Crossroads студенческий журнал . XRDS: Crossroads, журнал ACM для студентов . Том. 19 no. 1. Ассоциация по вычислительной технике .

- Юре Лесковец ; Ананд Раджараман; Джеффри Д. Уллман (2014). Майнинг массивных наборов данных . Издательство Кембриджского Университета. .

- Виктор Майер-Шенбергер; Кеннет Кукье (2013). Большие данные: революция, которая изменит то, как мы живем, работаем и думаем . Хоутон Миффлин Харкорт. I.

- Пресса, Гил (9 Мая 2013 Года). "Очень Короткая История Больших Данных". forbes.com Джерси-Сити, Нью-Джерси: журнал Forbes . Получено 17 Сентября 2016 Года .

- "Big Data: The Management Revolution". hbr.org. Harvard Business Review.

- О'Нил, Кэти (2017). Оружие математического уничтожения: насколько большие данные увеличивают неравенство и угрожают демократии . Бродвейские Книги