Искусственный интеллект

В информатике искусственный интеллект (ИИ ),увод тьмы, иногда называемый машинным интеллектом, - это интеллект , демонстрируемый машинами, в отличие от естественного интеллекта, отображаемого людьми и животными. В разговорной речи термин "искусственный интеллект" используется для описания машин , которые имитируют "когнитивные" функции, которые люди связывают с другими человеческими умами, такими как "обучение" и "решение проблем".

По мере того, как машины становятся все более способными, задачи, требующие "интеллекта", часто удаляются из определения ИИ, явления, известного как эффект ИИ . в Теореме Теслера говорится: "ИИ-это то, что еще не сделано." например, оптическое распознавание символов часто исключается из вещей, которые считаются ИИ, став рутинной технологией. современные возможности машины, обычно классифицируемые как ИИ, включают в себя успешное понимание человеческой речи, соревнование на самом высоком уровне в стратегических игровых системах (таких как шахматы и Go), автономно работающие автомобили интеллектуальная маршрутизация в сетях доставки контента и военное моделирование .

Искусственный интеллект можно разделить на три различных типа систем: аналитический, человеческий и гуманизированный искусственный интеллект. аналитический ИИ имеет только характеристики, совместимые с когнитивным интеллектом ; создание когнитивного представления о мире и использование обучения на основе прошлого опыта для информирования будущих решений. ИИ, вдохновленный человеком, имеет элементы когнитивного и эмоционального интеллекта; понимание человеческих эмоций в дополнение к когнитивным элементам и рассмотрение их в процессе принятия решений. Гуманизированный ИИ показывает характеристики всех типов компетенций (т. е. когнитивного, эмоционального и социального интеллекта), способен к самосознанию и самосознанию во взаимодействии с другими.

Искусственный интеллект был основан как академическая дисциплина в 1956, и в годах с тех пор испытал несколько волн оптимизма, сопровождаемого разочарованием и потерей финансирования (известный как "зима ИИ"), сопровождаемый новыми подходами, успехом и возобновленным финансированием. на протяжении большей части своей истории исследования ИИ были разделены на подполя, которые часто не могут общаться друг с другом. Эти подполя основаны на технических соображениях, таких как конкретные цели (например, "робототехника" или "машинное обучение"), использование конкретных инструментов ("логика" или искусственные нейронные сети ), или глубокие философские различия. подполя были также основаны на социальных факторах (особые учреждения или работа особых исследователей).

Традиционные проблемы (или цели) исследования ИИ включают рассуждения , представление знаний , планирование , обучение , обработку естественного языка , восприятие и способность перемещать и манипулировать объектами. Общая разведка-одна из долгосрочных целей области. подходы включают статистические методы , вычислительный интеллект и традиционный символический ИИ . В ИИ используется множество инструментов , включая варианты поисковой и математической оптимизации , искусственные нейронные сети и методы, основанные на статистике, вероятности и экономике . Область ИИ опирается на информатику, информационные технологии , математика , психология , лингвистика , философия и многие другие области.

Поле было основано на утверждении, что человеческий интеллект "может быть настолько точно описан, что машина может быть сделана для его имитации".Это поднимает философские аргументы о природе ума и этике создания искусственных существ , наделенных человеческим разумом, которые являются проблемами, которые были исследованы мифом, беллетристикой и философией начиная с древности . Некоторые люди также считают ИИ опасностью для человечества, если он прогрессирует без замедления. другие считают, что ИИ, в отличие от предыдущих технологических революций, создаст риск массовой безработицы .

В двадцать первом веке техники ИИ пережили возрождение после одновременных достижений в области вычислительной техники, больших объемов данных и теоретического понимания; и методы ИИ стали неотъемлемой частью технологической индустрии , помогая решать многие сложные проблемы в области информатики , разработки программного обеспечения и исследований операций .

История[править]

Основные статьи: История искусственного интеллекта и Сроки искусственного интеллекта Хронология развития искусственного интеллекта

Мыслеспособные искусственные существа появились как рассказывающие устройства в древности ,и были распространены в беллетристике, как в Франкенштейне Мэри Шелли или Р. У. Р. Карела Чапека (Универсальные Роботы Россума) . эти персонажи и их судьбы подняли многие из тех же вопросов, которые сейчас обсуждаются в этике искусственного интеллекта .

Изучение механического или" формального " рассуждения началось с философов и математиков в древности. Изучение математической логики привело непосредственно к теории вычислений Алана Тьюринга, которая предполагала, что машина, перетасовывая символы как простые как "0" и "1", могла моделировать любой мыслимый акт математической дедукции. Это понимание, что цифровые компьютеры могут моделировать любой процесс формального рассуждения, известно как тезис Церкви-Тьюринга .[26] наряду с параллельными открытиями в нейробиологии, теории информации и кибернетике это привело исследователей к рассмотрению возможности построения электронного мозга. Тьюринг предположил ,что "если человек не может отличить ответы от машины и человека, то машину можно считать"разумной". первой работой, которая теперь общепризнана как ИИ, был официальный дизайн Маккалуша и Питта 1943 года для Тьюринга-полные "искусственные нейроны".

Область исследований ИИ родилась в мастерской Дартмутского колледжа в 1956 году. участники Аллен Ньюэлл ( КМУ ), Герберт Саймон ( КМУ ), Джон Маккарти ( MIT ), Марвин Мински ( MIT ) и Артур Сэмюэль ( IBM ) стали основателями и лидерами исследований ИИ. они и их ученики дали программ, которые в прессе описывался как "удивительная": компьютеры учились шашки стратегии (возр. 1954) (и к 1959 году были якобы играют лучше, чем средний человек), решение текстовых задач по алгебре, подтверждающие логические теоремы (логика теоретик, первый запуск кондиционера. 1956) и говорить по-английски. К середине 1960-х годов исследования в США активно финансировались Министерством обороны , и лаборатории были созданы по всему миру.Основатели ИИ с оптимизмом смотрели в будущее: Герберт Саймон предсказывал, что"машины будут способны в течение двадцати лет выполнять любую работу, которую может выполнить человек". Марвин Мински согласился, написав: "в течение одного поколения ... проблема создания"искусственного интеллекта" будет существенно решена".

Они не осознали сложности некоторых из оставшихся задач. Прогресс замедлился, и в 1974 году, в ответ на критику сэра Джеймса Лайтхилла и продолжающееся давление Конгресса США на финансирование более продуктивных проектов, правительства США и Великобритании прекратили исследовательские исследования в области ИИ. Следующие несколько лет позже назвали бы "зимой ИИ", период, когда получение финансирования для проектов ИИ было трудно.

В начале 1980-х, исследование ИИ было восстановлено коммерческим успехом экспертных систем, форма программы ИИ, которая моделировала знания и аналитические навыки человеческих экспертов. К 1985 году рынок ИИ достиг более миллиарда долларов. В то же время японский компьютерный проект пятого поколения вдохновил правительства США и Великобритании на восстановление финансирования научных исследований . однако, начиная с краха рынка машин Lisp в 1987 году, AI снова стал пользоваться дурной славой, и начался второй, более длительный перерыв.

В конце 1990-х и начале 21-го века ИИ начали использоваться для логистики, интеллектуального анализа данных, медицинской диагностики и других областей. успех был обусловлен увеличением вычислительной мощности (см. закон Мура ), повышением внимания к решению конкретных проблем, новыми связями между ИИ и другими областями (такими как статистика , экономика и математика) и приверженностью исследователей математическим методам и научным стандартам. Deep Blue стала первой компьютерной шахматной системой, которая обыграла действующего чемпиона мира по шахматам Гарри Каспарова 11 мая 1997 года .

В 2011 году под угрозой срыва! quiz show exhibition match, система ответов на вопросы IBM, Уотсон, победил две самые большие опасности! чемпионы, Брэд Раттер и Кен Дженнингс , с существенным отрывом.Более быстрые компьютеры, алгоритмические улучшения и доступ к большим объемам данных позволили прогрессу в машинном обучении и восприятии; голодные данными методы глубокого обучения начали доминировать над контрольными показателями точности приблизительно в 2012 . Kinect, который предоставляет интерфейс 3D body-motion для Xbox 360 и Xbox One, использует алгоритмы, которые появились из длительных исследований AI , как и интеллектуальные персональные помощники в смартфонах . В марте 2016 года AlphaGo выиграл 4 из 5 игр Go в матче с чемпионом Go Lee Sedol, став первой компьютерной системой Go-playing , чтобы победить профессионального игрока Go без гандикапов . в 2017 Future of Go Summit AlphaGo выиграл матч с тремя играми с Ke Jie , который в то время постоянно занимал мировой рейтинг № 1 в течение двух лет. это ознаменовало завершение важной вехи в развитии искусственного интеллекта, поскольку Go-чрезвычайно сложная игра, более сложная, чем шахматы.

По словам Джека Кларка из Bloomberg, 2015 год был знаковым для искусственного интеллекта, при этом количество программных проектов, использующих ИИ в Google, увеличилось с "спорадического использования" в 2012 году до более чем 2700 проектов. Кларк также представляет фактические данные, свидетельствующие о том, что уровень ошибок в задачах обработки изображений значительно снизился с 2011 года.Он приписывает это увеличению доступных нейронных сетей, из-за роста инфраструктуры облачных вычислений и к увеличению инструментов исследования и наборов данных. Другие приведенные примеры включают разработку Microsoft системы Skype, которая может автоматически переводить с одного языка на другой, и систему Facebook, которая может описывать изображения слепым людям. в опросе 2017 года каждая пятая компания сообщила, что они "включили ИИ в некоторые предложения или процессы". около 2016 года Китай значительно ускорил свое государственное финансирование; учитывая большой объем данных и быстро растущий объем исследований, некоторые наблюдатели считают, что он может стать "сверхдержавой ИИ".

Определения[править]

Компьютерные науки определяют исследования ИИ как изучение "интеллектуальных агентов": любое устройство, которое воспринимает свою среду и принимает меры, которые максимизируют его шансы на успешное достижение своих целей. более подробное определение характеризует ИИ как “способность системы правильно интерпретировать внешние данные, учиться на таких данных и использовать эти знания для достижения конкретных целей и задач посредством гибкой адаптации.

Основы[править]

Типичный ИИ анализирует окружающую среду и предпринимает действия, которые максимизируют его шансы на успех.[54] предполагаемая функция полезности ИИ (или цель) может быть простой ("1 если ИИ выигрывает игру Go , 0 в противном случае") или сложной ("выполняйте математически аналогичные действия с теми, которые преуспели в прошлом"). Цели могут быть четко определены или индуцированы. Если ИИ запрограммирован на "обучение подкреплению", цели могут быть неявно вызваны вознаграждением некоторых типов поведения или наказанием других.[A] альтернативно, эволюционная система может вызвать цели, используя " функцию пригодности"мутировать и предпочтительно копировать системы ИИ с высоким баллом, подобно тому, как животные эволюционировали, чтобы врожденно желать определенных целей, таких как поиск пищи . некоторые системы ИИ, такие как ближайший сосед, вместо того, чтобы рассуждать по аналогии, эти системы обычно не имеют целей, за исключением той степени, что цели подразумеваются в их учебных данных. такие системы все еще могут быть оценены, если нецелевая система составлена как система, "цель" которой состоит в том, чтобы успешно выполнить свою узкую задачу классификации.

ИИ часто вращается вокруг использования алгоритмов . Алгоритм представляет собой набор однозначных инструкций, которые может выполнить механический компьютер.[b] сложный алгоритм часто строится поверх других, более простых алгоритмов. Простым примером алгоритма является следующий (оптимальный для первого игрока) рецепт игры в крестики - нолики:

- 1 Если у кого-то есть" угроза " (то есть два в ряд), возьмите оставшийся квадрат. Иначе,

- 2 если ход "раздваивается", чтобы создать две угрозы одновременно, играть этот ход. Иначе,

- 3 возьмите центральную площадь, если она свободна. Иначе,

- 4 если ваш противник играл в углу, возьмите противоположный угол. Иначе,

- 5 возьмите пустой угол, если он существует. Иначе,

- 6 возьмите любой пустой квадрат.

Многие алгоритмы ИИ способны учиться на данных; они могут улучшить себя, изучая новые эвристики (стратегии или "эмпирические правила", которые хорошо работали в прошлом), или могут сами писать другие алгоритмы. Некоторые из" учеников", описанных ниже, включая байесовские сети, деревья решений и ближайших соседей, теоретически могли бы (учитывая бесконечные данные, время и память) научиться аппроксимировать любую функцию, включая то, какая комбинация математических функций лучше всего описала бы мир. Таким образом, эти учащиеся могли бы получить все возможные знания, рассматривая все возможные гипотезы и сопоставляя их с данными. На практике почти никогда нельзя рассматривать каждую возможность из-за явления " комбинаторного взрыва ", когда количество времени, необходимое для решения задачи, растет экспоненциально. Большая часть исследований ИИ включает в себя выяснение того, как идентифицировать и избегать рассмотрения широкого спектра возможностей, которые вряд ли будут полезны. Например, при просмотре карты, и ищет самый короткий маршрут из Денвера в Нью-Йорк на Востоке, можно в большинстве случаев пропустить просмотр в любое путь через Сан-Франциско или других областях далеко на Запад; тем самым искусственным интеллектом, оперирующим алгоритм поиска пути, как в* удастся избежать комбинаторного взрыва, который наступит, если каждый возможный маршрут пришлось тяжело рассматривать в свою очередь.

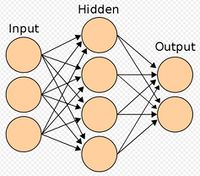

Самый ранний (и самый простой для понимания) подход к ИИ был символизмом (например, формальная логика): "если у здорового взрослого человека есть лихорадка, то у них может быть грипп ". Второй, более общий, подход-Байесовский вывод:"если у текущего пациента есть лихорадка, отрегулируйте вероятность того, что у них есть грипп таким-то образом". Третий основной подход, чрезвычайно популярный в обычных бизнес-приложениях AI, - это аналогизаторы, такие как SVM и ближайший сосед: "После изучения записей известных прошлых пациентов, у которых температура, симптомы, возраст и другие факторы в основном соответствуют текущему пациенту, у X% этих пациентов оказался грипп". Четвертый подход сложнее интуитивно понять, но вдохновлен тем, как работает механизм мозга: искусственный нейросетевой подход использует искусственные " нейроны"это можно узнать, сравнив себя с желаемым выходом и изменив сильные стороны связей между его внутренними нейронами, чтобы "укрепить" соединения, которые казались полезными . Эти четыре основных подхода могут пересекаться друг с другом и с эволюционными системами; например, нейронные сети могут научиться делать выводы, обобщать и проводить аналогии. Некоторые системы неявно или явно используют несколько из этих подходов, наряду со многими другими алгоритмами ИИ и неаи; лучший подход часто отличается в зависимости от проблемы.

Алгоритмы обучения работают на основе того, что стратегии, алгоритмы и выводы, которые хорошо работали в прошлом, скорее всего, продолжат хорошо работать в будущем. Эти выводы могут быть очевидными, например, "поскольку солнце встает каждое утро в течение последних 10 000 дней, оно, вероятно, также встанет завтра утром". Они могут быть нюансированы, например, "X% семей имеют географически отдельные виды с цветовыми вариантами, поэтому есть вероятность Y%, что существуют неоткрытые черные лебеди". Учащиеся также работают на базе " бритвы Оккама": Самая простая теория, которая объясняет данные, является самой вероятной. Поэтому, чтобы быть успешным, ученик должен быть спроектирован таким образом, чтобы он предпочитал более простые теории сложным теориям, за исключением случаев, когда сложная теория доказана существенно лучше. Установление на плохую, чрезмерно сложную теорию gerrymandered для приспособления всех прошлых данных по тренировки как overfitting . Многие системы пытаются уменьшить переобучение, поощряя теорию в соответствии с тем, насколько хорошо она соответствует данным, но наказывая теорию в соответствии с тем, насколько сложна теория. Помимо классической переобучения, учащиеся могут также разочаровать, "изучая неправильный урок". Пример игрушки - то, что классификатор изображения, обученный только на картинах коричневых лошадей и черных кошек, мог бы заключить, что все коричневые участки, вероятно, будут лошадьми. Пример реального мира-то, что, в отличие от людей, текущие классификаторы изображения не определяют пространственные отношения между компонентами изображения; вместо этого, они изучают абстрактные образцы пикселей, на которые люди не обращают внимания, но которые линейно коррелируют с изображениями определенных типов реальных объектов. Слабое наложение такого шаблона на легитимный образ приводит к" состязательному " образу, который система неверно классифицирует/

По сравнению с людьми, существующему ИИ не хватает нескольких особенностей человеческого " здравого смысла рассуждения "; прежде всего, люди имеют мощные механизмы для рассуждений о "наивной физике", такие как пространство, время и физические взаимодействия. Это позволяет даже маленьким детям легко делать выводы типа"если я скатаю эту ручку со стола, она упадет на пол". У людей также есть мощный механизм " народной психологии"это помогает им интерпретировать предложения на естественном языке, такие как "члены городского совета отказали демонстрантам в разрешении, потому что они выступали за насилие". (Общий ИИ затрудняется сделать вывод о том, являются ли члены совета или демонстранты теми, кто якобы выступает за насилие .) Это отсутствие "общих знаний" означает, что ИИ часто делает разные ошибки, чем люди, способами, которые могут показаться непонятными. Например, существующие самоходные автомобили не могут рассуждать о местоположении или намерениях пешеходов точно так, как это делают люди, и вместо этого должны использовать нечеловеческие способы рассуждения, чтобы избежать несчастных случаев .

Проблемы[править]

Общая цель исследования искусственного интеллекта заключается в создании технологии, которая позволяет компьютерам и машинам функционировать разумным образом. Общая проблема моделирования (или создания) интеллекта была разбита на подзадачи. Они состоят из определенных черт или возможностей, которые исследователи ожидают, что интеллектуальная система покажет. Черты, описанные ниже, получили наибольшее внимание.

Рассуждения, решение проблем[править]

Ранние исследователи разработали алгоритмы, которые имитировали пошаговые рассуждения, которые люди используют, когда они решают головоломки или делают логические выводы.[79] к концу 1980-х и 1990-х годов исследования ИИ разработали методы работы с неопределенной или неполной информацией, используя концепции вероятности и экономики .

Эти алгоритмы оказались недостаточными для решения больших задач рассуждения, потому что они испытали "комбинаторный взрыв": они стали экспоненциально медленнее, поскольку проблемы стали больше.Фактически, даже люди редко используют пошаговую дедукцию, которую смогли смоделировать ранние исследования ИИ . Они решают большинство своих проблем, используя быстрые, интуитивные суждения.

Представление знаний[править]

Основные статьи: Представление знаний и знание здравого смысла

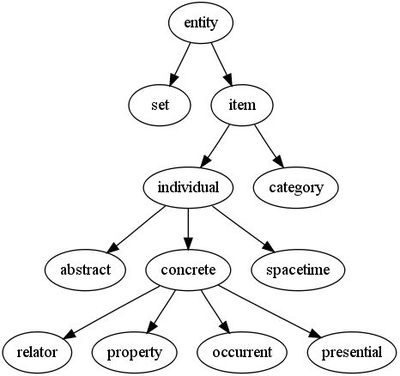

Представление знаний и инженерия знаний являются центральными в классических исследованиях ИИ. Некоторые "экспертные системы" пытаются собрать воедино явные знания, которыми обладают эксперты в какой-то узкой области. Кроме того, в некоторых проектах предпринимается попытка собрать "знания здравого смысла", известные обычному человеку, в базу данных, содержащую обширные знания о мире. Среди вещей, которые содержала бы всесторонняя база знаний здравого смысла: объекты, свойства, категории и отношения между объектами; ситуации, события, состояния и время ;причины и следствия;] знание о знании (то, что мы знаем о том, что знают другие люди); и многие другие, менее хорошо изученные области. Представление" того, что существует " - это онтология : набор объектов, отношений, понятий и свойств, формально описанных так, чтобы программные агенты могли их интерпретировать. Семантика этих понятий фиксируется как понятия логики описания, роли и отдельные лица и обычно реализуется как классы, свойства и отдельные лица на языке веб-онтологии .[88] наиболее общие онтологии называются верхними онтологиями, которые пытаются обеспечить основу для всех других знаний действуя как посредники между онтологиями предметной области, охватывающими конкретные знания об определенной предметной области (области интересов или области интересов). Такие формальные представления знаний могут использоваться в индексации и поиске на основе содержания, интерпретации сцены, клинической поддержке принятия решений, открытии знаний (разработка "интересных" и действенных выводов из больших баз данных), и других областях.

Среди наиболее сложных проблем в представлении знаний:

Рассуждения по умолчанию и проблема квалификации=[править]

Многие вещи, которые люди знают, принимают форму "рабочих предположений". Например, если в разговоре появляется птица, люди обычно представляют себе животное размером с кулак, которое поет и летает. Все это не относится ко всем птицам. Джон Маккарти определил эту проблему в 1969 как проблему квалификации: для любого правила здравого смысла, которое исследователи ИИ заботятся представлять, как правило, существует огромное количество исключений. Почти ничто не является просто истинным или ложным, как того требует абстрактная логика. Исследования ИИ изучили ряд решений этой проблемы.

Широта знаний здравого смысла[править]

Число атомарных фактов, известных среднему человеку, очень велико. Исследовательские проекты, которые пытаются построить полную базу знаний о здравом смысле (например, Cyc), требуют огромного количества трудоемкой онтологической инженерии —они должны быть построены вручную, по одной сложной концепции за раз.

Субсимволическая форма некоторого знания здравого смысла[править]

Многое из того, что люди знают, не представлено как "факты" или "утверждения", которые они могли бы выразить устно. Например, шахматист избегает определенной шахматной позиции, потому что" чувствует себя слишком уязвимым " , или искусствовед может взглянуть на статую и понять, что это подделка.Это бессознательные и субсимволические интуиции или тенденции в человеческом мозге.Такое знание информирует, поддерживает и обеспечивает контекст для символического, сознательного знания. Как и в связанной с этим проблеме субсимволического рассуждения, есть надежда, что расположенный ИИ, вычислительный интеллект или статистический ИИ обеспечит способы представления такого рода знаний.

Планирование[править]

Главная статья: автоматизированное планирование и планирование

Интеллектуальные агенты должны уметь ставить цели и достигать их.Им нужен способ визуализировать будущее—представлять состояние мира и быть способными делать прогнозы о том, как их действия изменят его—и быть способными делать выбор, который максимизирует полезность (или "ценность") доступных выборов.

В классических задачах планирования агент может предположить, что это единственная система, действующая в мире, позволяющая агенту быть уверенным в последствиях своих действий.[103] однако, если агент не является единственным действующим лицом, то он требует, чтобы агент мог рассуждать в условиях неопределенности. Это требует агента, который может не только оценивать свою среду и делать прогнозы, но также оценивать свои прогнозы и адаптироваться на основе своей оценки.

Мультиагентное планирование использует сотрудничество и конкуренцию многих агентов для достижения данной цели. Такое эмерджентное поведение используется эволюционными алгоритмами и роевым интеллектом.

Обучение[править]

Главная статья: машинное обучение

Машинное обучение (ML ), фундаментальная концепция исследования ИИ с момента создания поля, является изучение компьютерных алгоритмов, которые улучшаются автоматически через опыт.

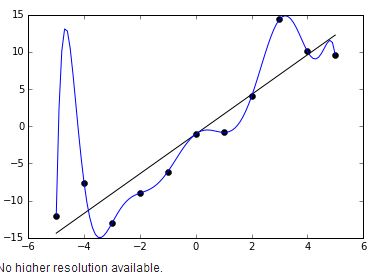

Неконтролируемое обучение-это способность находить шаблоны в потоке входных данных, не требуя, чтобы человек сначала помечал входные данные. Контролируемое обучение включает в себя как классификацию , так и числовую регрессию, которая требует, чтобы человек сначала маркировал входные данные. Классификация используется, чтобы определить, к какой категории что-то принадлежит, и происходит после того, как программа видит много примеров вещей из нескольких категорий. Регрессия-это попытка создать функцию, которая описывает взаимосвязь между входами и выходами и предсказывает, как должны изменяться выходы при изменении входов. И классификаторы, и изучающие регрессию можно рассматривать как "аппроксиматоры функций", пытающиеся изучить неизвестную (возможно неявную) функцию; например, классификатор спама можно рассматривать как изучение функции, которая сопоставляется с текстом электронной почты одной из двух категорий: "спам" или "не спам". Вычислительная теория обучения может оценивать учащихся по сложности вычислений, сложности выборки (сколько данных требуется) или по другим понятиям оптимизации . в обучении подкрепления агент вознаграждается за хорошие ответы и наказывается за плохие. Агент использует эту последовательность вознаграждений и наказаний для формирования стратегии работы в своем проблемном пространстве.

Обработка естественного языка[править]

Основная статья: обработка естественного языка

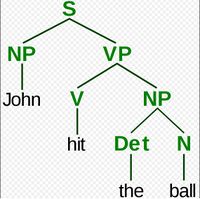

Обработка естественного языка (НЛП) дает машинам возможность читать и понимать человеческий язык . Достаточно мощная система обработки данных на естественном языке позволит использовать интерфейсы пользователей на естественном языке и получать знания непосредственно из письменных источников, таких как тексты новостей. Некоторые простые приложения обработки естественного языка включают поиск информации ,интеллектуальный анализ текста, ответы на вопросы и машинный перевод. Многие современные подходы используют частоты встречаемости слов для построения синтаксических представлений текста. Стратегии поиска" ключевых слов "популярны и масштабируемы, но глупы; поисковый запрос для" собаки "может соответствовать только документам с буквальным словом" собака "и пропустить документ со словом"пудель". Стратегии "лексического сродства" используют появление таких слов, как "несчастный случай" для оценки настроения документа. Современные статистические подходы к НЛП могут сочетать все эти стратегии, а также другие, и часто достигают приемлемой точности на уровне страницы или абзаца, но по-прежнему не имеют семантического понимания, необходимого для хорошей классификации изолированных предложений. Помимо обычных трудностей с кодированием знаний семантического здравого смысла, существующее семантическое НЛП иногда слишком плохо масштабируется, чтобы быть жизнеспособным в бизнес-приложениях. Помимо семантического НЛП, конечной целью "нарративного" НЛП является воплощение полного понимания здравого смысла.

Восприятие[править]

Основные статьи: машинное восприятие, компьютерное зрение, распознавание речи

Машинное восприятие-способность использовать входные данные от датчиков (таких как камеры (видимый спектр или инфракрасный), микрофоны, беспроводные сигналы и активный лидар, гидролокатор , радар и тактильные датчики), чтобы вывести аспекты мира . Приложения включают распознавание речи , распознавание лиц и распознавание объектов . компьютерное зрение возможность анализа визуального ввода. Такой ввод обычно неоднозначен; гигантский пятидесятиметровый пешеход, находящийся далеко, может производить точно такие же пиксели, что и соседний пешеход нормального размера, требуя, чтобы ИИ оценивал относительную вероятность и разумность различных интерпретаций, например, используя свою "объектную модель", чтобы оценить, что пятидесятиметровых пешеходов не существует/

Движение и манипуляция[править]

ИИ активно используется в робототехнике .Продвинутые роботизированные руки и другие промышленные роботы , широко используемые на современных фабриках, могут учиться на опыте, как эффективно двигаться несмотря на присутствие трения и проскальзывания механизма.Современный мобильный робот, при наличии небольшой, статической и видимой среды, может легко определить свое местоположение и отобразить свою среду; однако динамические среды, такие как (в эндоскопии ) интерьер дыхательного тела пациента, представляют большую проблему. Планирование движения процесс ломать вниз с задачи движения в "примитивы"как индивидуальные совместные движения. Такое движение часто включает податливое движение, процесс, в котором движение требует поддержания физического контакта с объектом.Парадокс Моравека обобщает, что низкоуровневые сенсомоторные навыки, которые люди принимают как должное, парадоксально, трудно запрограммировать в робота; парадокс назван в честь Ханса Моравека ВОЗ заявила в 1988 году, что "сравнительно легко заставить компьютеры демонстрировать производительность взрослого уровня на тестах интеллекта или игре в шашки и трудно или невозможно дать им навыки годовалого ребенка, когда речь идет о восприятии и мобильности". это объясняется тем, что, в отличие от шашек, физическая ловкость была прямой целью естественного отбора в течение миллионов лет.

Социальный интеллект[править]

Основная статья: Аффективные вычисления

Парадокс Моравека можно распространить на многие формы социального интеллекта. распределенная многоагентная координация автономных транспортных средств остается сложной проблемой. Аффективное вычисление-междисциплинарный зонтик, который включает системы, которые признают, интерпретируют, обрабатывают или моделируют человеческие аффекты . умеренные успехи, связанные с аффективными вычислениями, включают анализ текстовых настроений и, в последнее время, мультимодальный анализ аффектов (см. мультимодальный анализ настроений), в котором ИИ классифицирует аффекты, отображаемые видеозаписываемым субъектом.

В долгосрочной перспективе социальные навыки и понимание человеческих эмоций и теории игр будут ценными для социального агента. Способность предсказывать действия других, понимая их мотивы и эмоциональные состояния, позволит агенту принимать лучшие решения. Некоторые компьютерные системы имитируют человеческие эмоции и выражения, чтобы казаться более чувствительными к эмоциональной динамике человеческого взаимодействия или иным образом облегчить взаимодействие человека и компьютера . точно так же некоторые виртуальные помощники запрограммированы говорить разговорно или даже шутливо подшучивать; это, как правило, дает наивным пользователям нереалистичное представление о том, насколько интеллектуальны существующие компьютерные агенты на самом деле.

Общая разведка[править]

Основные статьи: Искусственный общий интеллект и ИИ-полный

Исторически такие проекты, как Cyc knowledge base (1984–) и крупная японская инициатива по компьютерным системам пятого поколения (1982-1992), пытались охватить широту человеческого познания. Эти ранние проекты не смогли избежать ограничений неколичественных символических логических моделей и, оглядываясь назад, сильно недооценили трудность междоменного ИИ. В настоящее время подавляющее большинство современных исследователей ИИ вместо этого работают над совместимыми приложениями "узкого ИИ" (такими как медицинская диагностика или автомобильная навигация). Многие исследователи предсказывают, что такая" узкая ИИ " работа в разных отдельных областях в конечном итоге будет включена в машину с искусственным общим интеллектом (AGI), сочетая большинство узких навыков, упомянутых в этой статье, и в какой-то момент даже превысит человеческие способности в большинстве или во всех этих областях. многие достижения имеют общее междоменное значение. Одним из громких примеров является то, что DeepMind в 2010-х годах разработал "обобщенный искусственный интеллект", который мог самостоятельно изучать множество разнообразных игр Atari, а затем разработал вариант системы, которая преуспевает в последовательное обучение . помимо обучения передаче, гипотетические прорывы AGI могут включать в себя разработку рефлексивных архитектур, которые могут участвовать в теоретико-решающем метарешении, и выяснение того, как "хлебать" всеобъемлющую базу знаний из всей неструктурированной сети . Некоторые утверждают, что какой-то (в настоящее время нераскрытый) концептуально простой, но математически сложный "мастер-алгоритм" может привести к AGI.Наконец, несколько "эмерджентных" подходов очень внимательно относятся к моделированию человеческого интеллекта и полагают, что антропоморфные такие функции, как искусственный мозг или имитация развития ребенка, могут когда-нибудь достичь критической точки, где появляется общий интеллект.

Многие из проблем в этой статье также может потребоваться общий интеллект, если машины, чтобы решить проблемы, а также люди делают. Например, даже конкретные простые задачи , такие как машинный перевод, требуют, чтобы машина читала и писала на обоих языках ( НЛП), следила за аргументом автора ( причина), знала, о чем говорят ( знание), и точно воспроизводила первоначальное намерение автора ( социальный интеллект ). Такой проблемой, как машинный перевод, считается " AI-complete"потому что все эти проблемы должны быть решены одновременно, чтобы достичь производительности машины человеческого уровня.

Подходы[править]

Не существует установленной объединяющей теории или парадигмы, которая руководит исследованиями ИИ. Исследователи расходятся во мнениях по многим вопросам.Некоторые из самых давних вопросов, которые остались без ответа, таковы: должен ли искусственный интеллект имитировать естественный интеллект, изучая психологию или нейробиологию ? Или биология человека так же не имеет отношения к исследованиям ИИ, как биология птиц к авиационной технике ?[15] Можно ли описать интеллектуальное поведение с помощью простых, элегантных принципов (таких как логика или оптимизация )? Или это обязательно требует решения большого количества совершенно не связанных между собой проблем?

Кибернетика и моделирование мозга[править]

Основные статьи: кибернетика и вычислительная нейробиология

В 1940-х и 1950-х годах ряд исследователей исследовали связь между нейробиологией, теорией информации и кибернетикой . Некоторые из них построили машины, которые использовали электронные сети для демонстрации элементарного интеллекта, такие как черепахи У. Грея Уолтера и зверь Джона Хопкинса . Многие из этих исследователей собрались на встречи телеологического общества Принстонского университета и клуба Ratio в Англии.К 1960 этот подход был в значительной степени оставлен, хотя элементы его были бы возрождены в 1980-х.

Символический[править]

Когда доступ к цифровым компьютерам стал возможен в середине 1950-х годов, исследования ИИ начали исследовать возможность того, что человеческий интеллект может быть сведен к манипуляции символами. Исследование было сосредоточено в трех институтах: Университет Карнеги-Меллона , Стэнфорд и MIT , и, как описано ниже, каждый из них разработал свой собственный стиль исследований. Джон Хогеланд назвал эти символические подходы к ИИ " старым добрым ИИ "или " ГОФАЙ".В течение 1960-х годов символические подходы добились больших успехов в моделировании мышления высокого уровня в небольших демонстрационных программах . Подходы, основанные на кибернетика или искусственные нейронные сети были оставлены или отодвинуты на задний план.[149] Исследователи в 1960-х и 1970-х годах были убеждены, что символические подходы в конечном итоге преуспеют в создании машины с искусственным общим интеллектом и считали это целью своей области.

Когнитивное моделирование[править]

Экономист Герберт Саймон и Аллен Ньюэлл изучали человеческие навыки решения проблем и пытались их формализовать, а их работа заложила основы области искусственного интеллекта, а также когнитивистики , исследования операций и науки управления . Их исследовательская группа использовала результаты психологических экспериментов для разработки программ, имитирующих методы, которые люди использовали для решения проблем. Эта традиция, сосредоточенная в Университете Карнеги-Меллона, в конечном итоге достигнет кульминации в развитии архитектуры Soar в середине 1980-х годов.

На основе логики[править]

В отличие от Саймона и Ньюэлла, Джон Маккарти считал, что машины не должны имитировать человеческую мысль, а должны вместо этого попытаться найти суть абстрактного рассуждения и решения проблем, независимо от того, используют ли люди одни и те же алгоритмы.Его лаборатория в Стэнфорде ( SAIL ) сосредоточилась на использовании формальной логики для решения широкого спектра проблем, включая представление знаний , планирование и обучение . логика была также центром работы в Эдинбургском университете и в других странах Европы, которая привела к развитию пролога языка программирования и науки логического программирования.

Анти-логика или неряшливый[править]

Исследователи из Массачусетского технологического института (например, Марвин Мински и Сеймур Паперт ) обнаружили, что решение сложных проблем в области зрения и обработки естественного языка требует специальных решений-они утверждали, что не существует простого и общего принципа (например, логики), который охватывал бы все аспекты интеллектуального поведения. Роджер Шенк описал их" антилогические "подходы как" неряшливые "(в отличие от "аккуратных" парадигм в КМУ и Стэнфорде). базы знаний здравого смысла (такие как Cyc Дуга Лената ) являются примером "неряшливого" ИИ, поскольку они должны быть построены вручную, по одной сложной концепции за раз.

На основе знаний[править]

Когда компьютеры с большой памятью стали доступны примерно в 1970 году, исследователи из всех трех традиций начали внедрять знания в приложения ИИ.Эта "революция знаний" привела к разработке и внедрению экспертных систем (введенных Эдвардом Фейгенбаумом ), первой по-настоящему успешной формы программного обеспечения ИИ. ключевым компонентом архитектуры системы для всех экспертных систем является база знаний, в которой хранятся факты и правила, иллюстрирующие ИИ. Революция знаний была также обусловлена осознанием того, что огромное количество знаний потребуется для многих простых приложений ИИ.

Субсимвольный[править]

К 1980-м годам прогресс в символическом ИИ, казалось, остановился , и многие полагали , что символические системы никогда не смогут имитировать все процессы человеческого познания, особенно восприятие, робототехнику, обучение и распознавание образов . Ряд исследователей начали изучать "субсимволические" подходы к конкретным проблемам ИИ. Субсимволическим методам удается приблизиться к интеллекту без определенных представлений о знании.

Воплощенный интеллект[править]

Это включает в себя воплощенный , расположенный , основанный на поведении и новый ИИ . Исследователи из смежной области робототехники , такие как Родни Брукс, отвергли символический ИИ и сосредоточились на основных инженерных проблемах, которые позволят роботам двигаться и выживать.Их работа возродила несимволическую точку зрения ранних исследователей кибернетики 1950-х годов и вновь ввела использование теории управления в ИИ. Это совпало с развитием тезиса "воплощенный ум" в смежной области когнитивной науки идея, что аспекты тела (такие как движение, восприятие и визуализация) необходимы для более высокого интеллекта.

В рамках робототехники развития разрабатываются подходы к обучению развитию, позволяющие роботам накапливать репертуары новых навыков посредством автономного самоисследования, социального взаимодействия с учителями-людьми и использования механизмов руководства (активное обучение, созревание, моторные синергии и т. д.).).

Вычислительный интеллект и мягкие вычисления[править]

Интерес к нейронным сетям и "коннекционизму" был возрожден Дэвидом Румельхартом и другими в середине 1980-х годов. искусственные нейронные сети являются примером мягких вычислений —это решения задач, которые не могут быть решены с полной логической уверенностью, и где приблизительное решение часто бывает достаточным. Другие мягкие вычислительные подходы к ИИ включают нечеткие системы , теорию серых систем, эволюционные вычисления и многие статистические инструменты. Применение мягких вычислений к ИИ изучается коллективно развивающейся дисциплиной вычислительного интеллекта .

Статистическое обучение[править]

Большая часть традиционных GOFAI увязла в специальных патчах для символических вычислений, которые работали над собственными игрушечными моделями, но не смогли обобщить результаты в реальном мире. Однако примерно в 1990-х годах исследователи ИИ приняли сложные математические инструменты, такие как скрытые марковские модели (хмм), теория информации и нормативная байесовская теория решений для сравнения или унификации конкурирующих архитектур. Общий математический язык позволил высокий уровень сотрудничества с более устоявшимися областями (такими как математика , экономика или исследования операций ).[d] По сравнению с GOFAI, новые методы "статистического обучения", такие как HMM и нейронные сети, получали более высокие уровни точности во многих практических областях, таких как интеллектуальный анализ данных, без необходимости получения семантического понимания наборов данных. Увеличенные успехи с реальными данными привели к увеличению акцента на сравнении различных подходов против общих тестовых данных, чтобы видеть, какой подход выполнил лучше всего в более широком контексте, чем обеспеченный особыми игрушечными моделями; исследование ИИ становилось более научным. В настоящее время результаты экспериментов часто строго измеримы, а иногда (с трудом) воспроизводимы.различные статистические методы обучения имеют различные ограничения; например, basic HMM не может моделировать бесконечные возможные комбинации естественного языка.[166] критики отмечают, что переход от ГОФАЯ к статистическому обучению часто также является отходом от объяснимого ИИ . В исследованиях AGI некоторые ученые предостерегают от чрезмерной зависимости от статистического обучения и утверждают, что продолжение исследований в GOFAI по-прежнему будет необходимо для достижения общего интеллекта.

Интеграция подходов[править]

Парадигма интеллектуального агента[править]

Интеллектуальный агент-это система, которая воспринимает окружающую среду и предпринимает действия, максимизирующие ее шансы на успех. Простейшие интеллектуальные агенты-это программы, которые решают конкретные задачи. Более сложные агенты включают людей и организации людей (такие как фирмы). Парадигма позволяет исследователям непосредственно сравнивать или даже комбинировать различные подходы к изолированным проблемам, спрашивая, какой агент лучше всего максимизирует данную "целевую функцию". Агент, который решает конкретную проблему, может использовать любой подход, который работает—некоторые агенты являются символическими и логическими, некоторые являются субсимвольными искусственными нейронными сетями, а другие могут использовать новые подходы. Парадигма также дает исследователям общий язык для общения с другими областями—такими как теория принятия решений а экономика-то еще и использует понятия абстрактных агентов. Создание полноценного агента требует от исследователей решения реалистичных проблем интеграции; например, поскольку сенсорные системы дают неопределенную информацию об окружающей среде, системы планирования должны быть способны функционировать в условиях неопределенности. Парадигма интеллектуальных агентов получила широкое признание в 1990-е годы.

Архитектуры агентов и когнитивные архитектуры[править]

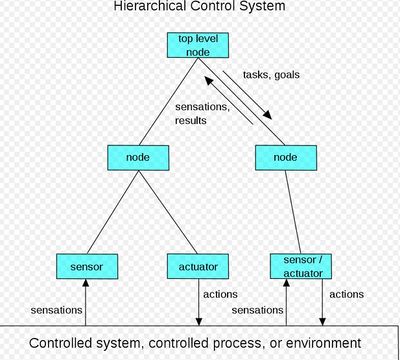

Исследователи разработали системы для построения интеллектуальных систем из взаимодействующих интеллектуальных агентов в мультиагентной системе .Иерархическая система управления обеспечивает мост между субсимвольным ИИ на его самых низких, реактивных уровнях и традиционным символическим ИИ на его самых высоких уровнях, где ослабленные временные ограничения позволяют планирование и моделирование мира.Некоторые когнитивные архитектуры построены по индивидуальному заказу для решения узкой проблемы; другие, такие как Soar , предназначены для имитации человеческого познания и обеспечения понимания общего интеллекта. Современные расширения Soar-это гибридные интеллектуальные системы к ним относятся как символические, так и субсимвольные компоненты.

Инструменты[править]

ИИ разработал большое количество инструментов для решения самых сложных задач в информатике . Некоторые из наиболее общих этих методов рассматриваются ниже.

Поиск и оптимизация[править]

Основные статьи: Алгоритм поиска, Математическая оптимизация и Эволюционные вычисления

Многие проблемы в ИИ могут быть решены теоретически путем разумного поиска многих возможных решений : рассуждения могут быть сведены к выполнению поиска. Например, логическое доказательство можно рассматривать как поиск пути , ведущего от предпосылок к выводам, где каждый шаг является применением правила вывода . алгоритмы планирования выполняют поиск по деревьям целей и подцелей, пытаясь найти путь к целевой цели, процесс, называемый анализом средних целей .Алгоритмы робототехники для перемещения конечностей и захвата объектов используют локальные поиски в конфигурационном пространстве . много обучения алгоритмы используют алгоритмы поиска, основанные на оптимизации .

Простые исчерпывающие поиски редко достаточны для большинства реальных задач: пространство поиска (число мест для поиска) быстро растет до астрономических чисел . В результате поиск выполняется слишком медленно или никогда не завершается. Решение многих проблем заключается в использовании "эвристики" или "эмпирических правил", которые определяют приоритетность выбора в пользу тех, которые с большей вероятностью достигнут цели, и делают это за меньшее количество шагов. В некоторых методологиях поиска эвристика может также служить для полного устранения некоторых вариантов, которые вряд ли приведут к цели (так называемая " обрезка дерева поиска "). Эвристика предоставляет программе "лучшее предположение" о пути, по которому лежит решение.Эвристика ограничивает поиск решений меньшим размером выборки.

В 1990-х годах на первый план вышел совсем другой вид поиска, основанный на математической теории оптимизации . Для многих проблем можно начать поиск с некоторой формы предположения, а затем постепенно уточнять предположение, пока не будет сделано больше уточнений. Эти алгоритмы могут быть визуализированы как восхождение на холм вслепую: мы начинаем поиск в случайной точке ландшафта, а затем, прыжками или шагами, продолжаем двигаться вверх, пока не достигнем вершины. Другими алгоритмами оптимизации являются моделирование отжига, поиск пучка и случайная оптимизация .

Эволюционное вычисление использует форму оптимизационного поиска. Например, они могут начать с популяции организмов (догадок), а затем позволить им мутировать и рекомбинировать, отбирая только наиболее приспособленных для выживания каждого поколения (уточняя догадки). Классические эволюционные алгоритмы включают генетические алгоритмы , программирование экспрессии генов и генетическое программирование . альтернативно, процессы распределенного поиска могут координировать друг друга с помощью алгоритмов роевого интеллекта. Два популярных алгоритма Роя, используемых в поиске, - оптимизация роя частиц (вдохновленная птичьим стаей) и оптимизация колонии муравьев (вдохновленная муравьиными тропами).

Логика[править]

Основные статьи: Логическое программирование и Автоматизированное мышление

Логика используется для представления знаний и решения задач, но может быть применена и к другим задачам. Например, алгоритм satplan использует логику для планирования , а индуктивное логическое программирование является методом обучения .

Несколько различных форм логики используются в исследованиях ИИ. Пропозициональная логика включает в себя функции истины, такие как "или" и "не". Логика первого порядка добавляет кванторы и предикаты и может выражать факты об объектах , их свойствах и их отношениях друг с другом. Теория нечетких множеств присваивает" степень истинности "(от 0 до 1) неопределенным утверждениям, таким как" Алиса стара " (или богата, или высока, или голодна), которые слишком лингвистически неточны, чтобы быть полностью истинными или ложными. Нечеткая логика успешно используется в системах управления чтобы позволить экспертам внести неопределенные правила ,такие как" если вы находитесь близко к станции назначения и двигаетесь быстро, увеличьте тормозное давление поезда"; эти неопределенные правила затем могут быть численно уточнены в системе. Нечеткая логика не может хорошо масштабироваться в базах знаний; многие исследователи ИИ ставят под сомнение обоснованность цепочки выводов нечеткой логики.[e]

Логика по умолчанию, немонотонная логика и ограничение являются формами логики, разработанной, чтобы помочь с рассуждением по умолчанию и проблемой квалификации . Несколько расширений логики были разработаны , чтобы обращаться с определенными областями знания , такими как: логика описания; исчисление ситуации, исчисление событий и беглое исчисление (для представления событий и времени); причинное исчисление; исчисление веры; и модальные логики .

В целом, качественная символическая логика хрупка и плохо масштабируется при наличии шума или другой неопределенности. Исключения из правил многочисленны, и логическим системам трудно функционировать при наличии противоречивых правил.

Вероятностные методы для неопределенного рассуждения[править]

Основные статьи: Байесовская сеть, Скрытая Марковская модель, Фильтр Калмана, Фильтр частиц, Теория решений и Теория полезности

Многие проблемы ИИ (в рассуждении, планировании, обучении, восприятии и робототехнике) требуют от агента оперировать неполной или неопределенной информацией. Исследователи ИИ разработали ряд мощных инструментов для решения этих проблем с использованием методов теории вероятностей и экономики.

Байесовские сети очень общий инструмент, который может быть использован для большого количества проблем: рассуждения (с использованием байесовского вывода алгоритма),[196] обучение (с помощью ожидания-максимизации алгоритм),[Ф] планирования (используя решение сетей) и восприятия (с использованием динамических байесовских сетей).Вероятностные алгоритмы могут также использоваться для фильтрации, предсказания, сглаживания и нахождения объяснений потоков данных, помогая системам восприятия анализировать процессы, которые происходят в течение долгого времени (например, скрытые модели Маркова или фильтры Калмана ). По сравнению с символической логикой формальный Байесовский вывод требует больших вычислительных затрат. Для того чтобы вывод был поддающимся обработке, большинство наблюдений должны быть условно независимыми друг от друга. Сложные графики с алмазами или другими" петлями " (неориентированные циклы ) могут потребовать сложного метода , такого как цепь Маркова Монте-Карло, которая распространяет ансамбль случайных ходоков по всей байесовской сети и пытается сходиться к оценке условных вероятностей. Байесовские сети используются на Xbox Live для оценки и сопоставления игроков; победы и потери являются "доказательством" того, насколько хорош игрок. AdSense использует байесовскую сеть с более чем 300 миллионами ребер, чтобы узнать, какие объявления обслуживать.

Ключевым понятием в экономической науке является "полезность": мера того, насколько что-то ценно для интеллектуального агента. Были разработаны точные математические инструменты, которые анализируют, как агент может делать выбор и планировать , используя теорию решений, анализ решений и теорию ценности информации .Эти инструменты включают модели, такие как Марковские процессы принятия решений, динамические сети принятия решений, теория игр и проектирование механизмов .

Классификаторы и статистические методы обучения[править]

Основные статьи: классификатор (математика), статистическая классификация и машинное обучение

Простейшие приложения AI можно разделить на два типа: классификаторы ("если блестящий, то алмаз") и контроллеры ("если блестящий, то забрать"). Однако контроллеры также классифицируют условия перед выводом действий, и поэтому классификация является центральной частью многих систем ИИ. Классификаторы-это функции, использующие сопоставление шаблонов для определения ближайшего совпадения. Они могут быть настроены в соответствии с примерами, что делает их очень привлекательными для использования в ИИ. Эти примеры известны как наблюдения или модели. В контролируемом обучении каждый шаблон принадлежит определенному предопределенному классу. Класс можно рассматривать как решение, которое должно быть принято. Все наблюдения в сочетании с метками классов называются набором данных. Когда получено новое наблюдение, это наблюдение классифицируется на основе предыдущего опыта.

Классификатор может быть обучен различным образом; существует множество статистических и машинных подходов к обучению. Дерево решений является, пожалуй, наиболее широко используемым алгоритмом машинного обучения. другими широко используемыми классификаторами являются нейронная сеть , K-алгоритм ближайшего соседа , [g] методы ядра, такие как машина вектора поддержки (SVM), [h] Гауссовская модель смеси, и чрезвычайно популярный наивный классификатор Байеса . Производительность классификатора во многом зависит от характеристик классифицируемых данных, таких как размер набора данных, распределение выборок по классам, размерность и уровень шума. Классификаторы на основе моделей хорошо работают, если предполагаемая модель очень хорошо подходит для фактических данных. В противном случае, если нет подходящей модели, и если точность (а не скорость или масштабируемость) является единственной проблемой, общепринятая мудрость заключается в том, что дискриминационные классификаторы (особенно SVM), как правило, более точны, чем классификаторы на основе моделей, такие как "наивные Байи" на большинстве практических наборов данных.

Искусственные нейронные сети[править]

Основные статьи: искусственная нейронная сеть и Коннекционизм

Нейронные сети, или нейронные сети, были вдохновлены архитектурой нейронов в человеческом мозге. Простой "нейрон" N принимает входные данные от нескольких других нейронов, каждый из которых при активации (или "выстреле") отдает взвешенный "голос" за или против того, должен ли сам нейрон N активироваться. Обучение требует алгоритма для настройки этих весов на основе данных обучения; один простой алгоритм (дублированный " огонь вместе, провод вместе") увеличить вес между 2 Соединенными невронами когда активация одного вызывает успешную активацию других. Сеть формирует "понятия", которые распределены между подсетью shared [j] нейроны, которые имеют тенденцию стрелять вместе; понятие, означающее "нога", может быть связано с подсетью, означающей" нога", которая включает звук для"ноги". Нейроны имеют непрерывный спектр активации; кроме того, нейроны могут обрабатывать входные данные нелинейным способом, а не взвешивать простые голоса. Современные нейронные сети могут изучать как непрерывные функции, так и, что удивительно, цифровые логические операции. Первые успехи нейронных сетей включали в себя прогнозирование фондового рынка и (в 1995 году) в основном самоуправляемый автомобиль.[k] В 2010-х годах Достижения в области нейронных сетей с использованием глубокого обучения подтолкнули ИИ к широкому распространению общественного сознания и способствовали огромному сдвигу в корпоративных расходах на ИИ; например, связанные с ИИ M&A в 2017 году были более чем в 25 раз больше, чем в 2015 году.

Изучение необучаемых искусственных нейронных сетей [207] началось за десятилетие до того, как была основана область исследований ИИ, в работе Уолтера Питтса и Уоррена Маккаллача . Фрэнк Розенблатт изобрел персептрон, обучающую сеть с одним слоем, похожую на старую концепцию линейной регрессии . Ранние пионеры также включают Алексея Григорьевича Ивахненко , Теуво Кохонена , Стивена Гроссберга , Кунихико Фукусиму, Кристофа фон дер Мальсбурга, Дэвида Уилшоу , Шун-Ичи Амари , Бернарда Уидроу , Джона Хопфилда , Эдуардо Р. Кайаниелло и других.

Основными категориями сетей являются ациклические или прямые нейронные сети (где сигнал проходит только в одном направлении) и рекуррентные нейронные сети (которые позволяют обратную связь и краткосрочные воспоминания о предыдущих входных событиях). Среди наиболее популярных сетей прямой связи-перцептроны , многослойные перцептроны и радиальные базисные сети . нейронные сети могут быть применены к проблеме интеллектуального управления (для робототехники) или обучения , используя такие методы, как обучение Hebbian ("огонь вместе, провод вместе"), GMDH или конкурентное обучение .

Сегодня нейронные сети часто обучаются алгоритмом обратного распространения, который был вокруг с 1970 как обратный режим автоматического дифференцирования, изданного Seppo Linnainmaa, и был введен в нейронные сети полом Вербосом .

Иерархическая временная память-это подход, моделирующий некоторые структурные и алгоритмические свойства неокортекса .

Подводя итог, большинство нейронных сетей используют некоторую форму градиентного спуска на созданной вручную нейронной топологии. Однако некоторые исследовательские группы , такие как Uber, утверждают, что простая нейроэволюция для мутации новых топологий и весов нейронных сетей может конкурировать со сложными подходами градиентного спуска. Одним из преимуществ нейроэволюции является то, что она может быть менее подвержена попаданию в "тупики.

Глубокие нейронные сети прямой связи[править]

Основная статья: Глубокое обучение Глубокое обучение - это любая искусственная нейронная сеть, которая может изучить длинную цепь причинных связей. Например, сеть прямой связи с шестью скрытыми слоями может изучать причинно-следственную цепочку с семью звеньями (шесть скрытых слоев + выходной слой) и имеет "путь назначения кредита" (CAP) глубиной семь. Многие системы глубокого обучения должны иметь возможность изучать цепочки длиной в десять и более причинных связей.Глубокое обучение трансформировало многие важные подполя искусственного интеллекта, включая компьютерное зрение , распознавание речи , обработку естественного языка и другие.

Согласно одному обзору, выражение " глубокое обучение "было введено в сообщество машинного обучения Риной дехтер в 1986 и получило тягу после Игорь Айзенберг и его коллеги познакомили его с искусственными нейронными сетями в 2000 году.Первые функциональные сети глубокого обучения были опубликованы Алексеем Григорьевичем Ивахненко и В. Г. лапой в 1965 году . эти сети обучаются по одному слою за раз. Статья Ивахненко 1971 года описывает изучение глубокого многослойного персептрона прямой связи с восемью слоями, уже намного более глубокими, чем многие более поздние сети. В 2006 году в публикации Джеффри Хинтона и Руслана Салахутдинова был представлен еще один способ предварительной подготовки многослойных нейронных сетей прямой связи (FNN) по одному слою за раз, рассматривая каждый слой по очереди как неконтролируемую ограниченную машину Больцмана , а затем используя контролируемое обратное распространение для тонкой настройки. Подобно мелким искусственным нейронным сетям, глубокие нейронные сети могут моделировать сложные нелинейные отношения. За последние несколько лет прогресс как в алгоритмах машинного обучения, так и в компьютерном оборудовании привел к более эффективным методам обучения глубоких нейронных сетей, которые содержат много слоев нелинейных скрытых единиц и очень большой выходной уровень.

Глубокое обучение часто использует сверточные нейронные сети (CNNs), происхождение которых можно проследить до Неокогнитрона, введенного Кунихико Фукусимой в 1980 году.В 1989 году Янн Лекун и его коллеги применили обратное распространение к такой архитектуре. В начале 2000-х годов в промышленной заявке CNNs уже обрабатывалось от 10% до 20% всех чеков, написанных в США. С 2011 года быстрая реализация CNNs на графических процессорах выиграл много конкурсов визуального распознавания образов.

CNNs с 12 сверточными слоями использовались в сочетании с обучением подкрепления Deepmind "AlphaGo Lee", программой, которая победила чемпиона top Go в 2016 году.

Глубокие рекуррентные нейронные сети[править]

Основная статья: рекуррентные нейронные сети

Ранее глубокое обучение также применялось к обучению последовательности с рекуррентными нейронными сетями (RNNs) , которые теоретически завершены Тьюрингом и могут запускать произвольные программы для обработки произвольных последовательностей входов. Глубина RNN неограниченна и зависит от длины его входной последовательности; таким образом, RNN является примером глубокого обучения. RNN могут быть обучены градиентным спуском, но страдают от проблемы исчезающего градиента . в 1992 году было показано, что неконтролируемое предварительное обучение стека рекуррентных нейронных сетей может ускорить последующее контролируемое изучение глубоких последовательных проблем.

Многочисленные исследователи в настоящее время используют варианты рекуррентного NN глубокого обучения, называемого сетью long short-term memory (LSTM), опубликованной Hochreiter & Schmidhuber в 1997 году. LSTM часто обучается Коннекционистской временной классификацией (CTC).в Google, Microsoft и Baidu этот подход произвел революцию в распознавании речи . например, в 2015 году в Google по распознаванию речи произошел резкий скачок производительности на 49% благодаря обученному CTC LSTM, который теперь доступен через Google Voice миллиардам пользователей смартфонов. Google также использовал LSTM для улучшения машинного перевода, языкового моделирования и обработки многоязычного языка. LSTM в сочетании с CNNs также улучшили автоматическое субтитрирование изображений и множество других приложений.

Оценка прогресса[править]

Дополнительная информация: Прогресс в области искусственного интеллекта и Конкурсы и призы в области искусственного интеллекта

ИИ, как электричество или паровой двигатель, является технологией общего назначения. Нет единого мнения о том, как охарактеризовать, в каких задачах ИИ стремится преуспеть. в то время как проекты, такие как AlphaZero, преуспели в создании собственных знаний с нуля, многие другие проекты машинного обучения требуют больших наборов учебных данных. исследователь Эндрю Нг предположил, как "очень несовершенное эмпирическое правило", что "почти все, что типичный человек может сделать с менее чем одной секундой умственной мысли, мы, вероятно, можем сейчас или в ближайшем будущем автоматизировать использование ИИ."Парадокс Моравека предполагает, что ИИ отстает от людей во многих задачах, которые человеческий мозг специально развил, чтобы хорошо выполнять.

Игры обеспечивают хорошо разрекламированный ориентир для оценки темпов прогресса. AlphaGo около 2016 года завершила эру классических тестов настольных игр. Игры с несовершенным знанием создают новые проблемы для ИИ в области теории игр . киберспорт, такой как StarCraft, продолжает обеспечивать дополнительные публичные ориентиры. существует множество конкурсов и призов, таких как ImageNet Challenge , для продвижения исследований в области искусственного интеллекта. Наиболее распространенные области конкуренции включают общий машинный интеллект, разговорное поведение, интеллектуальный анализ данных, роботизированные автомобили, и робот футбол, а также обычные игры.

"Имитационная игра" (интерпретация теста Тьюринга 1950 года, которая оценивает, может ли компьютер подражать человеку) в настоящее время считается слишком эксплуатируемой, чтобы быть значимым эталоном. производным от теста Тьюринга является полностью автоматизированный публичный тест Тьюринга, чтобы отличать компьютеры и людей (CAPTCHA). Как следует из названия, это помогает определить, что пользователь является реальным человеком, а не компьютером, выдающим себя за человека. В отличие от стандартного теста Тьюринга, капча вводится машиной и нацелена на человека, а не на человека и нацелена на машину. Компьютер просит пользователя выполнить простой тест, а затем создает оценку для этого теста. Компьютеры не в состоянии решить проблему, поэтому правильные решения считаются результатом человека, проходящего тест. Общий тип капчи-это тест, который требует ввода искаженных букв, цифр или символов, которые появляются на изображении, не поддающемся расшифровке компьютером.

Предлагаемые тесты "универсального интеллекта" направлены на сравнение того, насколько хорошо машины, люди и даже нечеловеческие животные выполняют задачи, которые являются общими, насколько это возможно. В крайнем случае, набор тестов может содержать все возможные проблемы, взвешенные сложностью Колмогорова ; к сожалению, в этих наборах проблем, как правило, доминируют обедневшие упражнения по сопоставлению шаблонов, где настроенный ИИ может легко превышать уровни производительности человека.

Символический ИИ и его пределы

- Основные статьи: Символический ИИ, Гипотеза о системах физических символов, Парадокс Моравека, и Взгляды Хьюберта Дрейфуса на искусственный интеллект

Аккуратный против неряшливого[править]

Основная статья: Аккуратность

"Аккуратные" надеются, что разумное поведение описывается с использованием простых, элегантных принципов (таких как логика, оптимизация или нейронные сети). "Неряхи" ожидают, что это обязательно потребует решения большого количества несвязанных проблем (особенно в таких областях, как рассуждения со здравым смыслом). Этот вопрос активно обсуждался в 70-х и 80-х годах, но в 1990-х математические методы и твердые научные стандарты стали нормой, переход, который Рассел и Норвиг назвали "победой аккуратности".

Мягкие вычисления против жестких[править]

Основная статья: Мягкие вычисления

Поиск доказуемо правильного или оптимального решения является неразрешимым для многих важных задач. Мягкие вычисления - это набор методов, включая генетические алгоритмы, нечеткую логику и нейронные сети, которые допускают неточности, неопределенность, частичную истинность и приближение. Мягкие вычисления появились в конце 80-х, и наиболее успешные программы искусственного интеллекта в 21 веке являются примерами мягких вычислений с использованием нейронных сетей.

Узкий ИИ против общего[править]

Основная статья: Искусственный общий интеллект

Мнения исследователей ИИ разделились относительно того, следует ли преследовать цели искусственного общего интеллекта и сверхразума (общий ИИ) напрямую или решать как можно больше конкретных проблем (узкий ИИ) в надежде, что эти решения косвенно приведут к долгосрочным целям отрасли. Общий интеллект трудно определить и трудно измерить, и современный ИИ добился более поддающихся проверке успехов, сосредоточившись на конкретных проблемах с конкретными решениями. Экспериментальная подотрасль искусственного общего интеллекта изучает исключительно эту область.

Приложения[править]

Главная статья: Применения искусственного интеллекта

ИИ имеет отношение к любой интеллектуальной задаче.Современные методы искусственного интеллекта широко распространены и слишком многочисленны, чтобы перечислить их здесь. Часто, когда техника достигает основного использования, она больше не считается искусственным интеллектом; это явление описывается как эффект ИИ .

Громких примеров ИИ включают в себя автономные транспортные средства (такие как дроны и самоуправляемые автомобили), медицинской диагностики, создания искусства (например, поэзии), доказывать математические теоремы, играть в игры (например, шахматы или го), поисковых систем (таких как Google поиск), онлайн помощники (например, Сири), изображение признание в фотографиях, спам, фильтрации, прогнозирования задержки рейсов, прогнозирование судебных решений и таргетинга онлайн-рекламы.

Поскольку сайты социальных сетей обгоняют телевидение в качестве источника новостей для молодежи и новостных организаций, все больше полагающихся на платформы социальных сетей для генерации распространения, крупные издатели теперь используют технологию искусственного интеллекта (AI) для более эффективного размещения историй и создания более высоких объемов трафика.

Здравоохранение[править]

Главная статья: Искусственный интеллект в здравоохранении

ИИ применяется к проблеме высокой стоимости вопросов дозировки - где результаты показали,что ИИ может сэкономить $ 16 млрд. В 2016 году новаторское исследование в Калифорнии показало, что математическая формула, разработанная с помощью ИИ, правильно определила точную дозу иммунодепрессантов для пациентов органов. Рентген руки, с автоматическим расчетом костного возраста с помощью компьютерной программы

Искусственный интеллект врывается в отрасль здравоохранения, помогая врачам. Согласно технологии Bloomberg, Microsoft разработала ИИ, чтобы помочь врачам найти правильное лечение рака. Существует большое количество исследований и препаратов, разработанных в отношении рака. В частности, существует более 800 лекарств и вакцин для лечения рака. Это негативно влияет на врачей, потому что есть слишком много вариантов на выбор, что затрудняет выбор правильных препаратов для пациентов. Microsoft работает над проектом по разработке машины под названием "Ганновер". Его цель состоит в том, чтобы запомнить все документы, необходимые для Рака и помочь предсказать, какие комбинации препаратов будут наиболее эффективными для каждого пациента. Один из проектов, над которым сейчас ведется работа, - это борьба миелоидный лейкоз, смертельный рак, где лечение не улучшилось в течение десятилетий. Другое исследование показало, что искусственный интеллект так же хорош, как и квалифицированные врачи в выявлении рака кожи.Другое исследование использует искусственный интеллект, чтобы попытаться контролировать многократных пациентов высокого риска, и это сделано, задавая каждому пациенту многочисленные вопросы, основанные на данных, полученных от живого доктора к взаимодействиям пациента. Одно изучение было сделано с изучением перехода, машина выполнило диагноз подобно к вышколенному офтальмологу, и смогло произвести решение не познее 30 секунд на Должен ли или не пациент быть направлен для обработки, с точностью больше чем 95%.

По данным CNN , недавнее исследование хирургов в детском Национальном медицинском центре в Вашингтоне успешно продемонстрировало операцию с автономным роботом. Команда контролировала робота пока она выполнила хирургию мягк-ткани, сшивая совместно кишечник свиньи во время открытой хирургии, и делая так более лучше чем людской хирург, команда требовала. IBM создала свой собственный компьютер искусственного интеллекта, IBM Watson , который избил человеческий интеллект (на некоторых уровнях). Ватсон не только выиграл на игровом шоу Jeopardy! против бывших чемпионов, но был объявлен героем после успешной диагностики женщины, которая страдала лейкемией.

Автомобильный[править]

Главная статья: Автомобили без водителя

Достижения в области ИИ способствовали росту автомобильной промышленности за счет создания и эволюции самоходных транспортных средств. По состоянию на 2016 , есть более 30 компаний, использующих ИИ в создании беспилотных автомобилей . Несколько компаний, связанных с ИИ включают Тесла, Google и Apple .

Многие компоненты способствуют функционированию самоходных автомобилей. Эти транспортные средства включают такие системы, как торможение, изменение полосы движения, предотвращение столкновений, навигация и картографирование. Вместе эти системы, а также высокопроизводительные компьютеры интегрированы в одно сложное транспортное средство.

Последние разработки в области автономных автомобилей сделали возможной инновацию самоходных грузовиков, хотя они все еще находятся на стадии тестирования. Правительство Великобритании приняло законодательство, чтобы начать тестирование самоходных грузовых взводов в 2018 году. самоходные грузовые взводы-это парк самоходных грузовиков, следующих за одним несамоходным грузовиком, поэтому грузовые взводы еще не полностью автономны. Тем временем немецкая автомобильная корпорация Daimler тестирует Freightliner Inspiration-полуавтономный грузовик, который будет использоваться только на шоссе.

Одним из основных факторов, влияющих на способность автомобиля без водителя функционировать, является отображение. В целом, транспортное средство будет предварительно запрограммировано с картой местности, в которой будет осуществляться движение. Эта карта будет включать в себя данные о приближении уличного света и высоты бордюра для того, чтобы транспортное средство было в курсе его окружения. Тем не менее, Google работает над алгоритмом с целью устранения необходимости в предварительно запрограммированных картах и вместо этого создает устройство, которое сможет адаптироваться к различным новым условиям. Некоторые самоходные автомобили не оборудованы рулевыми колесами или тормозными педалями, поэтому также были проведены исследования, направленные на создание алгоритма, который способен поддерживать безопасную среду для пассажиров в транспортном средстве благодаря осознанию скорости и условий вождения.

Другим фактором, влияющим на способность автомобиля без водителя, является безопасность пассажира. Чтобы сделать автомобиль без водителя, инженеры должны запрограммировать его для обработки ситуаций высокого риска. Эти ситуации могут включать лобовое столкновение с пешеходами. Главной целью автомобиля должно быть принятие решения, которое позволит избежать столкновения с пешеходами и спасти пассажиров в автомобиле. Но есть вероятность, что автомобиль должен будет принять решение, которое поставит кого-то в опасность. Другими словами, автомобиль должен решить спасти пешеходов или пассажиров. Программирование автомобиля в этих ситуациях имеет решающее значение для успешного автомобиля без водителя.

Умные светофоры[править]

Умные светофоры разрабатываются в Карнеги-Меллоне с 2009 года. С тех пор профессор Стивен Смит основал компанию Surtrac, которая установила интеллектуальные системы управления дорожным движением в 22 городах. Его установка стоит около 20 000 долларов за пересечение. Время в пути сократилось на 25%, а время ожидания в пробках сократилось на 40% на перекрестках, где он был установлен.

Финансы и экономика[править]

Финансовые учреждения уже давно используют системы искусственных нейронных сетей для выявления обвинений или претензий, выходящих за рамки нормы, и для проведения расследований на людях. Использование ИИ в банковской деятельности можно проследить до 1987 года, когда Security Pacific National Bank в США создал целевую группу по предотвращению мошенничества для противодействия несанкционированному использованию дебетовых карт. Такие программы, как Kasisto и Moneystream используют ИИ в финансовых услугах.

Сегодня банки используют системы искусственного интеллекта для организации операций, ведения бухгалтерского учета, инвестирования в акции и управления имуществом. ИИ может реагировать на изменения в одночасье или когда бизнес не происходит. в августе 2001 года роботы победили людей в симулированном финансовом торговом соревновании. Ма также сократила масштабы мошенничества и финансовых преступлений путем мониторинга моделей поведения пользователей на предмет любых аномальных изменений или аномалий.

Использование машин ИИ на рынке в таких приложениях, как онлайн-торговля и принятие решений, изменило основные экономические теории. например, платформы купли-продажи, основанные на ИИ, изменили закон спроса и предложения в том смысле, что теперь можно легко оценить индивидуальные кривые спроса и предложения и, таким образом, индивидуальное ценообразование. Кроме того, машины AI уменьшают асимметрию информации на рынке и таким образом делать рынки более эффективным пока уменьшающ том торгов. Кроме того, ИИ на рынках ограничивает последствия поведения на рынках, что снова делает рынки более эффективными. Другие теории , в которых ИИ оказал влияние , включают рациональный выбор , рациональные ожидания , теорию игр, поворотный момент Льюиса, оптимизацию портфеля и контрфактическое мышление .

Правительство[править]

Главная статья: Искусственный интеллект в правительстве

Видеоигры[править]

Главная статья: Искусственный интеллект (видеоигры)

В видеоиграх искусственный интеллект обычно используется для создания динамического целенаправленного поведения в персонажах, не являющихся игроками (NPC). Кроме того, хорошо изученные методы ИИ обычно используются для поиска пути . Некоторые исследователи считают NPC AI в играх "решенной проблемой" для большинства производственных задач. Игры с более нетипичным ИИ включают в себя директора ИИ Left 4 Dead (2008) и нейроэволюционную подготовку взводов в Supreme Commander 2 (2010).

Военные[править]

Дополнительная информация: гонка вооружений искусственного интеллекта, летальное автономное оружие и беспилотный боевой летательный аппарат

Во всем мире ежегодные военные расходы на робототехнику выросли с$5,1 млрд в 2010 году до$7,5 млрд в 2015 году. военные беспилотники, способные к автономным действиям, широко считаются полезным активом. многие исследователи искусственного интеллекта стремятся дистанцироваться от военного применения ИИ.

Аудит[править]

Для аудита финансовой отчетности AI делает возможным непрерывный аудит. Инструменты AI могут анализировать множество наборов различной информации сразу. Потенциальная выгода будет заключаться в снижении общего аудиторского риска, повышении уровня уверенности и сокращении сроков проведения аудита.

Реклама[править]

Можно использовать AI для прогнозирования или обобщения поведения клиентов по их цифровым следам, чтобы нацелить их на персонализированные рекламные акции или автоматически создавать личности клиентов. документально подтвержденный случай сообщает, что азартные онлайн-компании использовали ИИ для улучшения таргетинга клиентов.

Кроме того, применение моделей личностных вычислений ИИ может помочь снизить стоимость рекламных кампаний, добавив психологический таргетинг к более традиционному социально-демографическому или поведенческому таргетингу.

Искусство[править]

Дополнительная информация: Computer art