Нейросети

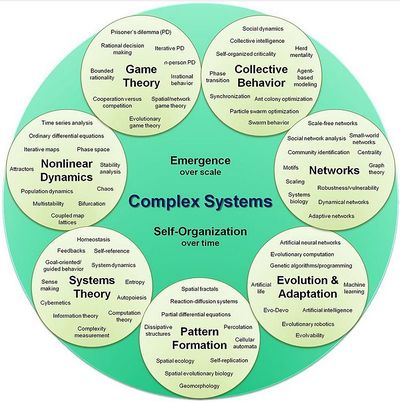

Искусственные нейронные сети (ANN ) или коннекционистские системы-это вычислительные системы, смутно вдохновленные биологическими нейронными сетями, которые составляют мозг животных . Такие системы "учатся" выполнять задачи, рассматривая примеры, как правило, без программирования с конкретными правилами задачи. Например, в распознавании изображений они могут научиться распознавать изображения, содержащие кошек, путем анализа примеров изображений, которые были помечены вручную как " кошка "или" нет кошки " и использование результатов для идентификации кошек на других изображениях. Они делают это без каких-либо предварительных знаний о кошках, например, что у них есть шерсть, хвосты, усы и кошачьи лица. Вместо этого они автоматически генерируют идентифицирующие характеристики из примеров, которые они обрабатывают.

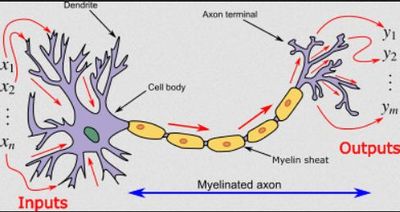

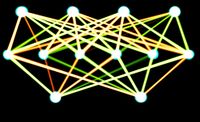

Энн основана на наборе связанных единиц или узлов , называемых искусственными нейронами, которые свободно моделируют нейроны в биологическом мозге. Каждое соединение, подобно синапсам в биологическом мозге, может передавать сигнал другим нейронам. Искусственный нейрон, который получает сигнал, затем обрабатывает его и может сигнализировать нейронам, связанным с ним.

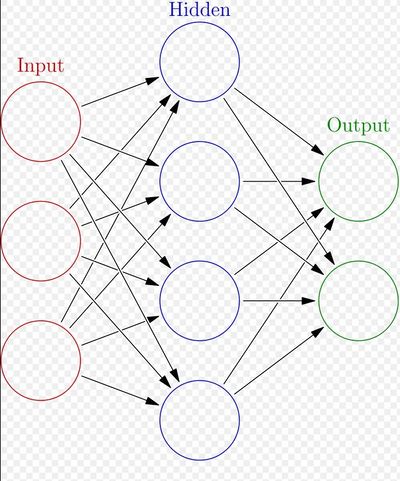

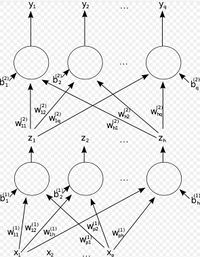

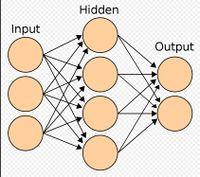

В реализациях ANN "сигнал" при соединении является вещественным числом , а выход каждого нейрона вычисляется некоторой нелинейной функцией от суммы его входов. Эти соединения называются ребрами . Нейроны и ребра обычно имеют вес это корректируется по мере продолжения обучения. Вес увеличивает или уменьшает силу сигнала при соединении. Нейроны могут иметь такой порог, что сигнал передается только в том случае, если совокупный сигнал пересекает этот порог. Как правило, нейроны агрегируются в слои. Различные слои могут выполнять различные преобразования на своих входных данных. Сигналы перемещаются от первого слоя (входного слоя) до последнего слоя (выходного слоя), возможно, после многократного обхода слоев.

Первоначальная цель подхода Энн состояла в том, чтобы решить проблемы таким же образом, как это сделал бы человеческий мозг. Но со временем внимание переключилось на выполнение конкретных заданий, что привело к отклонениям от биологии . ANNs использовались для решения различных задач , включая компьютерное зрение , распознавание речи , машинный перевод, фильтрацию социальных сетей , игру в настольные и видеоигры , медицинскую диагностику и даже в таких видах деятельности, которые традиционно считались зарезервированными для людей, как живопись

История[править]

Основная статья: История развития искусственных нейронных сетей

Уоррен Маккалох и Уолтер Питтс (1943) открыли эту тему, создав вычислительную модель для нейронных сетей. В конце 1940-х годов Д. О. Хебб создал учебную гипотезу, основанную на механизме нейропластичности, которая стала известна как геббианское обучение . Фарли и Уэсли А. Кларк (1954) впервые использовали вычислительные машины, тогда называемые "калькуляторами", для моделирования сети Хебба. Розенблатт (1958) создал персептрон . первые функциональные сети со многими слоями были опубликованы Ивахненко и Лапа в 1965 году, как групповой метод обработки данных . Основы непрерывного обратного распространения болезни были получены в контексте теории управления Келли [15] в 1960 году и Брайсоном в 1961 году, с использованием принципов динамического программирования .

В 1970 году Сеппо Линнайнмаа опубликовал общий метод автоматического дифференцирования (AD) дискретных связанных сетей вложенных дифференцируемых функций. В 1973 году Дрейфус использовал обратное разложение для адаптации параметров контроллеров пропорционально градиентам ошибок. werbos 's (1975) backpropagation алгоритм позволил практическую подготовку многослойных сетей. В 1982 году он применил метод объявления Linnainmaa к нейронным сетям так, как это стало широко использоваться. после этого исследования застопорились вслед за Minsky и Papert (1969), кто обнаружил, что основные персептроны не способны обрабатывать схему исключающего ИЛИ и что компьютеры не обладают достаточной мощностью для обработки полезных нейронных сетей.

Увеличение количества транзисторов в цифровой электронике обеспечило большую вычислительную мощность, что позволило разработать практические искусственные нейронные сети в 1980-х годах.

В 1992 году было введено максимальное объединение, чтобы помочь с инвариантностью наименьшего сдвига и допуском к деформации, чтобы помочь распознаванию 3D-объектов . Шмидгубер принял многоуровневую иерархию сетей (1992), предварительно обученных один уровень за один раз путем бесконтрольного обучения и тонкой настройки путем обратного распространения .

Джеффри Хинтон и др. (2006) предложил изучать высокоуровневое представление, используя последовательные слои двоичных или вещественнозначных латентных переменных с ограниченной машиной Больцмана для моделирования каждого слоя. В 2012 году НГ и Дин создали сеть, которая научилась распознавать понятия более высокого уровня, такие как кошки, только наблюдая немаркированные изображения. бесконтрольное предварительное обучение и увеличение вычислительной мощности от графических процессоров и распределенных вычислений позволили использовать более крупные сети, особенно в задачах распознавания изображений и визуальных образов, которые стали известны как " глубокое обучение ".

Ciresan и коллеги (2010) показали, что, несмотря на исчезающую проблему градиента, графические процессоры делают обратное вычисление возможным для многослойных нейронных сетей с прямой связью. между 2009 и 2012 годами ANNs начали выигрывать призы в конкурсах ANN, приближаясь к производительности человеческого уровня по различным задачам, первоначально в распознавании образов и машинном обучении . например, двунаправленная и многомерная долговременная краткосрочная память (LSTM) о могилах et al. выиграл три конкурса в области распознавания связанного почерка в 2009 году без каких-либо предварительных знаний о трех языках, которые будут изучены.

Ciresan и коллеги построили первые распознаватели паттернов для достижения человеческой конкурентоспособности / сверхчеловеческой производительности на таких критериях, как распознавание дорожных знаков (IJCNN 2012).

Модели[править]

Дополнительная информация: Математика искусственных нейронных сетей

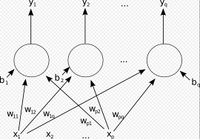

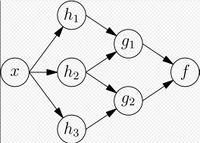

Эннс начиналась как попытка использовать архитектуру человеческого мозга для выполнения задач, с которыми обычные алгоритмы имели мало успеха. Вскоре они переориентировались на улучшение эмпирических результатов, в основном отказавшись от попыток оставаться верными своим биологическим предшественникам. Нейроны соединены друг с другом в различных паттернах, чтобы позволить выходу одних нейронов стать входом других. Сеть образует направленный, взвешенный график .

Искусственная нейронная сеть состоит из набора смоделированных нейронов. Каждый нейрон-это узел, который соединен с другими узлами посредством связей, соответствующих биологическим связям Аксон-синапс-дендрит. Каждое звено имеет свой вес, который определяет силу влияния одного узла на другой.

Компоненты ANNs[править]

Нейроны[править]

Анн состоят из искусственных нейронов, которые сохраняют биологическую концепцию нейронов, которые получают вход, объединяют вход с их внутренним состоянием (активацией ) и дополнительным порогом с помощью функции активации и производят выход с помощью функции выхода. Исходными входными данными являются внешние данные, такие как изображения и документы. Конечные выходные данные выполняют эту задачу, например, Распознавание объекта в изображении. Важной характеристикой функции активации является то, что она обеспечивает плавный, дифференцируемый переход при изменении входных значений, т. е. небольшое изменение на входе приводит к небольшому изменению на выходе.

Соединения и веса[править]

Сеть состоит из соединений, каждое из которых обеспечивает выход одного нейрона в качестве входного сигнала для другого нейрона. Каждому соединению присваивается вес, который представляет его относительную важность. данный нейрон может иметь несколько входных и выходных соединений.

Функция распространения[править]

Функция распространения вычисляет входной сигнал нейрона из выходов его предшественников нейронов и их связей в виде взвешенной суммы. к результату распространения можно добавить термин смещения.

Организация[править]

Нейроны обычно организованы в несколько слоев, особенно при глубоком обучении . Нейроны одного слоя соединяются только с нейронами непосредственно предшествующего и непосредственно следующего слоев. Слой, который получает внешние данные, является входным слоем . Слой, который производит конечный результат, является выходным слоем . Между ними находится ноль или более скрытых слоев . Также используются однослойные и многослойные сети. Между двумя слоями возможны несколько шаблонов соединений. Они могут быть полностью соединены, причем каждый нейрон в одном слое соединяется с каждым нейроном в следующем слое. Они могут быть объединение, когда группа нейронов в одном слое соединяется с одним нейроном в следующем слое, тем самым уменьшая количество нейронов в этом слое. нейроны, имеющие только такие связи, образуют направленный ациклический граф и известны как прямые сети . в качестве альтернативы, сети, которые позволяют соединения между нейронами в том же или предыдущих слоях известны как рекуррентные сети .

Гиперпараметр[править]

Основная статья: Гиперпараметр (машинное обучение)

Гиперпараметр-это постоянный параметр, значение которого задается до начала процесса обучения. Значения параметров выводятся посредством обучения. Примеры гиперпараметров включают скорость обучения, количество скрытых слоев и размер пакета. значения некоторых гиперпараметров могут зависеть от значений других гиперпараметров. Например, размер некоторых слоев может зависеть от общего количества слоев.

Обучение[править]

Смотрите также: Математическая оптимизация, Теория оценок и машинное обучение

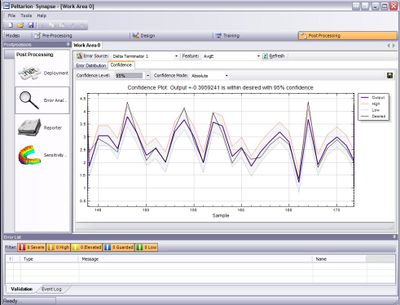

Обучение-это адаптация сети для более эффективного решения задачи путем рассмотрения выборочных наблюдений. Обучение включает в себя корректировку Весов (и необязательных пороговых значений) сети для повышения точности результата. Это делается путем минимизации наблюдаемых ошибок. Обучение завершено, когда изучение дополнительных наблюдений не позволяет с пользой снизить частоту ошибок. Даже после обучения частота ошибок обычно не достигает 0. Если после обучения частота ошибок слишком высока, сеть обычно должна быть переработана. Практически это делается путем определения функции затрат это периодически оценивается во время обучения. Пока его производительность продолжает снижаться, обучение продолжается. Стоимость часто определяется как статистическая величина, значение которой может быть только приблизительно определено. Выходы на самом деле являются числами, поэтому, когда ошибка мала, разница между выходом (почти наверняка кошкой) и правильным ответом (кошкой) невелика. Обучение пытается уменьшить общее количество различий между наблюдениями. большинство моделей обучения можно рассматривать как простое применение теории оптимизации и статистической оценки .

Скорость обучения[править]

Скорость обучения определяет размер корректирующих шагов, которые модель выполняет для корректировки ошибок в каждом наблюдении. Высокая скорость обучения сокращает время обучения, но с более низкой конечной точностью, в то время как более низкая скорость обучения занимает больше времени, но с потенциалом для большей точности. Такие оптимизации, как Quickprop, в первую очередь направлены на ускорение минимизации ошибок, в то время как другие улучшения в основном направлены на повышение надежности. Чтобы избежать колебаний внутри сети, таких как чередующиеся веса соединений, и улучшить скорость сходимости, уточнения используют адаптивная скорость обучения, которая увеличивается или уменьшается по мере необходимости. концепция импульса позволяет взвешивать баланс между градиентом и предыдущим изменением таким образом, что корректировка веса в некоторой степени зависит от предыдущего изменения. Импульс, близкий к 0, подчеркивает градиент, а значение, близкое к 1, подчеркивает последнее изменение.

Функция затрат[править]

Хотя можно определить функцию затрат ad hoc, часто выбор определяется желательными свойствами функций (такими как выпуклость ) или потому, что он возникает из модели (например, в вероятностной модели апостериорная вероятность модели может использоваться в качестве обратной стоимости).

Backpropagation[править]

Главная статья: Backpropagation

Backpropagation-это метод настройки весов соединений для компенсации каждой ошибки, обнаруженной во время обучения. Количество ошибок эффективно распределяется между соединениями. Технически backprop вычисляет градиент (производную) функции затрат, связанной с заданным состоянием по отношению к весам. Обновление веса может быть выполнено с помощью стохастического градиентного спуска или других методов, таких как экстремальные обучающие машины , "безопорные" сети, обучение без обратного хода, "невесомые" сети, и неконнекционистские нейронные сети .

Парадигмы обучения[править]

Тремя основными парадигмами обучения являются контролируемое обучение, бесконтрольное обучение и подкрепляющее обучение . Каждый из них соответствует определенной учебной задаче

Контролируемое обучение[править]

Контролируемое обучение использует набор парных входов и желаемых выходов. Задача обучения состоит в том, чтобы получить желаемый результат для каждого входа. В этом случае функция затрат связана с устранением неверных вычетов.[53] обычно используемая стоимость-это среднеквадратичная ошибка , которая пытается свести к минимуму среднюю квадратическую ошибку между выходом сети и требуемым выходом. Задачи, пригодные для контролируемого обучения, - это распознавание образов (также известное как классификация) и регрессия (также известный как аппроксимация функции). Контролируемое обучение также применимо к последовательным данным (например, для ручного письма, распознавания речи и жестов ). Это можно рассматривать как обучение с "учителем", в виде функции, которая обеспечивает непрерывную обратную связь о качестве решений, полученных до сих пор.

Бесконтрольное обучение[править]

В бесконтрольном обучении входные данные приводятся вместе с функцией затрат, некоторой функцией данных x xи выходом сети. Функция затрат зависит от задачи (предметной области модели) и любых априорных предположений (неявных свойств модели, ее параметров и наблюдаемых переменных). В качестве тривиального примера рассмотрим модель f ( x ) = a a, где a aнаходится константа и стоимость C = E [ ( x − f ( x ) ) 2 ] . Минимизация этой стоимости приводит к получению значения a textstyle a, равного среднему значению данных. Функция затрат может быть гораздо сложнее. Его форма зависит от приложения: например, при сжатии это может быть связано с взаимной информацией между x , в то время как в статистическом моделировании это может быть связано с апостериорной вероятностью модели, заданной данными (обратите внимание, что в обоих этих примерах эти величины будут максимизированы, а не минимизированы). Задачи, которые подпадают под парадигму неконтролируемого обучения, относятся к общим задачам оценки; приложения включают кластеризацию , оценку статистических распределений , сжатие и фильтрацию .

Обучение с подкреплением[править]

Основная статья: Усиление обучения Смотрите также: Управление Стохастикой

В таких приложениях, как видеоигры, актер выполняет ряд действий, получая в целом непредсказуемый ответ от окружающей среды после каждого из них. Цель состоит в том, чтобы выиграть игру, т. е. генерировать наиболее положительные (самые низкие затраты) ответы. В подкрепление обучения, цель состоит в том, чтобы взвесить сеть (разработать политику) для выполнения действий, которые минимизируют долгосрочные (ожидаемые совокупные) затраты. В каждый момент времени агент выполняет действие, а окружающая среда генерирует наблюдение и мгновенную стоимость, в соответствии с некоторыми (обычно неизвестными) правилами. Правила и долгосрочная стоимость обычно могут быть оценены только. В любой момент агент решает, следует ли изучить новые действия, чтобы выявить их затраты, или использовать предварительное обучение, чтобы действовать более быстро.

Формально среда моделируется как Марковский процесс принятия решений (MDP) с состояниями s 1 ,

. . . , s n ∈ S

\in Sи действиями a 1 , . . . , a m ∈ A. Поскольку переходы состояний неизвестны, вместо них используются распределения вероятностей: распределение мгновенных затрат , распределение P ( c t | s t ) наблюдений P ( x t | s t ) )и распределение переходов P ( s t + 1 | s t , a t ) , а политика определяется как условное распределение по действиям, заданным наблюдениями. Взятые вместе, они определяют цепь Маркова (MC). Цель состоит в том, чтобы обнаружить самый дешевый MC.

ANNs служат в качестве учебного компонента в таких приложениях. динамического программирования в сочетании с искусственными нейронными сетями (давая нейродинамического программирования) была применена к таким проблемам, как участие в маршрутизации транспорта, видеоигры, рациональному использованию природных ресурсов и медицины из-за Инс возможность уменьшить потери точности даже при уменьшении дискретизации сетки плотность численно аппроксимировать решение проблем управления. Задачами, входящими в парадигму подкрепляющего обучения, являются задачи управления, игры и другие последовательные задачи принятия решений.

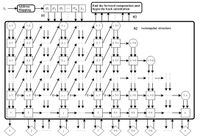

Самообучение[править]

Самообучение в нейронных сетях было введено в 1982 году вместе с нейронной сетью, способной к самообучению, названной Crossbar Adaptive Array (CAA).[61] это система, имеющая только один вход, ситуацию s и только один выход, действие (или поведение) a. она не имеет ни внешнего входа рекомендаций, ни внешнего входа подкрепления из окружающей среды. CAA вычисляет, в виде перекладины, как решения о действиях, так и эмоции (чувства) о возникающих ситуациях. Система управляется взаимодействием между познанием и эмоцией.[62] Заданная матрица памяти W = / / w(a, s)|/, алгоритм самообучения поперечины на каждой итерации выполняет следующие вычисления:

- В ситуации s выполните действие a;

- Получить последствия ситуации s’;

- Вычислите эмоцию нахождения в ситуации следствия v(s’);

- Обновить память поперечины w’(a,s) = w(a,s) + v (s’).

Обратное значение (вторичное подкрепление) - это эмоция по отношению к ситуации следствия. CAA существует в двух средах, одна из которых является поведенческой средой, в которой он ведет себя, а другая-генетическая среда, в которой он изначально и только один раз получает первоначальные эмоции, с которыми он столкнется в поведенческой среде. Получив геномный вектор (видовой вектор) из генетической среды, САА будет обучаться целенаправленному поведению, в поведенческой среде, содержащей как желательные, так и нежелательные ситуации.

Другое[править]

В рамках Байеса распределение по набору разрешенных моделей выбирается таким образом, чтобы минимизировать затраты. Эволюционные методы , Программирование экспрессии генов , [65] имитационный отжиг, максимизация ожиданий, непараметрические методы и оптимизация роя частиц являются другими алгоритмами обучения. Конвергентная Рекурсия-это алгоритм обучения для нейронных сетей церебеллярного модельного контроллера артикуляции (CMAC).

Режимы[править]

Доступны два режима обучения: стохастический и пакетный. В стохастическом обучении каждый вход создает корректировку веса. В пакетном обучении веса корректируются на основе пакета входных данных, накапливая ошибки над партией. Стохастическое обучение вводит " шум " в процесс, используя локальный градиент, вычисленный из одной точки данных; это уменьшает вероятность застревания сети в локальных минимумах. Однако пакетное обучение обычно дает более быстрый и стабильный спуск до локального минимума, поскольку каждое обновление выполняется в направлении Средней ошибки пакета. Общим компромиссом является использование "мини-партий", небольших партий с образцами в каждой партии, выбранных стохастически из всего набора данных.

Типы[править]

Основная статья: Типы искусственных нейронных сетей

ANNs эволюционировали в обширную семью методов которые выдвигали современное состояние через множественные Домены. Простейшие типы имеют один или несколько статических компонентов, включая количество единиц измерения, количество слоев, веса единиц измерения и топологию. Динамические типы позволяют одному или нескольким из них развиваться посредством обучения. Последние гораздо сложнее, но могут сократить сроки обучения и дать лучшие результаты. Некоторые типы позволяют / требуют обучения под" надзором " оператора, в то время как другие работают независимо. Некоторые типы работают исключительно в аппаратном обеспечении, в то время как другие являются чисто программным обеспечением и работают на компьютерах общего назначения.

Некоторые из основных достижений относятся: сверточная нейронная сеть, что очень хорошо зарекомендовала себя в обработке визуальной и других двумерных данных; долго кратковременной памяти во избежание схода градиентных проблемы и может обрабатывать сигналы смесь низко-и высокочастотных компонентов пособничество большого словаря распознавания речи,[73][74] преобразование текста в речь синтеза, и фото-реальные говорящие головы;[77] низким сетях, таких как генеративных состязательности сетей в которые несколько сетей (различной структуры) конкурируют друг с другом, например, в таких задачах, как победа в игре [78] или обман противника относительно подлинности входных данных.

Проектирование сети[править]

Основная статья: Поиск нейронной архитектуры

Нейронная архитектура поиска (NAS) использует машинное обучение для автоматизации проектирования ANN. Различные подходы к NAS разработали сети, которые хорошо сравниваются с системами ручной разработки. Основной алгоритм поиска состоит в том, чтобы предложить модель-кандидат, оценить ее по набору данных и использовать результаты в качестве обратной связи для обучения сети NAS. доступные системы включают AutoML и AutoKeras.

Вопросы проектирования включают в себя определение количества, типа и связности сетевых слоев, а также размера каждого и типа соединения (full, pooling, ...).

Гиперпараметры также должны быть определены как часть конструкции (они не изучаются), регулируя такие вопросы, как количество нейронов в каждом слое, скорость обучения, шаг, шаг, глубина, рецептивное поле и заполнение (для CNNs) и т. д.

Использовать[править]

Использование искусственных нейронных сетей требует понимания их характеристик.

- Выбор модели: это зависит от представления данных и приложения. Чрезмерно сложные модели замедляют процесс обучения.

- Алгоритм обучения: Существует множество компромиссов между алгоритмами обучения. Практически любой алгоритм будет хорошо работать с правильными гиперпараметрами для обучения на конкретном наборе данных. Однако выбор и настройка алгоритма обучения на невидимых данных требует значительных экспериментов.

- Надежность: если модель, функция затрат и алгоритм обучения выбраны соответствующим образом, результирующая ANN может стать надежной.

Возможности ANN подпадают под следующие широкие категории: [требуется цитирование]

- Аппроксимация функций или регрессионный анализ, включая прогнозирование временных рядов, аппроксимацию пригодности и моделирование.

- Классификация, включая распознавание паттернов и последовательностей, обнаружение новизны и последовательное принятие решений.

- Обработка данных, включая фильтрацию, кластеризацию, разделение слепых источников и сжатие.

- Робототехника, в том числе направляющие манипуляторы и протезы.

- Управление, включая компьютерное числовое управление .

Приложения[править]

Благодаря своей способности воспроизводить и моделировать нелинейные процессы, искусственные нейронные сети нашли применение во многих дисциплинах. Области применения включают системы идентификации и контроля (средства контроля, прогнозирования траектории, процесс управления, Управление природными ресурсами), квантовой химии,[ общие игры, распознавание образов (РЛС, распознавание, классификация сигнала, 3D-реконструкции, распознавание объектов и многое другое), последовательность распознавания (жест, речь, рукописных и печатных текстов), медицинская диагностика, финансы (например, автоматизированные торговые системы), интеллектуальный анализ данных, визуализация , машинный перевод, фильтрация социальных сетей и спам-фильтрация электронной почты. ANNs были использованы для того чтобы диагностировать Раки, включая рак легких, рак простаты [90] , колоректальный рак [91] и различить сильно инвазионные линии клетки рака от более менее инвазионных линий используя только данные по формы клетки.

Анн были использованы для ускорения анализа надежности объектов инфраструктуры, подверженных стихийным бедствиям , а также для прогнозирования состояния фундаментов населенных пунктов. ANNs также использовались для построения моделей черного ящика в области геологии : гидрологии, моделирования океана и прибрежной инженерии, и геоморфологии . Анн были использованы в области кибербезопасности с целью проведения различия между законными действиями и вредоносными действиями. Например, машинное обучение было использовано для классификации вредоносных программ для Android, для идентификации доменов, принадлежащих субъектам угроз, а также для обнаружения URL-адресов, представляющих угрозу безопасности. ведутся исследования систем ANN, предназначенных для тестирования на проникновение, обнаружения бот-сетей, мошенничества с кредитными картами и сетевых вторжений.

ANNs были предложены в качестве инструмента для моделирования свойств многотельных открытых квантовых систем . в исследовании мозга ANNs изучали краткосрочное поведение отдельных нейронов, динамика нейронных схем возникает из взаимодействий между отдельными нейронами и как поведение может возникнуть из абстрактных нейронных модулей, которые представляют собой полные подсистемы. Исследования рассматривали длительную и кратковременную пластичность нейронных систем и их связь с обучением и памятью от отдельного нейрона до системного уровня.

Теоретические свойства[править]

Вычислительная мощность[править]

Многослойный персептрон является универсальным аппроксиматором функций, что доказано универсальной аппроксимационной теоремой . Однако доказательство не является конструктивным в отношении количества требуемых нейронов, топологии сети, Весов и параметров обучения.

Специфическая рекуррентная архитектура с рациональными весами (в отличие от полных точных вещественных числовых Весов) обладает мощностью универсальной машины Тьюринга , использующей конечное число нейронов и стандартные линейные связи. Кроме того, использование иррациональных значений для Весов приводит к созданию машины с супер-Тьюринговой мощностью.

Емкость[править]

Свойство модели "емкость" соответствует ее способности моделировать любую заданную функцию. Это связано с количеством информации, которая может храниться в сети, и с понятием сложности. Общине известны два понятия способности. Информационная емкость и измерение VC. Информационная емкость персептрона интенсивно обсуждается в книге сэра Дэвида Маккея , которая обобщает работу Томаса кавера. емкость сети стандартных нейронов (не свернутых) может быть получена с помощью четырех правил , которые вытекают из понимания нейрона как электрический элемент . Информационная емкость захватывает функции, моделируемые сетью, учитывая любые данные в качестве входных данных. Второе понятие - это измерение VC . VC Dimension использует принципы теории измерений и находит максимальную емкость при наилучших возможных обстоятельствах. Это, заданные входные данные в определенном виде. Как было отмечено в , размерность VC для произвольных входных данных составляет половину информационной емкости персептрона. Измерение VC для произвольных точек иногда называют объемом памяти.

Конвергенция[править]

Модели не могут последовательно сходиться на одном решении, во-первых, потому что могут существовать локальные минимумы, зависящие от функции затрат и модели. Во-вторых, используемый метод оптимизации не может гарантировать сходимость, когда он начинается далеко от любого локального минимума. В-третьих, для достаточно больших данных или параметров некоторые методы становятся непрактичными.

Поведение сходимости некоторых типов архитектур ANN более понятно, чем другие. Когда ширина сети приближается к бесконечности, ANN хорошо описывается ее разложением Тейлора первого порядка на протяжении всего обучения и поэтому наследует поведение сходимости аффинных моделей . другой пример-когда параметры малы, наблюдается, что ANNs часто соответствует целевым функциям от низких до высоких частот. это явление противоположно поведению некоторых хорошо изученных итерационных численных схем, таких как метод Якоби .

Обобщение и статистика[править]

Приложения, целью которых является создание системы, хорошо обобщающей невидимые примеры, сталкиваются с возможностью переобучения. Это возникает в запутанных или перегруженных системах, когда пропускная способность сети значительно превышает необходимые свободные параметры. Два подхода касаются чрезмерного обучения. Первый заключается в использовании перекрестной проверки и аналогичных методов для проверки наличия избыточного обучения и выбора гиперпараметров для минимизации ошибки обобщения.

Во-вторых, использовать некоторую форму регуляризации . Эта концепция возникает в вероятностной (Байесовской) структуре, где регуляризация может быть выполнена путем выбора большей априорной вероятности по сравнению с более простыми моделями; но также и в теории статистического обучения, где цель состоит в минимизации более двух величин: "эмпирического риска" и "структурного риска", который примерно соответствует ошибке над обучающим набором и прогнозируемой ошибке в невидимых данных из-за чрезмерного подгонки.

Контролируемые нейронные сети, использующие функцию среднего квадратического отклонения (MSE) стоимости, могут использовать формальные статистические методы для определения достоверности обученной модели. MSE в наборе проверки можно использовать в качестве оценки дисперсии. Это значение затем можно использовать для вычисления доверительного интервала сетевого выхода, предполагая нормальное распределение . Проведенный таким образом анализ достоверности является статистически достоверным до тех пор, пока выходное распределение вероятностей остается неизменным и сеть не изменяется.

Назначая функцию активации softmax , обобщение логистической функции , на выходной слой нейронной сети (или компонент softmax в компонентной сети) для категориальных целевых переменных, выходы могут быть интерпретированы как апостериорные вероятности. Это полезно при классификации, поскольку дает меру определенности в отношении классификаций.

Функция активации softmax является:

y i = e x i ∑ j = 1 c e x j

Критика[править]

Обучение[править]

Распространенная критика нейронных сетей, особенно в робототехнике, заключается в том, что они требуют слишком большой подготовки для работы в реальном мире.[требуется цитирование ] потенциальные решения включают в себя случайную перетасовку обучающих примеров, используя алгоритм численной оптимизации, который не принимает слишком больших шагов при изменении сетевых соединений после примера, группируя примеры в так называемых мини-пакетах и/или вводя рекурсивный алгоритм наименьших квадратов для CMAC .

Теория[править]

Фундаментальное возражение состоит в том, что Энн недостаточно отражают нейрональную функцию. Обратное проникновение является критическим шагом, хотя в биологических нейронных сетях такого механизма не существует.Каким образом информация кодируется реальными нейронами, неизвестно. Сенсорные нейроны активируют потенциалы действия чаще при активации сенсора, а мышечные клетки вытягиваются сильнее, когда их ассоциированные моторные нейроны получают потенциалы действия чаще. Кроме случая ретрансляции информации от сенсорного нейрона к двигательному нейрону, почти ничего не известно о принципах обработки информации биологическими нейронными сетями.

Главная претензия ANNs заключается в том, что они воплощают новые и мощные общие принципы обработки информации. К сожалению, эти принципы плохо определены. Часто утверждается, что они исходят из самой сети. Это позволяет описывать простую статистическую ассоциацию (основную функцию искусственных нейронных сетей) как обучение или распознавание. Александр Дьюдни он отметил, что в результате искусственные нейронные сети обладают "качеством чего-то за ничто", которое придает особую ауру лени и отчетливое отсутствие любопытства о том, насколько хороши эти вычислительные системы. Ни одна человеческая рука (или ум) не вмешивается; решения находят как по волшебству; и никто, кажется, ничему не научился". один ответ на Dewdney заключается в том, что нейронные сети обрабатывают множество сложных и разнообразных задач, начиная от автономного полета самолета до обнаружения мошенничества с кредитными картами и заканчивая освоением игры Go .

Технологический писатель Роджер Бриджмен прокомментировал::

Нейронные сети, например, находятся на скамье подсудимых не только потому, что они были раскручены до небес, (что не было?) но также и потому, что вы можете создать успешную сеть, не понимая, как она работает: куча чисел, которая фиксирует ее поведение, по всей вероятности, будет "непрозрачной, нечитаемой таблицей...бесполезен как научный ресурс".

Несмотря на его решительное заявление о том, что наука-это не технология, Дьюдни, похоже, здесь позорит нейронные сети как плохую науку, когда большинство из тех, кто их разрабатывает, просто пытаются быть хорошими инженерами. Нечитабельная таблица, которую может прочитать полезная машина, все равно будет стоить того.

Биологический мозг использует как поверхностные, так и глубокие контуры, как сообщается в анатомии мозга [129], проявляя широкий спектр инвариантности. Венг утверждал, что мозг самонастраивается в значительной степени в соответствии со статистикой сигналов и поэтому последовательный каскад не может уловить все основные статистические зависимости.

Оборудование[править]

Большие и эффективные нейронные сети требуют значительных вычислительных ресурсов.В то время как мозг имеет аппаратное обеспечение, адаптированное к задаче обработки сигналов через график нейронов, моделирование даже упрощенного нейрона на архитектуре фон Неймана может потреблять огромные объемы памяти и памяти хранения. Кроме того, проектировщику часто приходится передавать сигналы через многие из этих соединений и связанных с ними нейронов, что требует огромной мощности процессора и времени.

Шмидхубера отметил, что активизация нейронных сетей в XXI веке во многом обусловлены достижениями в оборудование: с 1991 по 2015 годы, вычислительной мощности, особенно выступление графические процессоры GPGPU (по ГП), возросла примерно в миллион раз, делая стандартный алгоритм обратного распространения ошибки, возможно для обучения сети, что несколько уровней глубже, чем раньше.[9] использование ускорителей, таких как Плис и графические процессоры, позволяет сократить время обучения с нескольких месяцев до нескольких дней.

Нейроморфная инженерия непосредственно решает аппаратные трудности, создавая не-фон-Неймановские чипы для непосредственной реализации нейронных сетей в схемотехнике. Другой тип чипа, оптимизированного для обработки нейронных сетей , называется тензорным процессором, или TPU.

Практические контрпримеры[править]

Анализируя то, что было изучено Энн, гораздо проще, чем анализировать то, что было изучено биологической нейронной сетью. Кроме того, исследователи, занимающиеся изучением алгоритмов обучения для нейронных сетей, постепенно раскрывают общие принципы, которые позволяют обучающей машине быть успешной. Например, локальное и нелокальное обучение и мелкая и глубокая архитектура.

Гибридные подходы[править]

Сторонники гибридных моделей (сочетающих нейронные сети и символические подходы), утверждают, что такая смесь может лучше улавливать механизмы человеческого разума.

Галерея[править]

См.также[править]

- Иерархическая временная память

- 20Q

- Адалин

- Адаптивная резонансная теория

- Искусственная жизнь

- Ассоциативная память

- Автокодировщик

- Лучевая робототехника

- Биологическая кибернетика

- Биологически вдохновленные вычисления

- Проект "Голубой Мозг"

- Катастрофические помехи

- Регулятор артикуляции модели мозжечка (CMAC)

- Когнитивная архитектура

- Когнитивная наука

- Сверточная нейронная сеть (CNN)

- Коннекционистская экспертная система

- Коннектомика

- Культивированные нейронные сети

- Глубокое обучение

- Encog

- Нечеткая логика

- Программирование экспрессии генов

- Генетический алгоритм

- Генетическое программирование

- Групповой способ обработки данных

- Привыкание

- Адаптивная Табуляция In Situ

- Концепции машинного обучения

- Модели нейронных вычислений

- Нейроэволюция

- Нейронное кодирование

- Нейронный газ

- Нейронно-машинный перевод

- Нейросетевое программное обеспечение

- Неврология

- Идентификация нелинейных систем

- Оптическая нейронная сеть

- Параллельные Процессы Удовлетворения Ограничений

- Параллельная распределенная обработка

- Радиальная базисная функциональная сеть

- Рекуррентные нейронные сети

- Самоорганизующаяся карта

- Шипастая нейронная сеть

- Систолический массив

- Тензорная продуктовая сеть

- Нейронная сеть с временной задержкой (TDNN)

Библиография[править]

- Бхадешиа Х. К. Д. Х. (1999). "Нейронные сети в материаловедении" (PDF) . ISIJ International. 39 (10): 966–979. doi: 10.2355 / isijinternational.39.966.

- Bishop, Christopher M. (1995). Нейронные сети для распознавания образов . Кларендон Пресс.

- Боргельт, Кристиан (2003). Neuro-Fuzzy-Systeme : von den Grundlagen künstlicher Neuronaler Netze zur Kopplung mit Fuzzy-Systemen. Вивег.

- Кибенко, Г. В. (2006). "Аппроксимация Суперпозициями сигмоидальной функции". In van Schuppen, Jan H. (ed.). Математика управления, сигналов и систем . Springer International. PP. 303-314. PDF

- Dewdney, A. K. (1997). Да, у нас нет нейтронов : открывающий глаза тур через изгибы и повороты плохой науки . Нью-Йорк: Уайли..

- Duda, Richard O.; Hart, Peter Elliot; Stork, David G. (2001). Классификация рисунков (2 изд.). - Уайли.

- Egmont-Petersen, M.; de Ridder, D.; Handels, H. (2002). "Обработка изображений с помощью нейронных сетей-обзор". Распознавание Образов .

- Fahlman, S.; Lebiere, C (1991). "Архитектура каскадно-корреляционного обучения" (PDF) .

созданный для Национального научного фонда, контракта № EET-8716324 и Агентства перспективных исследовательских проектов обороны (DOD), ARPA приказ № 4976 по контракту

- Гурни, Кевин (1997). Введение в нейронные сети . UCL Press.

- Haykin, Simon S. (1999). Нейронные сети: всеобъемлющая основа . Прентис Холл.

- Hertz, J.; Palmer, Richard G.; Krogh, Anders S. (1991). Введение в теорию нейронных вычислений . Эддисон-Уэсли.

- Теория информации, вывод и алгоритмы обучения . Издательство Кембриджского Университета. 25 сентября 2003 года. Бибкод: 2003.книга.....М.

- Kruse, Rudolf; Borgelt, Christian; Klawonn, F.; Moewes, Christian; Steinbrecher, Matthias; Held, Pascal (2013). Вычислительный интеллект: методологическое введение . Прыгун.

- Lawrence, Jeanette (1994). Введение в нейронные сети: проектирование, теория и приложения . Калифорнийское Научное Программное Обеспечение.

- MacKay, David, J. C. (2003). Теория информации, вывод и алгоритмы обучения (PDF). Издательство Кембриджского Университета .

- Masters, Timothy (1994). Обработка сигналов и изображений с помощью нейронных сетей: справочник по языку Си++. Джей Уайли.

- Ripley, Brian D. (2007). Распознавание образов и нейронные сети . Издательство Кембриджского Университета.

- Siegelmann, H.T.; Sontag, Eduardo D. (1994). "Аналоговые вычисления с помощью нейронных сетей". Теоретическая Информатика .

- Smith, Murray (1993). Нейронные сети для статистического моделирования . Ван Ностранд Рейнхольд.

- Вассерман, Филипп Д. (1993). Передовые методы в области нейронных вычислений . Ван Ностранд Рейнхольд.

- Wilson, Halsey (2018). Искусственный интеллект . Издательство "Серый Дом".

- w.phase-trans.msm.cam.ac.uk/abstracts/neural.review.pdf

- /books.google.kz/books?id=4RtVAAAAMAAJ&pg=PA303&redir_esc=y

- //web.cs.iastate.edu/~honavar/fahlman.pdf

- .inference.org.uk/itprnn/book.pdf

- ://books.google.kz/books?id=m12UR8QmLqoC&redir_esc=y