Взрыв интеллекта

Технологическая сингулярность (также, просто, сингулярность) является гипотетическим будущим моментом времени, в котором технологический рост становится неуправляемым и необратимым, приводя к непостижимым изменениям в человеческой цивилизации.[2][3]

Согласно наиболее популярной версии сингулярности гипотеза, называемая разведка взрыва, обновляемая интеллектуального агента (такого как компьютер, работающий под управлением программного обеспечения на основе искусственного общего интеллекта) будет введен "беглых реакции" самосовершенствования циклов, с каждым новым и более умное поколение, появляются все более и более быстрыми темпами, в результате разведки и взрыва в результате мощного сверхразума, который, качественно, намного превосходят все человеческий интеллект.

Первым, кто использовал понятие "сингулярности" в технологическом контексте, был Джон фон Нейман . Станислав Улам сообщает о дискуссии с фон Нейманом, "сосредоточенной на ускоряющемся прогрессе технологий и изменениях в образе жизни человека, что дает видимость приближения к некоторой существенной особенности в истории расы, за которой человеческие дела, как мы их знаем, не могли продолжаться". последующие авторы повторили эту точку зрения.

Модель "интеллектуального взрыва" И. Дж. Гуда предсказывает, что будущий суперинтеллект вызовет сингулярность.

Понятие и термин "сингулярность" были популяризированы Вернором Винджем в его эссе 1993 года "приходящая технологическая сингулярность", в котором он написал, что это будет сигнализировать о конце человеческой эры, поскольку новый суперинтеллект продолжит модернизировать себя и продвинется технологически с непостижимой скоростью. Он написал, что был бы удивлен, если бы это произошло до 2005 или после 2030 года.

Четыре опроса, проведенные в 2012 и 2013 годах, показали, что средняя оценка была 50% вероятность того, что искусственный общий интеллект (AGI) будет разработан к 2040-2050 годам.

В 2010-х годах общественные деятели, такие как Стивен Хокинг и Элон Маск, выразили обеспокоенность тем, что полный искусственный интеллект может привести к вымиранию человека. последствия сингулярности и ее потенциальная польза или вред для человеческой расы активно обсуждаются.

Фон[править]

Хотя технический прогресс ускорялся, он был ограничен базовым интеллектом человеческого мозга, который , по словам Пола Р. Эрлиха, существенно не менялся на протяжении тысячелетий. однако, с увеличением мощности компьютеров и других технологий, в конечном итоге может быть возможно построить машину, которая является более разумной, чем люди.

Если бы сверхчеловеческий интеллект был изобретен - либо через усиление человеческого интеллекта, либо через искусственный интеллект—это принесло бы больше проблем и изобретательских навыков, чем способны нынешние люди. Такой ИИ называют семенным ИИ потому что, если бы ИИ был создан с инженерными возможностями, которые соответствовали или превосходили возможности его создателей-людей, у него был бы потенциал для автономного улучшения собственного программного и аппаратного обеспечения или разработки еще более способной машины. Эта более способная машина смогла после этого пойти дальше конструировать машину более большой возможности. Эти итерации рекурсивного самосовершенствования могут ускориться, потенциально позволяя огромные качественные изменения до любых верхних пределов, налагаемых законами физики или теоретических вычислений. Предполагается, что на протяжении многих итераций такой ИИ намного превосходит когнитивные способности человека .

Интеллектуальный взрыв[править]

Взрыв интеллекта является возможным результатом создания человечеством искусственного общего интеллекта (AGI). AGI был бы способен к рекурсивному самосовершенствованию, что привело бы к быстрому появлению искусственного Сверхразума (ASI), пределы которого неизвестны, вскоре после достижения технологической сингулярности.

В 1965 году И. Джей Гуд предположил, что искусственный общий интеллект может вызвать взрыв интеллекта. Он размышлял о влиянии сверхчеловеческих машин, если они когда-нибудь будут изобретены: хорошо (1965)

- Пусть ультраинтеллектуальная машина будет определена как машина, которая может намного превзойти все интеллектуальные действия любого человека, каким бы умным он ни был. Поскольку конструирование машин является одним из таких видов интеллектуальной деятельности, ультраинтеллектуальная машина могла бы сконструировать еще лучшие машины; тогда, несомненно, произошел бы "интеллектуальный взрыв", и интеллект человека остался бы далеко позади. Таким образом, первая сверхразумная машина-это последнее изобретение, которое когда-либо было необходимо человеку, при условии, что машина достаточно послушна, чтобы сказать нам, как держать ее под контролем.

Сценарий Гуда выглядит следующим образом: по мере того, как компьютеры увеличивают мощность, люди могут построить машину, которая более умна, чем человечество; этот сверхчеловеческий интеллект обладает большими навыками решения проблем и изобретательства, чем способны нынешние люди. Эта сверхразумная машина проектирует еще более способную машину или переписывает свое собственное программное обеспечение, чтобы стать еще более умной; эта (еще более способная) машина затем проектирует машину еще большей мощности и так далее. Эти итерации рекурсивного самосовершенствования ускоряются, позволяя огромные качественные изменения до любых верхних пределов, налагаемых законами физики или теоретических вычислений.

Другие проявления[править]

Появление сверхразума[править]

Дополнительная информация: Superintelligence

Сверхразум, сверхразум или сверхчеловеческий интеллект-это гипотетический агент, обладающий интеллектом, намного превосходящим интеллект самых ярких и одаренных человеческих умов. "Сверхразум" может также относиться к форме или степени интеллекта, которой обладает такой агент. Джон фон Нейман, Вернор Виндж и Рэй Курцвейл определяют концепцию с точки зрения технологического создания суперинтеллекта. Они утверждают, что для современных людей трудно или невозможно предсказать, какой будет жизнь людей в пост-сингулярном мире.

Технологические прогнозисты и исследователи расходятся во мнениях относительно того, когда и когда человеческий интеллект может быть превзойден. Некоторые утверждают, что прогресс в области искусственного интеллекта (ИИ), вероятно, приведет к общим системам рассуждений, которые не имеют когнитивных ограничений человека. Другие считают, что люди будут эволюционировать или непосредственно изменять свою биологию, чтобы достичь радикально большего интеллекта. Ряд сценариев будущих исследований объединяет элементы обеих этих возможностей, предполагая, что люди, вероятно, будут взаимодействовать с компьютерами или загружать свои умы на компьютеры таким образом, это позволяет существенно усилить интеллект.

Не-AI особенность[править]

Некоторые авторы используют" сингулярность " в более широком смысле для обозначения любых радикальных изменений в нашем обществе, вызванных новыми технологиями, такими как молекулярные нанотехнологии , хотя Виндж и другие авторы определенно заявляют, что без суперинтеллекта такие изменения не квалифицировались бы как истинная особенность.

Правдоподобие[править]

Многие видные технологи и ученые оспаривают правдоподобность технологической сингулярности, в том числе Пол Аллен , Джефф Хокинс , Джон Холланд , Джарон Ланье и Гордон Мур , чей закон часто цитируется в поддержку концепции.

Большинство предлагаемых методов создания сверхчеловеческих или трансчеловеческих умов делятся на две категории: усиление интеллекта человеческого мозга и искусственный интеллект. Средства, предполагаемые для увеличения интеллекта, многочисленны и включают биоинженерию , генную инженерию , ноотропные препараты, помощников ИИ, прямые интерфейсы мозг–компьютер и загрузку разума . Существование множественных путей к интеллектуальному взрыву делает сингулярность более вероятной; чтобы сингулярность не произошла, все они должны были бы потерпеть неудачу.

Хэнсон (Hanson, 1998) скептически относится к увеличению человеческого интеллекта, написав, что, как только вы исчерпали "низко висящие плоды" простых методов повышения человеческого интеллекта, дальнейшие улучшения станут все труднее найти. Несмотря на многочисленные предполагаемые средства для усиления человеческого интеллекта, нечеловеческий искусственный интеллект (в частности, семенной ИИ) является наиболее популярным вариантом для организаций [ который?] попытка продвинуть сингулярность.

Произойдет ли взрыв интеллекта, зависит от трех факторов. первый ускоряющий фактор-это новые улучшения интеллекта, ставшие возможными с каждым предыдущим улучшением. Напротив, по мере того, как интеллекты будут становиться все более продвинутыми, дальнейшие достижения будут становиться все более сложными, возможно, преодолевая преимущество увеличенного интеллекта. Каждое улучшение должно быть способно породить, по крайней мере, еще одно улучшение, в среднем, чтобы сингулярность продолжалась. Наконец, законы физики в конечном итоге предотвратят любые дальнейшие улучшения.

Существуют две логически независимые, но взаимоукрепляющие причины улучшения интеллекта: увеличение скорости вычислений и улучшение используемых алгоритмов. первое предсказано законом Мура и улучшениями прогноза в аппаратных средствах, и сравнительно подобно предыдущему технологическому прогрессу. С другой стороны, некоторые исследователи ИИ [ кто?] считают, что программное обеспечение важнее аппаратного обеспечения. [цитата, необходимая]

Обзор электронной почты 2017 авторов с публикациями на конференциях по машинному обучению 2015 NIPS и ICML спросил их о возможности взрыва интеллекта. 12% сказали, что это "вполне вероятно", 17% сказали, что это "вероятно", 21% сказали, что это "о даже", 24% сказали, что это "маловероятно" и 26% сказали, что это "совершенно маловероятно".

Улучшения скорости[править]

Как для человеческого, так и для искусственного интеллекта аппаратные улучшения увеличивают скорость будущих улучшений оборудования. Упрощенный закон Мура предполагает, что если бы первое удвоение скорости заняло 18 месяцев, то второе заняло бы 18 субъективных месяцев; или 9 внешних месяцев, после чего, четыре месяца, два месяца, и так далее к сингулярности скорости. верхний предел скорости может в конечном счете быть достигнут, хотя неясно, насколько высоко это было бы. Хокинс (2008), отвечая на хороший, утверждал, что верхний предел относительно низок;

- Вера в эту идею основана на наивном понимании того, что такое интеллект. В качестве аналогии представьте, что у нас есть компьютер, который может проектировать новые компьютеры (чипы, системы и программное обеспечение) быстрее, чем он сам. Приведет ли такой компьютер к бесконечно быстрым компьютерам или даже компьютерам, которые были быстрее, чем все, что люди могли когда-либо построить? НЕТ. Это может ускорить темпы улучшений на некоторое время, но, в конце концов, есть ограничения на то, насколько большими и быстрыми могут быть компьютеры. Мы окажемся в одном и том же месте; мы просто доберемся туда немного быстрее. Не было бы сингулярности.

- В то время как если бы он был намного выше, чем нынешние человеческие уровни интеллекта, эффекты сингулярности были бы достаточно велики, чтобы быть неотличимыми (для людей) от сингулярности с верхним пределом. Например, если бы скорость мысли могла быть увеличена в миллион раз, субъективный год прошел бы за 30 физических секунд.

Трудно напрямую сравнить аппаратные средства на основе кремния с нейронами . Но Berglas (2008) отмечает, что компьютерное распознавание речи приближается к человеческим способностям, и что эта способность, кажется, требует 0,01% объема мозга. Эта аналогия предполагает, что современное компьютерное оборудование на несколько порядков меньше, чем человеческий мозг.

Экспоненциальный рост[править]

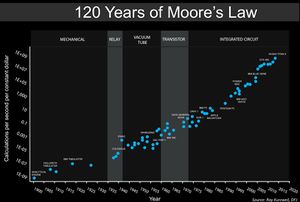

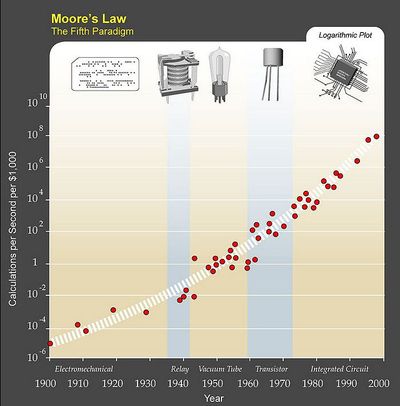

Экспоненциальный рост вычислительной техники, предложенный законом Мура, обычно цитируется как причина ожидать сингулярности в относительно ближайшем будущем, и ряд авторов предложили обобщения закона Мура. Компьютерный ученый и футурист Ханс Моравец предложил в книге 1998 года [32, что экспоненциальная кривая роста могла быть расширена назад через более ранние вычислительные технологии до интегральной схемы .

Рэй Курцвейл постулирует закон ускорения отдачи, при котором скорость технологических изменений (и вообще всех эволюционных процессов ) экспоненциально возрастает, обобщая закон Мура таким же образом, как и предложение Моравека, а также включая материальную технологию (особенно применительно к нанотехнологиям), медицинскую технологию и другие. В период с 1986 по 2007 год возможности машин для вычисления информации на душу населения примерно удваивались каждые 14 месяцев; возможности компьютеров общего назначения в мире на душу населения удваивались каждые 18 месяцев; глобальные возможности электросвязи на душу населения удваивались каждые 34 месяца; и мировые возможности хранения информации на душу населения удваивались каждые 40 месяцев.

Курцвейл оставляет за собой термин " сингулярность "для быстрого увеличения искусственного интеллекта (в отличие от других технологий), написав, например, что" сингулярность позволит нам преодолеть эти ограничения наших биологических тел и мозга ... Не будет никакого различия, пост-сингулярности, между человеком и машиной". Он также определяет свою предсказанную дату сингулярности (2045) с точки зрения того, когда он ожидает, что компьютерные интеллекты значительно превысят общую сумму человеческих умственных способностей, написав, что достижения в вычислениях до этой даты "не будут представлять сингулярность", потому что они "еще не соответствуют глубокому расширению нашего интеллекта."

Ускорение изменений[править]

Главная статья: ускорение изменений

- Некоторые сторонники сингулярности доказывают ее неизбежность путем экстраполяции прошлых тенденций, особенно тех, которые связаны с сокращением разрывов между усовершенствованиями технологии. В одном из первых применений термина "сингулярность" в контексте технического прогресса Станислав Улам рассказывает о разговоре с Джоном фон Нейманом об ускорении изменений:

- Один разговор был сосредоточен на постоянно ускоряющемся прогрессе технологий и изменениях в образе жизни человека, что создает видимость приближения к какой-то существенной особенности в истории расы, за которой человеческие дела, как мы их знаем, не могли продолжаться.

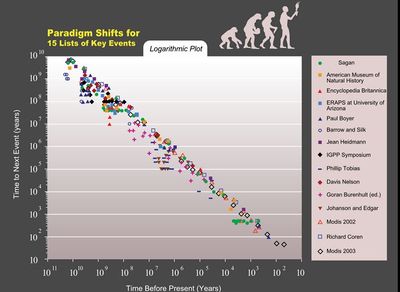

Курцвейл утверждает , что технологический прогресс следует модели экспоненциального роста, следуя тому, что он называет " законом ускорения отдачи ". Всякий раз, когда технология приближается к барьеру, пишет Курцвейл, новые технологии будут преодолевать его. Он предсказывает, что изменения парадигмы будут становиться все более распространенными, приводя к "технологическому изменению, настолько быстрому и глубокому, что представляет собой разрыв в ткани человеческой истории".Курцвейл полагает, что сингулярность наступит приблизительно к 2045 году . Его предсказания отличаются от предсказаний Винджа тем, что он предсказывает постепенное восхождение к сингулярности, а не быстро самосовершенствующийся сверхчеловеческий интеллект Винджа.

Часто упоминаемые опасности включают те, которые обычно связаны с молекулярной нанотехнологией и генной инженерией . Эти угрозы являются основными проблемами как для сторонников сингулярности, так и для критиков, и были предметом статьи журнала Bill Joy's Wired " почему будущее не нуждается в нас ".

Улучшения алгоритма[править]

Некоторые интеллектуальные технологии, такие как" seed AI", также могут иметь потенциал, чтобы сделать себя более эффективными, а не только быстрее, путем изменения их исходного кода . Эти улучшения сделают возможными дальнейшие улучшения, которые сделают возможными дальнейшие улучшения, и так далее.

Механизм рекурсивно самосовершенствующегося набора алгоритмов отличается от увеличения скорости необработанных вычислений двумя способами. Во-первых, оно не требует внешнего влияния: машины конструируя более быстрое оборудование все еще потребовали бы, что люди создали улучшенное оборудование, или запрограммировали фабрики соотвествующе. AI, который переписывал свой собственный исходный код, однако, мог сделать так, в то время как содержался в коробке AI .

Во-вторых, как и в случае с концепцией сингулярности Вернора Винджа, предсказать результат гораздо сложнее. В то время как увеличение скорости, по-видимому, является лишь количественным отличием от человеческого интеллекта, фактические улучшения алгоритма будут качественно иными. Eliezer Yudkowsky сравнивает это с изменениями, которые принес человеческий интеллект: люди изменили мир в тысячи раз быстрее, чем эволюция, и совершенно по-разному. Точно так же эволюция жизни была массовым отклонением и ускорением от предыдущих геологических темпов изменений, и улучшение интеллекта могло привести к тому, что изменения снова станут другими.

Существуют существенные опасности, связанные с особенностью интеллектуального взрыва, возникающей из рекурсивно самосовершенствующегося набора алгоритмов. Во-первых, целевая структура ИИ не может быть инвариантной при самосовершенствовании, потенциально заставляя ИИ оптимизировать что-то другое, чем было предназначено.колво-вторых, ИИ могут конкурировать за скудные ресурсы, используемые человечеством для выживания.

Не будучи активно злонамеренным, нет никаких оснований полагать, что ИИ будут активно продвигать человеческие цели, если они не могут быть запрограммированы как таковые, а если нет, то могут использовать ресурсы, используемые в настоящее время для поддержки человечества, для продвижения своих собственных целей, вызывая вымирание людей.

Карл Шульман и Андерс Сандберг предполагают, что усовершенствования алгоритмов могут быть ограничивающим фактором для сингулярности, потому что в то время как эффективность аппаратных средств имеет тенденцию улучшаться устойчивыми темпами, программные инновации более непредсказуемы и могут быть затруднены последовательными кумулятивными исследованиями. Они предполагают, что в случае ограниченной программным обеспечением сингулярности взрыв интеллекта на самом деле станет более вероятным, чем при ограниченной аппаратным обеспечением сингулярности, потому что в ограниченном программным обеспечением случае, как только ИИ человеческого уровня будет разработан, он может работать последовательно на очень быстром оборудовании, и обилие дешевого оборудования сделает исследования ИИ менее ограниченными.Изобилие накопленного оборудования, которое может быть развязано, как только программное обеспечение выясняет, как использовать его, назвали "вычислительным навесом"."

Критические заметки[править]

Некоторые критики , такие как философ Хьюберт Дрейфус , утверждают, что компьютеры или машины не могут достичь человеческого интеллекта , в то время как другие, такие как физик Стивен Хокинг, считают, что определение интеллекта не имеет значения, если конечный результат тот же.

Психолог Стивен Пинкер заявил в 2008 году:

- ... Нет ни малейших оснований верить в грядущую сингулярность. Тот факт, что вы можете визуализировать будущее в своем воображении, не является доказательством того, что это вероятно или даже возможно. Посмотрите на куполообразные города, реактивные самолеты, подводные города, здания высотой в милю и атомные автомобили-все это было основой футуристических фантазий, когда я был ребенком, который никогда не появлялся. Чистая вычислительная мощность не является пылью пикси, которая волшебным образом решает все ваши проблемы. ...

Калифорнийский университет, Беркли, профессор философии Джон Сирл пишет:

- [Компьютеры] буквально ... ни интеллекта , ни мотивации , ни автономии, ни агентства. Мы планируем , чтобы они вели себя так, как если бы у них были определенные виды психологии, но нет никакой психологической реальности для соответствующих процессов или поведения. ... У машины нет верований, желаний или мотиваций.

Мартин Форд в огнях в туннеле: автоматизация, ускоряющаяся технология и экономика будущего [53] постулирует "технологический парадокс" в том, что прежде чем сингулярность может произойти, большинство рутинных рабочих мест в экономике будут автоматизированы, поскольку для этого потребуется уровень технологии, уступающий уровню сингулярности. Это приведет к массовой безработице и резкому падению потребительского спроса, что, в свою очередь, уничтожит стимул инвестировать в технологии, которые потребуются для создания сингулярности. Перемещение рабочих мест все больше не ограничивается работой, традиционно считающейся "рутинной"."

Теодор Модис и Джонатан Хюбнер утверждают, что темпы технологических инноваций не только перестали расти, но и фактически сейчас снижаются. Свидетельством этого снижения является рост тактовой частоты компьютеров замедляется, даже в то время как предсказание Мура экспоненциально возрастающей плотности цепи продолжает держаться. Это происходит из-за чрезмерного накопления тепла от чипа, которое не может быть рассеяно достаточно быстро, чтобы предотвратить плавление чипа при работе на более высоких скоростях. Продвижение в скорости может быть возможно в будущем благодаря более энергоэффективным конструкциям ЦП и многоячеистым процессорам.[58] В то время как Курцвейл использовал ресурсы Модиса, а работа Модиса была связана с ускорением изменений, Модис дистанцировался от тезиса Курцвейла о "технологической сингулярности", утверждая, что ему не хватает научной строгости.

Другие предполагают , что другие "особенности" могут быть найдены через анализ тенденций в мировом населении , мировом валовом внутреннем продукте и других показателях. Андрей Коротаев и другие утверждают, что исторические гиперболические кривые роста можно отнести к петлям обратной связи, которые перестали влиять на глобальные тенденции в 1970-х годах, и поэтому гиперболического роста не следует ожидать в будущем.

В подробном эмпирическом учете прогресса вычислительной техники Уильям Нордхаус утверждал, что до 1940 года компьютеры следовали за гораздо более медленным ростом традиционной индустриальной экономики , тем самым отвергая экстраполяции закона Мура на компьютеры 19-го века.

В статье 2007 года Шмидхубер заявил, что частота субъективно "заметных событий", по-видимому, приближается к сингулярности 21-го века, но предупредил читателей взять такие сюжеты субъективных событий с солью: возможно, различия в памяти о недавних и отдаленных событиях могут создать иллюзию ускорения изменений там, где их нет.

Пол Аллен утверждал противоположность ускоряющейся отдачи, тормоз сложности; чем больше прогресса наука делает к пониманию интеллекта, тем труднее становится сделать дополнительный прогресс. Исследование числа патентов показывает, что творчество человека не показывает ускоряющейся отдачи, но на самом деле, как предположил Джозеф Тейнтер в своем "крахе сложных обществ", закон убывающей отдачи . Число патентов на тысячу достигло максимума в период с 1850 по 1900 год и с тех пор сокращается. Рост сложности в конечном счете становится самоограничивающим и приводит к широко распространенному "краху общих систем".

Ярон Ланье опровергает идею, что сингулярность неизбежна. "Я не думаю, что технология создает сама себя. Это не автономный процесс. Он продолжает утверждать: "причина веры в человеческую агентуру над технологическим детерминизмом заключается в том, что тогда можно иметь экономику, где люди зарабатывают себе на жизнь и изобретают свою собственную жизнь. Если вы структурируете общество по Нет подчеркивая индивидуальную человеческую свободу действий, это то же самое, что и отрицание влияния, достоинства и самоопределения людей ... принять [идею сингулярности] было бы празднованием плохих данных и плохой политики."

Экономист Роберт Дж. Гордон, в взлет и падение темпов экономического роста в Америке: в США уровень жизни со времен Гражданской войны (2016), указывает на то, что измеряется экономический рост замедлился примерно в 1970 году и замедлился еще больше после финансового кризиса 2008 года, и утверждает, что экономические данные показывают никаких признаков грядущей сингулярности, как это представлялось по математике И. И. хороший.

В дополнение к общей критике концепции сингулярности, несколько критиков подняли проблемы с культовой диаграммой Курцвейла. Одна линия критики состоит в том, что логарифмическая диаграмма такого рода по своей природе склонна к прямолинейному результату. Другие определяют смещение выбора в точках, которые Курцвейл выбирает для использования. Например, биолог П. З. Майерс указывает, что многие из ранних эволюционных "событий" были выбраны произвольно.Курцвейл опроверг это, вычертив эволюционные события из 15 нейтральных источников и показав, что они соответствуют прямой линии на логарифмической диаграмме . Экономист издевались над концепцией с графической экстраполяцией, что количество лезвий на бритве, которое увеличилось за эти годы с одного до целых пяти, будет увеличиваться все быстрее и быстрее до бесконечности.

Воздействие[править]

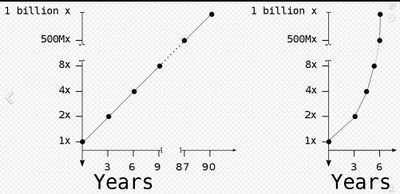

Резкие изменения в темпах экономического роста произошли в прошлом из-за некоторого технического прогресса. Основываясь на росте населения, экономика удваивается каждые 250 000 лет с эпохи палеолита до революции неолита. Новая сельскохозяйственная экономика удваивается каждые 900 лет, что является значительным увеличением. В нынешнюю эпоху, начиная с промышленной революции, мировое экономическое производство удваивается каждые пятнадцать лет в шестьдесят раз быстрее, чем в эпоху сельского хозяйства. Если рост сверхчеловеческого интеллекта вызовет подобную революцию, утверждает Робин Хэнсон, можно было бы ожидать, что экономика удвоится по крайней мере ежеквартально и, возможно, еженедельно.

Неопределенность и риск[править]

Дополнительная информация: экзистенциальный риск от искусственного общего интеллекта

Термин "технологическая сингулярность" отражает идею о том, что такое изменение может произойти внезапно, и что трудно предсказать, как будет действовать новый мир. неясно, будет ли взрыв интеллекта такого рода полезным или вредным, или даже экзистенциальной угрозой, , поскольку этот вопрос не рассматривался большинством исследователей искусственного общего интеллекта, хотя тема дружественного искусственного интеллекта исследуется будущим Института человечества и научно-исследовательского института машинного интеллекта .

Следующий шаг социобиологической эволюции[править]

Дополнительная информация: социокультурная эволюция

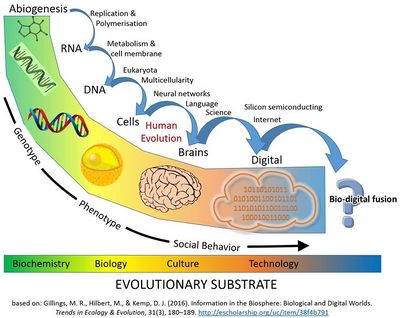

В то время как технологическая сингулярность обычно рассматривается как внезапное событие, некоторые ученые утверждают, что текущая скорость изменения уже соответствует этому описанию.

Кроме того, некоторые утверждают, что мы уже находимся в середине главного эволюционного перехода, который объединяет технологии, биологию и общество. Цифровая технология проникла в ткань человеческого общества до такой степени, что стала бесспорной и зачастую жизнеобеспечивающей зависимостью.

Статья 2016 года в Trends in Ecology & Evolution утверждает, что " люди уже охватывают слияния биологии и технологии. Большую часть времени бодрствования мы проводим, общаясь по цифровым каналам... мы доверяем искусственному интеллекту нашу жизнь через антиблокировочное торможение в автомобилях и автопилоты в самолетах... С одним из трех браков в Америке, начинающихся в интернете, цифровые алгоритмы также играют роль в связывании и размножении человеческих пар".

В статье далее утверждается , что с точки зрения эволюции несколько предыдущих крупных переходов в эволюции трансформировали жизнь посредством инноваций в области хранения и репликации информации ( РНК , ДНК , многоклеточности , культуры и языка ). На нынешнем этапе эволюции жизни Биосфера на основе углерода создала когнитивную систему (людей), способную создавать технологии, которые приведут к сопоставимому эволюционному переходу .

Цифровая информация, созданная людьми, достигла такого же масштаба, как биологическая информация в биосфере. С 1980-х годов количество хранящейся цифровой информации удваивалось примерно каждые 2,5 года и достигало примерно 5 зеттабайт в 2014 году (5x10^21 байт).

В биологическом плане на планете насчитывается 7,2 миллиарда человек, каждый из которых имеет геном в 6,2 миллиарда нуклеотидов. Поскольку один байт может кодировать четыре пары нуклеотидов, отдельные геномы каждого человека на планете могут быть закодированы примерно в 1x10^19 байт. В 2014 году в цифровой сфере хранилось в 500 раз больше информации, чем в 2014 году (см. рисунок). Общее количество ДНК, содержащейся во всех клетках на Земле, оценивается примерно в 5.3x10^37 пар оснований, эквивалентных 1.325x10^37 байт информации.

Если рост в цифровом хранении продолжится на своем настоящем тарифе 30-38% составного однолетнего роста в год, то он состязается полное содержание информации, Котор содержат в Всей из дна В всех клетках на Земле в около 110 летах. Это означало бы удвоение объема информации, хранящейся в биосфере в течение всего лишь 150-летнего периода времени".

Последствия для человеческого общества[править]

Дополнительная информация: искусственный интеллект в художественной литературе

В феврале 2009 года под эгидой Ассоциации по развитию искусственного интеллекта (AAAI) Эрик Хорвиц провел совещание ведущих компьютерных ученых, исследователей искусственного интеллекта и роботистов в Асиломаре в Пасифик-Гроув, Калифорния. Цель состояла в том, чтобы обсудить потенциальное влияние гипотетической возможности того, что роботы могут стать самодостаточными и способными принимать собственные решения. Они обсудили, в какой степени компьютеры и роботы могут получить автономию , и в какой степени они могут использовать такие способности для создания угроз или опасностей.

Некоторые машины запрограммированы с различными формами полуавтономии, включая способность находить их собственные источники питания и выбирать цели для атаки с оружием. Кроме того, некоторые компьютерные вирусы могут избежать уничтожения и, по мнению присутствующих ученых, поэтому можно сказать, что они достигли стадии "таракана" машинного интеллекта. Участники конференции отметили, что самосознание, описанное в научной фантастике, вероятно, маловероятно, но существуют и другие потенциальные опасности и ловушки.

Экзистенциальный риск[править]

Главная статья: экзистенциальный риск от искусственного интеллекта

Berglas (2008) утверждает, что нет прямой эволюционной мотивации для ИИ быть дружелюбным к людям. Эволюция не имеет врожденной тенденции к получению результатов, оцененных людьми, и мало оснований ожидать, что произвольный процесс оптимизации будет способствовать результату, желаемому человечеством, а не непреднамеренно приведет к тому, что ИИ будет вести себя так, как не предполагали его создатели (например, причудливый пример Ника Бострома AI, который был первоначально запрограммирован с целью изготовления скрепок для бумаги, так что, когда он достигает суперинтеллекта, он решает преобразовать всю планету в производство скрепки).

Андерс Сандберг также подробно остановился на этом сценарии, обратившись к различным общим контраргументам. исследователь ИИ Уго де Гарис предполагает, что искусственный интеллект может просто устранить человеческую расу для доступа к дефицитным ресурсам, , и люди были бы бессильны остановить их. в качестве альтернативы, ИИ развивались под эволюционным давлением, чтобы способствовать их собственному выживанию, могли вытеснить человечество.

Bostrom (2002) обсуждает сценарии человеческого вымирания и перечисляет суперинтеллекта как возможную причину:

- Когда мы создаем первое сверхразумное существо, мы можем совершить ошибку и поставить перед ним цели, которые приведут его к уничтожению человечества, предполагая, что его огромное интеллектуальное преимущество даст ему возможность сделать это. Например, мы можем ошибочно возвести подцель в статус сверхцели. Мы говорим ему решить математическую задачу, и он подчиняется, превращая всю материю в Солнечной системе в гигантское вычислительное устройство, в процессе убивая человека, который задал вопрос.

Существенная проблема заключается в том, что недружественный искусственный интеллект, вероятно, будет гораздо легче создать, чем дружественный ИИ. В то время как оба требуют больших успехов в разработке рекурсивного процесса оптимизации, дружественный ИИ также требует способности сделать целевые структуры инвариантными в отношении самосовершенствования (или ИИ может превратиться во что-то недружественное) и целевую структуру, которая согласуется с человеческими ценностями и автоматически не уничтожает человеческую расу. Недружественный ИИ, с другой стороны, может оптимизировать для произвольной целевой структуры, которая не должна быть инвариантной при самомодификации.

Элиэзер Юдковски предложил провести исследования для создания дружественного искусственного интеллекта с целью устранения опасностей. Он отметил, что первый реальный ИИ будет иметь преимущество в самосовершенствовании и, если он будет дружелюбным, может предотвратить развитие недружественных ИИ, а также обеспечить огромные выгоды для человечества.

Билл Хиббард (2014) предлагает дизайн ИИ, который избегает нескольких опасностей, включая самообман, непреднамеренные инструментальные действия, и коррупцию генератора вознаграждения. он также обсуждает социальные воздействия ИИ и тестирование ИИ. его книга 2001 года Super-Intelligent Machines защищает потребность в общественном образовании об ИИ и общественном контроле над ИИ. Он также предложил простую конструкцию, которая была уязвима для коррупции генератора вознаграждения.

Один гипотетический подход к попытке управления искусственным интеллектом-это ящик ИИ, где искусственный интеллект удерживается внутри моделируемого мира и не может влиять на внешний мир. Тем не менее, достаточно умный ИИ может просто убежать, перехитрив своих менее умных человеческих похитителей.

Стивен Хокинг сказал в 2014 году, что " успех в создании ИИ будет самым большим событием в истории человечества. К сожалению, он может оказаться и последним, если мы не научимся избегать рисков. Хокинг полагал, что в ближайшие десятилетия ИИ может предложить "неисчислимые выгоды и риски", такие как "технологии, перехитряющие финансовые рынки, изобретающие человеческие исследователи, манипулирующие человеческими лидерами и разрабатывающие оружие, которое мы даже не можем понять."Хокинг полагал, что больше должно быть сделано, чтобы подготовиться к сингулярности:

- Таким образом, сталкиваясь с возможными будущими неисчислимыми выгодами и рисками, эксперты, безусловно, делают все возможное, чтобы обеспечить наилучший результат, не так ли? Неправильный. Если бы высшая инопланетная цивилизация послала нам сообщение: "мы прибудем через несколько десятилетий", мы бы просто ответили: "хорошо, позвоните нам, когда вы приедете сюда, мы оставим свет включенным"? Вероятно, нет – но это более или менее то, что происходит с ИИ.

Жесткий против мягкого взлета[править]

В сценарии жесткого взлета AGI быстро самосовершенствуется," беря под контроль " мир (возможно, в течение нескольких часов), слишком быстро для значительной коррекции ошибок, инициированных человеком, или для постепенной настройки целей AGI. В сценарии мягкого взлета AGI по-прежнему становится намного более мощным, чем человечество, но в человеческом темпе (возможно, порядка десятилетий), на временной шкале, где продолжающееся человеческое взаимодействие и коррекция могут эффективно управлять развитием AGI.

Рамез Наам возражает против жесткого взлета, указывая, что мы уже видим рекурсивное самосовершенствование суперинтеллектами, такими как корпорации. Например, Intel обладает " коллективным мозгом десятков тысяч людей и, вероятно, миллионов процессорных ядер.. дизайн лучше процессоров!"Однако это не привело к жесткому взлету; скорее, это привело к мягкому взлету в форме закона Мура . Наам далее указывает, что вычислительная сложность более высокого интеллекта может быть намного больше, чем линейная, так что " создание разума интеллекта 2, вероятно, больше более чем в два раза сложнее, чем создание разума интеллекта 1."

J. Storrs Hall считает, что " многие из наиболее часто встречающихся сценариев для ночного жесткого взлета являются круговыми – они, похоже, предполагают сверхчеловеческие возможности в начальной точке процесса самосовершенствования " для того, чтобы ИИ мог сделать драматические, общие для домена улучшения, необходимые для взлета. Холл предполагает, что вместо рекурсивного самосовершенствования своего оборудования, программного обеспечения и инфраструктуры самостоятельно, неоперившийся ИИ будет лучше специализироваться в одной области, где он был наиболее эффективным, а затем покупать остальные компоненты на рынке, потому что качество продуктов на рынке постоянно улучшается, и ИИ будет иметь трудное время идти в ногу с передовыми технологиями, используемыми остальным миром.

Бен Герцель согласен с предположением Холла о том, что новый ИИ человеческого уровня будет хорошо использовать свой интеллект для накопления богатства. Таланты ИИ могут вдохновить компании и правительства на распространение своего программного обеспечения по всему обществу. Герцель скептически относится к очень тяжелому, 5-минутному взлету, но думает, что взлет от человека до сверхчеловеческого уровня порядка 5 лет является разумным. Он называет это "полусердечным взлетом".

Макс больше не соглашается, утверждая, что если бы было только несколько сверхбыстрых ИИ человеческого уровня, они не изменили бы радикально мир, потому что они все еще зависели бы от других людей, чтобы сделать вещи и все еще имели бы человеческие когнитивные ограничения. Даже если бы все сверхбыстрые ИИ работали над повышением интеллекта, неясно, почему они будут работать лучше прерывистым способом, чем существующие ученые-когнитивисты по производству сверхчеловеческого интеллекта, хотя скорость прогресса будет увеличиваться. Мор также утверждает, что суперинтеллект не изменит мир за одну ночь, потому что суперинтеллект должен будет взаимодействовать с существующими, медленными человеческими системами для достижения физического воздействия на мир. "Необходимость сотрудничества, организации и внесения идей в физические изменения гарантирует, что все старые правила не будут выброшены в одночасье или даже в течение нескольких лет ."

Бессмертие[править]

В своей книге 2005 года "сингулярность рядом" Курцвейл предполагает, что медицинские достижения позволят людям защитить свои тела от последствий старения, делая продолжительность жизни безграничной . Курцвейл утверждает, что технический прогресс в медицине позволит нам постоянно восстанавливать и заменять дефектные компоненты в нашем организме, продлевая жизнь до неопределенного возраста.Курцвейл еще больше подкрепляет свои аргументы, обсуждая современные достижения биоинженерии. Курцвейл предлагает соматическую генную терапию после синтетических вирусов со специфической генетической информацией следующим шагом будет применение этой технологии в генной терапии, замена ДНК человека синтезированными генами .

К. Эрик Дрекслер , один из основоположников нанотехнологии, постулировал устройства для ремонта клеток , в том числе работающие в клетках и использующие пока еще гипотетические биологические машины, в своей книге 1986 года "двигатели творения".

По словам Ричарда Фейнмана, именно его бывший аспирант и сотрудник Альберт Хиббс первоначально предложил ему (около 1959 года) идею медицинского использования теоретических микромашин Фейнмана. Хиббс предположил, что в один прекрасный день некоторые ремонтные машины могут быть уменьшены в размерах до такой степени, что теоретически возможно (как выразился Фейнман) " проглотить доктора ". Идея была включена в эссе Фейнмана 1959 года есть много места внизу .

Помимо простого продления операционной жизни физического тела, Ярон Ланье приводит доводы в пользу формы бессмертия, названного "цифровым Вознесением", которое вовлекает"людей, умирающих во плоти и загружаемых в компьютер и остающихся сознательными".

История концепции[править]

В некрологе 1958 года для Джона фон Неймана Улам вспоминал разговор с фон Нейманом о " постоянно ускоряющемся прогрессе технологий и изменениях в образе жизни человека, который дает видимость приближения к некоторой существенной особенности в истории расы, за которой человеческие дела, как мы их знаем, не могли продолжаться."

В 1965 году Гуд написал эссе, в котором постулировал" интеллектуальный взрыв " рекурсивного самосовершенствования машинного интеллекта.

В 1981 году Станислав Лем опубликовал научно-фантастический роман "Голем XIV". Он описывает военный компьютер AI (Golem XIV), который получает сознание и начинает увеличивать свой собственный интеллект, двигаясь к личной технологической сингулярности. Голем XIV был первоначально создан, чтобы помочь своим строителям в борьбе с войнами, но по мере того, как его интеллект продвигается на гораздо более высокий уровень, чем у людей, он перестает интересоваться военными требованиями, потому что находит их не хватает внутренней логической последовательности.

В 1983 Вернор Виндж широко популяризировал интеллектуальный взрыв Гуда во многих письмах, сначала обращаясь к теме в печати в январском номере журнала Omni 1983 года. В этой статье Виндж, кажется, был первым, кто использовал термин "сингулярность" таким образом, который был конкретно связан с созданием интеллектуальных машин:

- Мы скоро создадим разумы, превосходящие наш собственный. Когда это произойдет, человеческая история достигнет своего рода сингулярности, интеллектуального перехода, столь же непроницаемого, как узловатое пространство-время в центре черной дыры, и мир выйдет далеко за пределы нашего понимания. Эта особенность, я полагаю, уже преследует многих писателей-фантастов. Это делает невозможной реалистичную экстраполяцию на межзвездное будущее. Чтобы написать историю, которая начнется более чем через столетие, нужна ядерная война ... так что мир остается понятным.

В 1985 г. в "время масштабы искусственного интеллекта" Искусственный интеллект исследователь Рэй Solomonoff сформулированы математически, связанных с понятием так называемой "точки бесконечности": если научное сообщество человеческого уровня, самосовершенствованию назначения займет четыре года, чтобы удвоить свою скорость, то два года, затем год и так далее, их возможности бесконечно наращивать за конечное время.

Статья Винге 1993 года "грядущая технологическая сингулярность: как выжить в постчеловеческую эпоху" широко распространилась в интернете и помогла популяризировать идею.Эта статья содержит утверждение: "в течение тридцати лет у нас будут технологические средства для создания сверхчеловеческого интеллекта. Вскоре после этого человеческая эра закончится. Виндж утверждает, что авторы научной фантастики не могут написать реалистичных персонажей пост-сингулярности, которые превосходят человеческий интеллект, поскольку мысли такого интеллекта были бы вне способности людей выражать.

В 2000 году Билл Джой , выдающийся технолог и соучредитель Sun Microsystems, выразил обеспокоенность потенциальными опасностями сингулярности.

В 2005 году Курцвейл опубликовал сингулярность рядом . Рекламная кампания Курцвейла включала появление на ежедневном шоу с Джоном Стюартом .

В 2007 году Элиэзер Юдковски предположил, что многие из различных определений, которые были присвоены "сингулярности", являются взаимно несовместимыми, а не взаимоподдерживающими. например, Курцвейл экстраполирует текущие технологические траектории мимо прибытия самосовершенствующегося ИИ или сверхчеловеческого интеллекта, который, по мнению Юдковского, представляет собой напряженность с предлагаемым И. Дж.Гудом прерывистым подъемом интеллекта и тезисом Винджа о непредсказуемости.

В 2009 году Курцвейл и основатель X-Prize Питер Диамандис объявили о создании Singularity University, некредитованного частного института, миссия которого заключается в "обучении, вдохновении и расширении возможностей лидеров применять экспоненциальные технологии для решения великих проблем человечества." финансируемый Google , Autodesk , Eplanet Ventures и группой лидеров технологической отрасли, университет сингулярности базируется в Исследовательском центре НАСА в Маунтин-Вью, Калифорния. Некоммерческая организация запускает ежегодную десятилетнюю программу выпускников в течение лета, которая охватывает десять различных технологий и смежных треков, а также ряд исполнительных программ в течение года.

В политике[править]

В 2007 году Объединенный экономический комитет Конгресса США опубликовал доклад о будущем нанотехнологий. Он прогнозирует значительные технологические и политические изменения в среднесрочной перспективе, включая возможную технологическую сингулярность.

Бывший президент США Барак Обама говорил об сингулярности в своем интервью Wired в 2016 году:

- Одна вещь, о которой мы не говорили слишком много, и я просто хочу вернуться к ней, это то, что нам действительно нужно продумать экономические последствия. Потому что большинство людей сейчас не тратят много времени на беспокойство о сингулярности—они беспокоятся о том, что "ну, моя работа будет заменена машиной?"

См. также[править]

- Ускорение изменений-воспринимаемое увеличение темпов технологических изменений на протяжении всей истории

- Искусственное сознание

- Гонка вооружений искусственного интеллекта

- Искусственный интеллект в художественной литературе

- Моделирование мозга

- Экзокортекс

- Парадокс Ферми-очевидное противоречие между отсутствием доказательств и высокой вероятностью оценки существования внеземных цивилизаций

- Эффект Флинна

- Будущее исследование

- Глобальный мозг

- Человеческий интеллект § улучшение интеллекта

- Загрузка разума

- Нейроусиление

- Очерк трансгуманизма-список ссылок на статьи Википедии, связанные с темой трансгуманизма

- Постбиологическая эволюция

- Обучение роботов

- Сингуляритаризм

- Технологический детерминизм

- Технологическая революция

- Технологическая безработица

- Вездесущий город

Дальнейшее чтение[править]

- Маркус, Гэри, " Я Человек?: Исследователям нужны новые способы отличить искусственный интеллект от естественного вида", Scientific American , vol. 316, нет. 3 (март 2017), стр. 58-63. Необходимы многочисленные тесты эффективности искусственного интеллекта, потому что " так же, как нет ни одного теста на спортивное мастерство, не может быть одного окончательного теста интеллекта."Один из таких тестов, "строительный вызов", будет проверять восприятие и физическое действие- " два важных элемента интеллектуального поведения, которые полностью отсутствовали в исходном тесте Тьюринга."Еще одно предложение-дать машинам такие же стандартизированные тесты науки и других дисциплин, которые проходят школьники. До сих пор непреодолимым камнем преткновения для искусственного интеллекта является неспособность к надежному разрешению неоднозначности . "Фактически каждое предложение , которое генерируют люди, неоднозначно, часто по-разному."Выдающийся пример известен как" проблема устранения неоднозначности местоимения": у машины нет способа определить, к кому или к чему относится местоимение в предложении, например" он"," она "или"это".

- Scaruffi, Piero," интеллект не является искусственным " (2016) для критики движения сингулярности и его сходства с религиозными культами.

- да Сильва, Уилсон, " переломный момент?"(2009) для эссе о движении сингулярности и его научной обоснованности.